网络抓取与网络爬取

在当今时代,根据数据情况来制定业务决策是许多公司的头等大事。为了推动这些决策,公司全天候跟踪,监视和记录相关数据。幸运的是,很多网站的服务器上存储了大量公共数据,可以帮助企业在竞争激烈的市场中保持领先地位。

很多公司出于业务目的会去各个网站上提取数据,这种情况已经很普遍。但是,手动的提取操作并不能在获取数据后方便快捷地将数据应用到您的日常工作中去。因此,在本文中,小Oxy将为大家介绍网络数据提取的方式以及需要面对的难点,并向您介绍几种解决方案,这些解决方案可以帮助您更好地爬取数据。

数据提取的方式

如果您不是一个精通网络技术的人,那么数据提取似乎是一件非常复杂且不可理解的事情。但是,了解整个过程并不那么复杂。

从网站提取数据的过程称为网络抓取,有时也被称为网络收集。该术语通常是指使用机器人或网络爬虫自动提取数据的过程。有时,网络抓取的概念与网络爬取的概念容易混淆。因此,我们在之前的文章中介绍了有关网络爬网和网络抓取之间的主要区别的问题。

今天,我们就来讨论下数据提取的整个过程,以充分了解数据提取的工作原理。

数据提取的工作原理

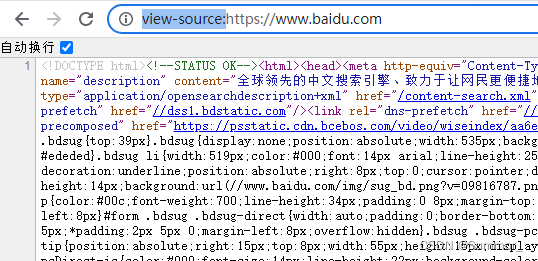

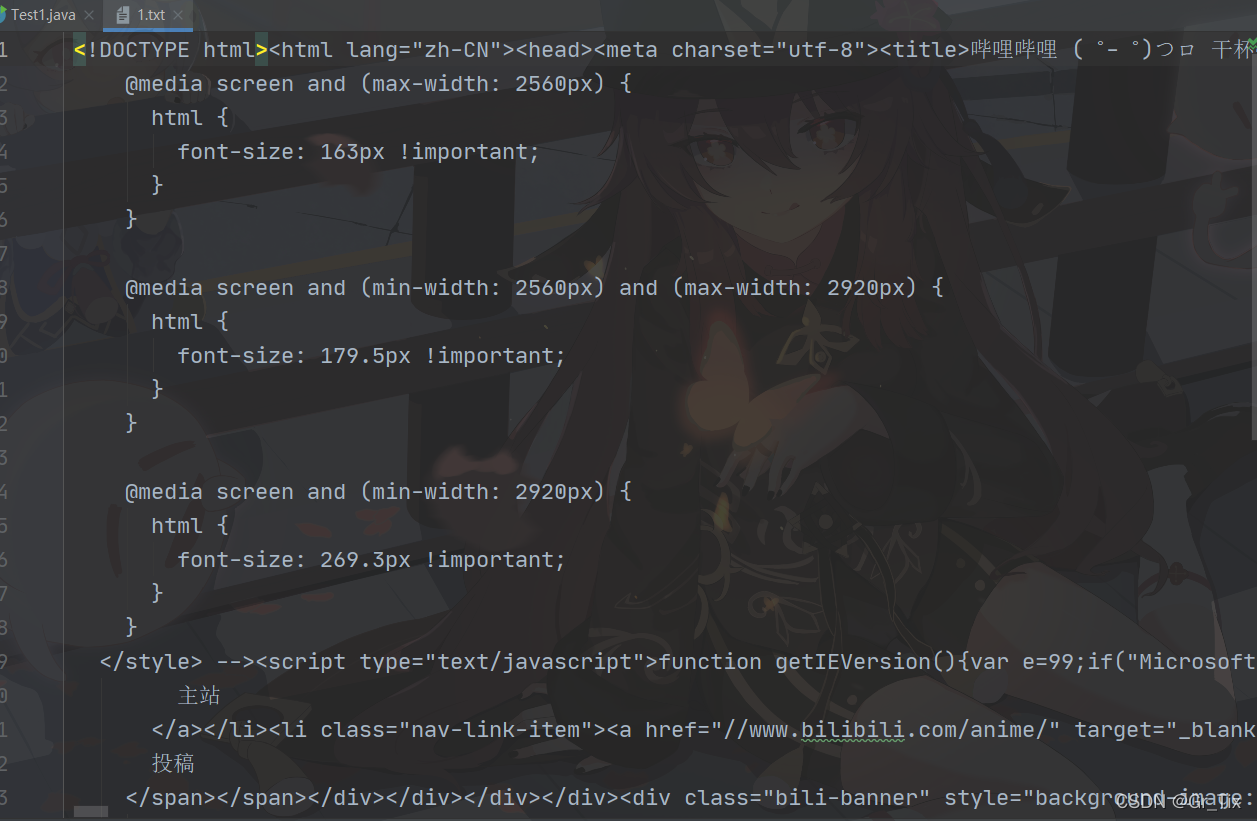

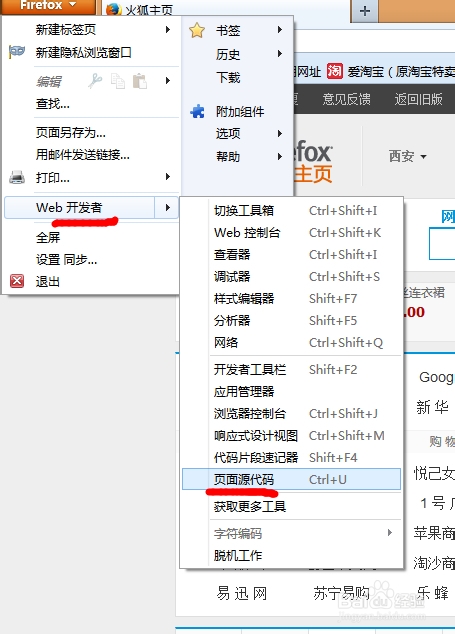

如今,我们抓取的数据主要以HTML(一种基于文本的标记语言)表示。它通过各种组件定义网站内容的结构,包括<p>,<table>和<title>之类的标签。开发人员能够用脚本从任何形式的数据结构中提取数据。

构建数据提取脚本

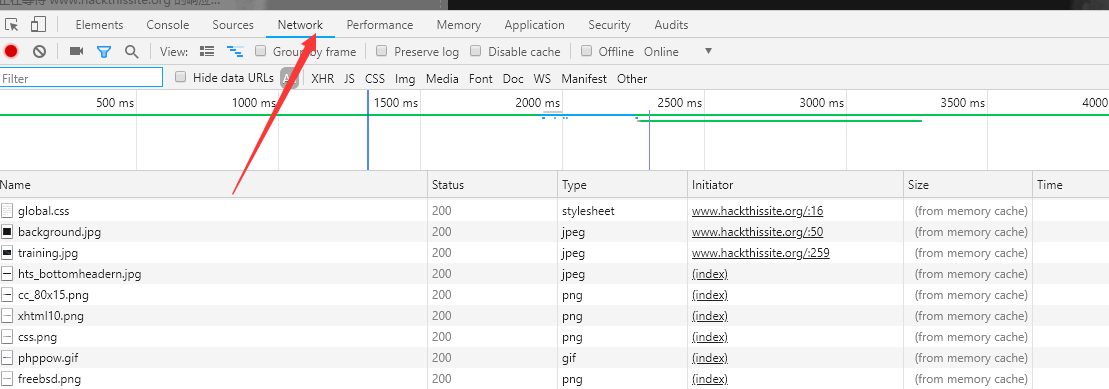

一切都始于构建数据提取脚本。精通Python等编程语言的程序员可以开发数据提取脚本,即所谓的scraper bots。Python的优势,例如多样化的库,简单性和活跃的社区,使其成为编写Web抓取脚本的最受欢迎的编程语言。这些脚本可以实现完全自动化的数据提取。他们向服务器发送请求,访问选定的URL,遍历每个先前定义的页面,HTML标记和组件。然后,从这些地方提取数据。

开发各种数据爬取模式

可以对数据提取脚本进行个性化开发,可以实现仅从特定的HTML组件中提取数据。您需要提取的数据取决于您的业务目标。当您仅需要特定数据时,就不必提取所有内容。这也将减轻服务器的负担,减少存储空间要求,并使数据处理更加容易。

设置服务器环境

要持续运行网络抓取工具,您需要一台服务器。因此,下一步就是投资服务器等基础设施,或从已建立的公司租用服务器。服务器是必不可少的,因为它们允许您每周7天,每天24小时不间断地运行数据提取脚本并简化数据记录和存储。

确保有足够的存储空间

数据提取脚本的交付内容是数据。大规模数据需要很大的存储容量。从多个网站提取数据可转换成数千个网页。由于该过程是连续的,因此最终将获得大量数据。确保有足够的存储空间来维持您的抓取操作非常重要。

数据处理

采集的数据以原始形式出现,可能很难被人所理解。因此,解析和创建结构良好的结果是任何数据收集过程的下一个重要组成部分。

数据提取工具

有多种方法可以从网页提取公共数据-构建内部工具或使用即用型网络抓取解决方案,例如Oxylabs Real-Time Crawler。

内部解决方案

如果您的公司拥有一支经验丰富的开发人员和汇聚资源的专门团队,则构建内部数据提取工具可能是一个不错的选择。但是,大多数网站或搜索引擎都不希望泄露其数据,并且已经建立了检测类似机器人行为的算法,因此使得抓取更具挑战性。

以下是如何从网络提取数据的主要步骤:

1.确定要获取和处理的数据类型。

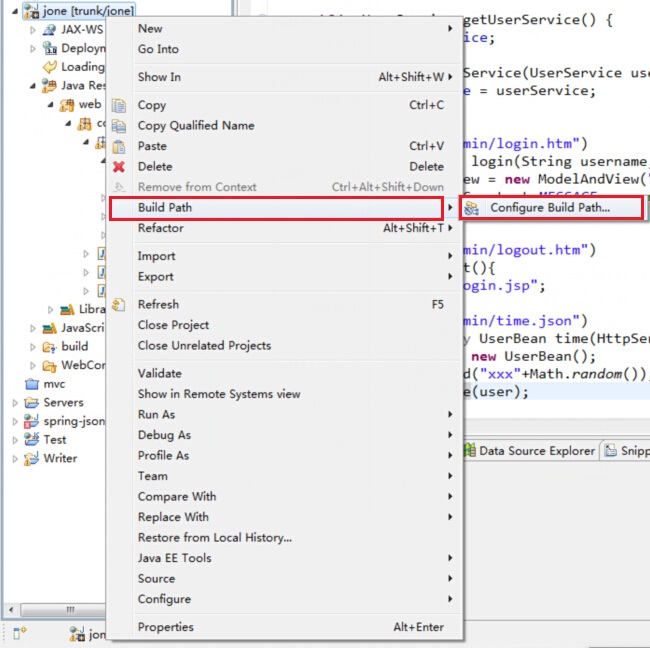

2.查找数据的显示位置,并构建一个抓取路径。

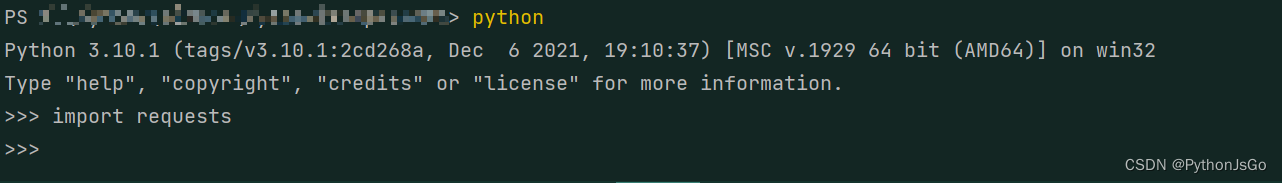

3.导入并安装所需的先决环境。

4.编写一个数据提取脚本并实现它。

为了避免IP阻塞,模仿常规互联网用户的行为至关重要。这就是代理需要介入的地方,介入后,使所有数据收集任务变得更加容易。我们在接下来的内容中会继续讨论。

Real-Time Crawler

Real-Time Crawler之类的工具的主要优点之一就是能够帮助您从具有挑战性的目标中提取公共数据而无需额外的资源。大型搜索引擎或电子商务网页利用了复杂的反机器人算法。因此,从它们那里提取数据需要额外的开发时间。

内部解决方案必须通过反复试验来创建变通办法,这意味着不可避免的效率降低,IP地址被阻塞以及定价数据流不可靠。使用实时抓取工具,该过程是完全自动化的。您的员工不必无休止地复制粘贴,而可以专注于更紧迫的事务,而直接进行数据分析。

网络数据提取的好处

大数据是商业圈中一个新的流行语。它涵盖了以目标为导向的一些数据收集过程-获得有意义的见解,识别趋势和模式以及预测经济状况。例如,网络抓取房地产数据有助于分析有哪些因素可以影响该行业。同样,抓取汽车工业行业的数据中也很有用。企业会收集汽车行业数据,例如用户和汽车零件评论等。

各行各业的公司都从网站提取数据,以更新数据的相关度和实时度。其他网站也会这么做,以确保数据集完整。数据越多越好,这样可以提供更多的参考并使整个数据集更有效。

企业要提取哪些数据

如前所述,并非所有在线数据都是提取的目标。在决定提取哪些数据时,您的业务目标,需求和目标应作为主要考虑因素。

可能有许多您可能感兴趣的数据目标。您可以提取产品说明,价格,客户评论和评级,常见问题解答页面,操作指南等。您还可以自定义定制数据提取脚本以定位新产品和服务。只需执行任何抓取活动之前,确保您抓取公共数据并没有违反任何第三方权利。

常见数据提取挑战

网站数据提取并非没有挑战。最常见的是:

- 资源和知识。数据收集需要大量资源和专业技能。如果公司决定开始网络抓取,则他们需要开发特定的基础结构,编写抓取代码并监督整个过程。它需要开发人员,系统管理员和其他专家组成的团队。

- 保持数据质量。全面保持数据质量至关重要。同时,由于数据量和数据类型的不同,在大规模数据操作中也变得充满挑战。

- 防抓取技术。为了确保为其消费者提供最佳的购物体验,电子商务网站实施了各种防抓取解决方案。在网页抓取中,最重要的部分之一是模仿自然的用户行为。如果您在短时间内发送太多请求或忘记处理HTTP cookie,则服务器可能会检测到僵尸程序并封锁您的IP。

- 大规模抓取作业。电子商务网站会定期更新其结构,要求您不断更新数据提取脚本。价格和库存也会不断变化,您需要保持数据提取脚本始终运行。

数据抓取的最佳做法

想要解决上述问题,可以通过经验丰富的专业人员开发的复杂数据提取脚本来解决。但是,这仍然使您面临被防抓取技术拾取和阻挡的风险。这就需要改变游戏规则的解决方案-代理。更确切地说,IP轮换代理。

IP轮换代理将为您提供访问大量IP地址的权限。从位于不同地理区域的IP发送请求将欺骗服务器并防止封锁。另外,您可以使用代理轮换器。代理轮换器将使用代理数据中心池中的IP并自动分配它们,而不是手动分配IP。

如果您没有足够的资源和经验丰富的开发团队来进行网络抓取,那么该考虑使用现成的解决方案了,如Real-Time Crawler。它确保能从搜索引擎和电子商务网站100%完成抓取任务,并简化数据管理和汇总数据,以便您轻松理解。

从网站提取数据是否合法

许多企业依赖大数据,需求显著增长。根据Statista的研究统计,大数据市场每年都在急剧增长,预计到2027年将达到1,030亿美元。这导致越来越多的企业将网络抓取作为最常见的数据收集方法之一。这种受欢迎程度引发了一个广泛讨论的问题,即网络抓取是否合法。

由于这个复杂的主题没有确定的答案,因此必须确保将要进行的任何网络抓取操作都不违反相关的法律。更重要的是,在进行任何数据抓取之前,我们强烈建议针对具体情况寻求专业的法律咨询。

另外,除非您获得目标网站的明确许可,否则我们强烈建议您不要抓取任何非公开数据。

小Oxy提醒您:本文中写的任何内容都不应解读为抓取任何非公开数据的建议。

结论

总结起来,您将需要一个数据提取脚本来从网站中提取数据。如您所见,由于操作范围,复杂性和不断变化的网站结构,构建这些脚本可能具有挑战性。不过即便有好的脚本,想要长时间实时抓取数据而不被封IP,您还是需要使用轮换代理来变化您的IP。

如果您认为您的企业需要一种使数据提取变得轻松的全能解决方案,则可以立即注册并开始使用Oxylabs的Real-Time Crawler。

如果您有任何问题,可以随时和我们联系。