背景

SaaS 服务未来会面临数据安全、合规等问题。公司的业务需要沉淀一套私有化部署能力,帮助业务提升行业竞争力。为了完善平台系统能力、我们需要沉淀一套数据体系帮助运营分析活动效果、提升运营能力。然而在实际的开发过程中,如果直接部署一套大数据体系,对于使用者来说将是一笔比较大的服务器开销。为此我们选用折中方案完善数据分析能力。

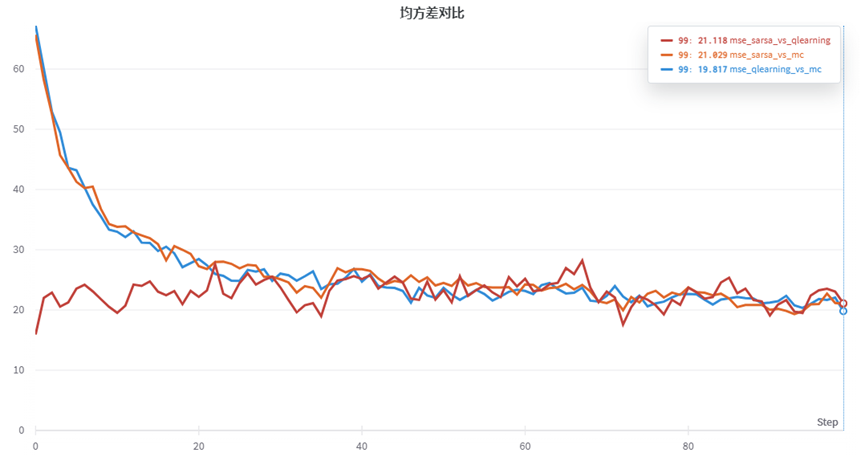

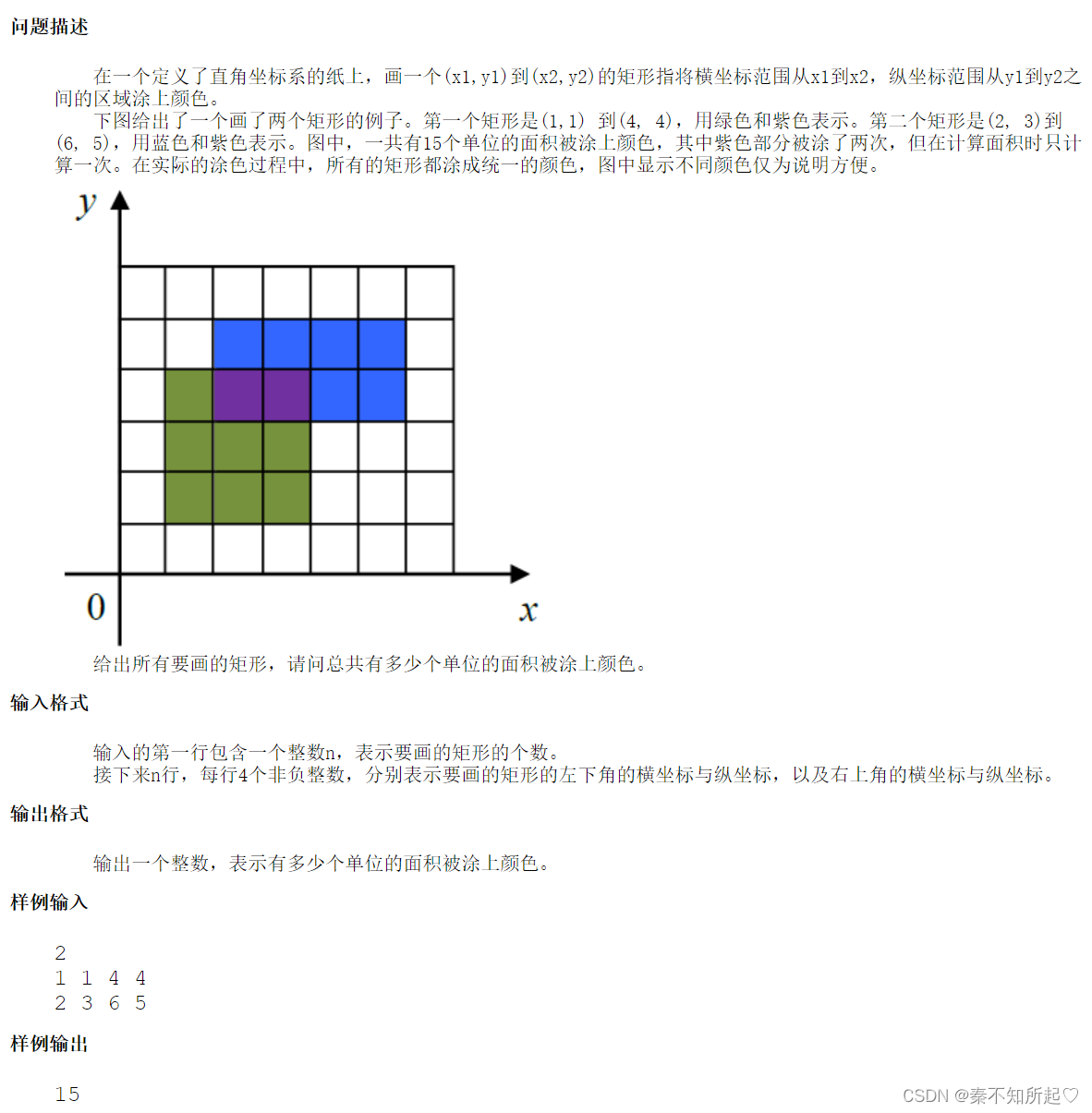

1、elasticsearch vs clickhouse

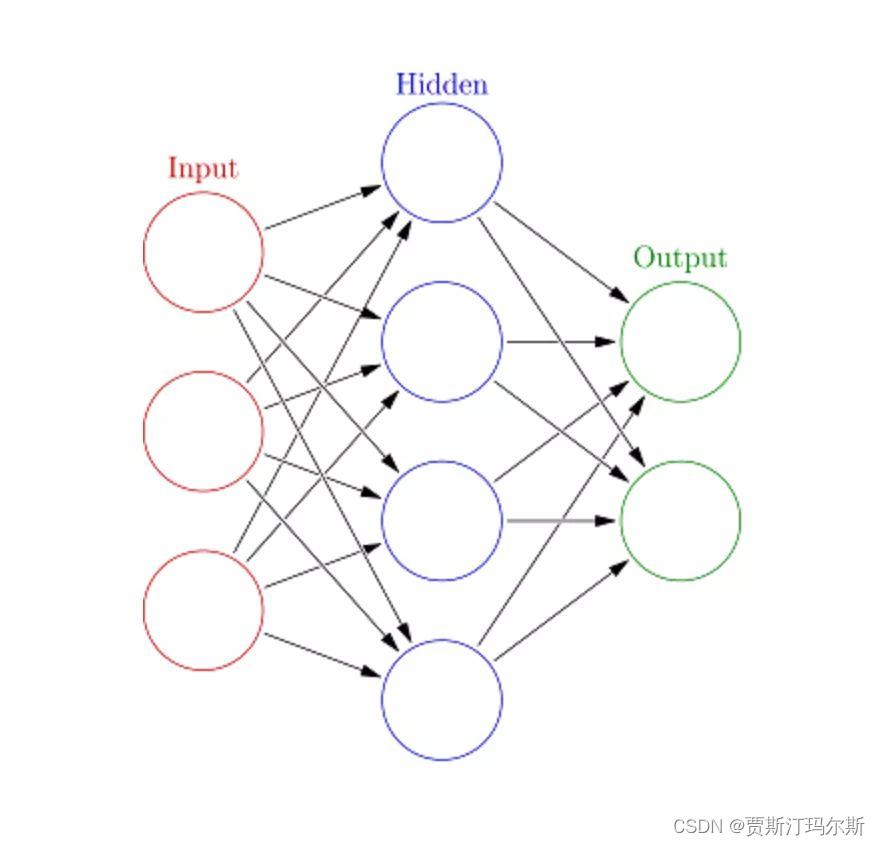

ClickHouse 是一款高性能列式分布式数据库管理系统,我们对 ClickHouse 进行了测试,发现有以下优势:

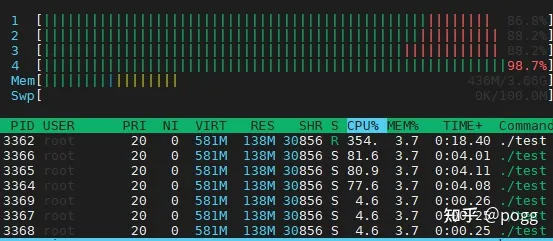

ClickHouse 写入吞吐量大,单服务器日志写入量在 50MB 到 200MB/s,每秒写入超过 60w 记录数,是 ES 的 5 倍以上。在 ES 中比较常见的写 Rejected 导致数据丢失、写入延迟等问题,在 ClickHouse 中不容易发生。

查询速度快,官方宣称数据在 pagecache 中,单服务器查询速率大约在2-30GB/s;没在 pagecache 的情况下,查询速度取决于磁盘的读取速率和数据的压缩率。经测试 ClickHouse 的查询速度比 ES 快 5-30 倍以上。

CH 比 ES 服务器成本更低。一方面 CH 的数据压缩比 ES 高,相同数据占用的磁盘空间只有 ES 的 1/3 到 1/30,节省了磁盘空间的同时,也能有效的减少磁盘IO,这也是 CH 查询效率更高的原因之一;另一方面 CH 比 ES 占用更少的内存,消耗更少的 CPU 资源。我们预估用 ClickHouse 处理日志可以将服务器成本降低一半。

2、成本分析

备注:在没有任何折扣的情况下,基于aliyun分析

3、环境部署

a) zookeeper 集群部署

yum install java-1.8.0-openjdk-devel.x86_64/etc/profile 配置环境变量更新系统时间yum install ntpdatentpdate asia.pool.ntp.orgmkdir zookeepermkdir ./zookeeper/datamkdir ./zookeeper/logswget --no-check-certificate https://mirrors.tuna.tsinghua.edu.cn/apache/zookeeper/zookeeper-3.7.1/apache-zookeeper-3.7.1-bin.tar.gztar -zvxf apache-zookeeper-3.7.1-bin.tar.gz -C /usr/zookeeperexport ZOOKEEPER_HOME=/usr/zookeeper/apache-zookeeper-3.7.1-binexport PATH=$ZOOKEEPER_HOME/bin:$PATH进入ZooKeeper配置目录cd $ZOOKEEPER_HOME/conf新建配置文件vi zoo.cfgtickTime=2000initLimit=10syncLimit=5dataDir=/usr/zookeeper/datadataLogDir=/usr/zookeeper/logsclientPort=2181server.1=zk1:2888:3888server.2=zk2:2888:3888server.3=zk3:2888:3888在每台服务器上执行,给zookeeper创建myidecho "1" > /usr/zookeeper/data/myidecho "2" > /usr/zookeeper/data/myidecho "3" > /usr/zookeeper/data/myid进入ZooKeeper bin目录cd $ZOOKEEPER_HOME/binsh zkServer.sh start

b) Kafka 集群部署

mkdir -p /usr/kafkachmod 777 -R /usr/kafkawget --no-check-certificate https://mirrors.tuna.tsinghua.edu.cn/apache/kafka/3.2.0/kafka_2.12-3.2.0.tgztar -zvxf kafka_2.12-3.2.0.tgz -C /usr/kafka不同的broker Id 设置不一样,比如 1,2,3broker.id=1listeners=PLAINTEXT://ip:9092socket.send.buffer.bytes=102400socket.receive.buffer.bytes=102400socket.request.max.bytes=104857600log.dir=/usr/kafka/logsnum.partitions=5num.recovery.threads.per.data.dir=3offsets.topic.replication.factor=2transaction.state.log.replication.factor=3transaction.state.log.min.isr=3log.retention.hours=168log.segment.bytes=1073741824log.retention.check.interval.ms=300000zookeeper.connect=zk1:2181,zk2:2181,zk3:2181zookeeper.connection.timeout.ms=30000group.initial.rebalance.delay.ms=0后台常驻进程启动kafkanohup /usr/kafka/kafka_2.12-3.2.0/bin/kafka-server-start.sh /usr/kafka/kafka_2.12-3.2.0/config/server.properties >/usr/kafka/logs/kafka.log >&1 &/usr/kafka/kafka_2.12-3.2.0/bin/kafka-server-stop.sh$KAFKA_HOME/bin/kafka-topics.sh --list --bootstrap-server ip:9092$KAFKA_HOME/bin/kafka-console-consumer.sh --bootstrap-server ip:9092 --topic test --from-beginning$KAFKA_HOME/bin/kafka-topics.sh --create --bootstrap-server ip:9092 --replication-factor 2 --partitions 3 --topic xxx_data

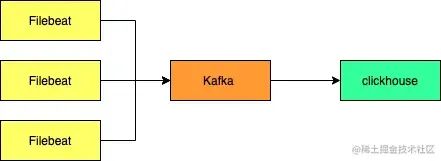

c) FileBeat 部署

sudo rpm --import https://packages.elastic.co/GPG-KEY-elasticsearchCreate a file with a .repo extension (for example, elastic.repo) in your /etc/yum.repos.d/ directory and add the following lines:在/etc/yum.repos.d/ 目录下创建elastic.repo[elastic-8.x]name=Elastic repository for 8.x packagesbaseurl=https://artifacts.elastic.co/packages/8.x/yumgpgcheck=1gpgkey=https://artifacts.elastic.co/GPG-KEY-elasticsearchenabled=1autorefresh=1type=rpm-mdyum install filebeatsystemctl enable filebeatchkconfig --add filebeat

FileBeat 配置文件说明,坑点1(需设置keys_under_root: true)。如果不设置kafka的消息字段如下:

文件目录:/etc/filebeat/filebeat.ymlfilebeat.inputs:- type: logenabled: truepaths:- /root/logs/xxx/inner/*.logjson:如果不设置该索性,所有的数据都存储在message里面,这样设置以后数据会平铺。keys_under_root: trueoutput.kafka:hosts: ["kafka1:9092", "kafka2:9092", "kafka3:9092"]topic: 'xxx_data_clickhouse'partition.round_robin:reachable_only: falserequired_acks: 1compression: gzipprocessors:剔除filebeat 无效的字段数据- drop_fields:fields: ["input", "agent", "ecs", "log", "metadata", "timestamp"]ignore_missing: falsenohup ./filebeat -e -c /etc/filebeat/filebeat.yml > /user/filebeat/filebeat.log &输出到filebeat.log文件中,方便排查

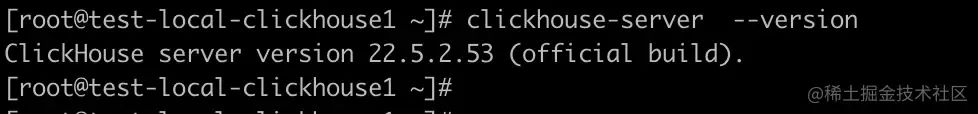

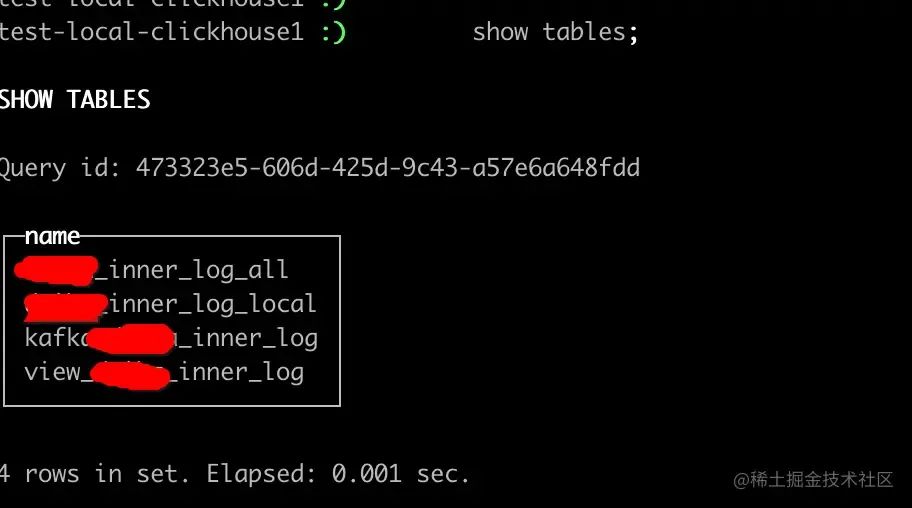

d) clickhouse 部署

检查当前CPU是否支持SSE 4.2,如果不支持,需要通过源代码编译构建grep -q sse4_2 /proc/cpuinfo && echo "SSE 4.2 supported" || echo "SSE 4.2 not supported"返回 "SSE 4.2 supported" 表示支持,返回 "SSE 4.2 not supported" 表示不支持创建数据保存目录,将它创建到大容量磁盘挂载的路径mkdir -p /data/clickhouse修改/etc/hosts文件,添加clickhouse节点举例:10.190.85.92 bigdata-clickhouse-0110.190.85.93 bigdata-clickhouse-02服务器性能参数设置:cpu频率调节,将CPU频率固定工作在其支持的最高运行频率上,而不动态调节,性能最好echo 'performance' | tee /sys/devices/system/cpu/cpu*/cpufreq/scaling_governor内存调节,不要禁用 overcommitecho 0 | tee /proc/sys/vm/overcommit_memory始终禁用透明大页(transparent huge pages)。它会干扰内存分配器,从而导致显着的性能下降echo 'never' | tee /sys/kernel/mm/transparent_hugepage/enabled首先,需要添加官方存储库:yum install yum-utilsrpm --import <https://repo.clickhouse.tech/CLICKHOUSE-KEY.GPG>yum-config-manager --add-repo <https://repo.clickhouse.tech/rpm/stable/x86_64>查看clickhouse可安装的版本:yum list | grep clickhouse运行安装命令:yum -y install clickhouse-server clickhouse-client修改/etc/clickhouse-server/config.xml配置文件,修改日志级别为information,默认是trace<level>information</level>执行日志所在目录:正常日志/var/log/clickhouse-server/clickhouse-server.log异常错误日志/var/log/clickhouse-server/clickhouse-server.err.log查看安装的clickhouse版本:clickhouse-server --versionclickhouse-client --passwordsudo clickhouse stopsudo clickhouse tartsudo clickhouse start

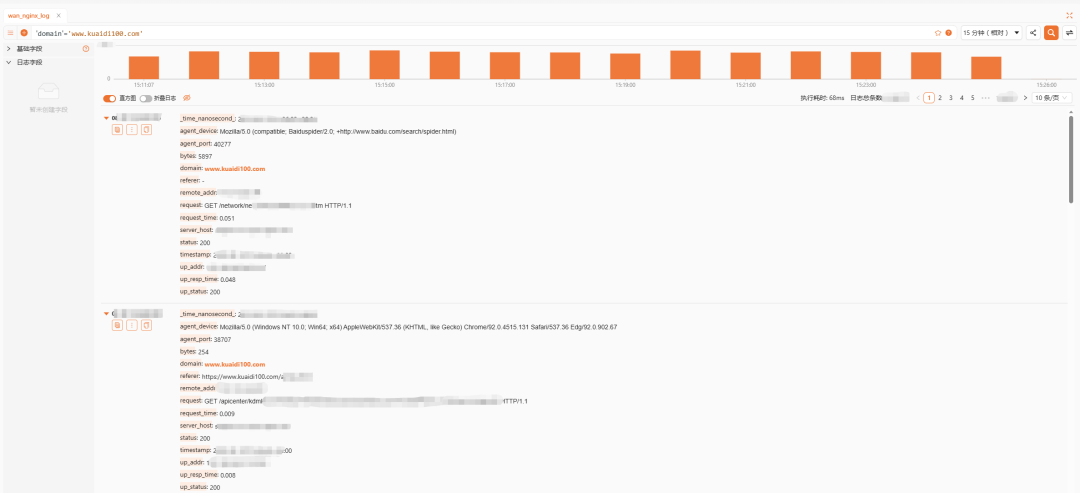

e) 基于 Clickvisual 的可视化

ClickVisual 是一个轻量级的开源日志查询、分析、报警的可视化平台,致力于提供一站式应用可靠性的可视化的解决方案。既可以独立部署使用,也可作为插件集成到第三方系统。目前是市面上唯一一款支持 ClickHouse 的类 Kibana 的开源业务日志查询平台。

它具备的特性,部分符合我们的需求:

-

支持可视化的查询面板,可查询命中条数直方图和原始日志;

-

支持设置日志索引功能,分析不同索引的占比情况;

-

支持 Proxy Auth 功能,能被非常轻松地集成到第三方系统;

-

支持基于 ClickHouse 日志的实时报警功能。

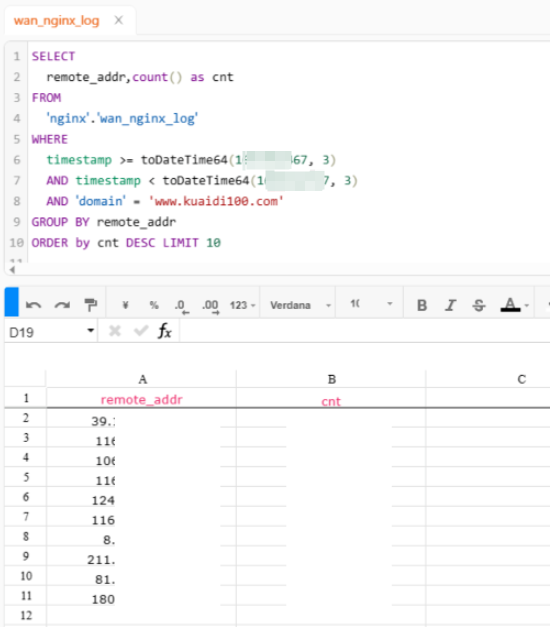

还提供了原始的SQL查询功能,直接输入SQL聚合语句,即时简单地对日志进行聚合分析:

体验总体类似 Kibana,细节稍有不足,通过这个查询分析界面作为一个入口,搭配日志告警模块,快速定位问题和故障排除方面的能力得到了大大的提升,基本无缝从Kibana上切换过来,拥有不错的排障体验。

优化方法

在此基础上,我们进行了优化方面的思考 ,其中也踩了一些 Clickhouse 的坑,使用了一些 Clickhouse 的新特性,是一个很有意思的过程。

1、日志查询优化探索

得益于Clickhouse的高压缩率和查询性能,小日志量的表直接配合时间分区搜索即可,但是当日志量涨到一定程度的时候,查询缓慢总是一个难受的事,我们对一些场景进行了总结:

-

traceid场景:在 Skywalking 中根据 traceid 查询链路日志时,使用tokenbf_v1 索引,并通过 hasToken 查询,由于跳过大部分无效parts,可快速命中返回;

-

无结构化日志:对于这种无结构化日志,用like性能会非常慢且消耗CPU甚至内存,新版本的 Clickhouse 已经支持了倒排索引,也开始基于倒排索引优化,可大大提高响应速度;

-

聚合场景:一些常规的聚合需求,可通过 Clickhouse 的 Projection 功能来满足。

2、本地表还是分布式表

本地表是Clickhouse的存储表,分布式表只是逻辑表,本身并不存储数据,在日志高频写入的场景,还是推荐写本地表,原因有这么几点:

-

当我们大批量写入日志时,可以直接往分布式表写,但数据会先拆分成不同parts,再通过Zookeeper进行分发,增加了集群间网络的负载,导致写入变慢,甚至出现Too many parts问题;

-

写分布式表更容易出现数据一致性问题;

-

Zookeeper压力变大。

3、Clickhouse的限制策略

随着日志中心的建设,日志体量越来越大,开始暴露一些配置层面的问题,我们开始对Clickhouse增加一些限制,以免错误的SQL导致集群缓慢甚至OOM的问题,对于日志查询用户,单独做了SQL复杂度的限制,users.xml中有几个参数:

max_memory_usage:单个服务器上运行查询的最大内存;max_memory_usage_for_user:单个服务器上运行用户查询的最大内存;max_memory_usage_for_all_queries:单个服务器上运行所有查询的最大内存;max_rows_to_read:运行查询时可从表中读取的最大行数;max_result_rows:限制结果中的行数;max_bytes_to_read:运行查询时可以从表中读取的最大字节数(未压缩数据)。

总结

整个部署的过程踩了不少坑,尤其是 filebeat yml 的参数设置。clickhouse 的配置说明我会再更新一篇跟大家同步一下过程中踩的坑。经常看到博客35岁以后怎么办的问题。说实话我自己也没想好以后怎么办,核心还是持续的学习&输出。不断的构建自己的护城河,不管是技术专家、业务专家、架构、管理等。

个人建议如果能持续写代码就奋战在一线,管理彻底与公司绑定。除非你是有名的大厂,这另外看。如果所在的公司缺乏较大的行业影响力,个人感觉可以奋战在一线,未来选择新的工作。考量更多的还是行业影响、商业 sense、技术架构能力。现在的我已35,从容的面对每一天。

来源:https://juejin.cn/post/7120880190003085320