当 OpenAI 的闭源 GPT-4 和 Meta 的开源 LLaMA 3 70B 模型在 Chatbot Arena Elo Score、MMLU 和 MT Benchmark 测试中表现出相当的性能时,选择更昂贵的专有模型(其成本高出 58 倍)的论据是: NVIDIA GPU Inference 上的运行速度比 Groq LPU Inference 上的 LLaMA 慢 17 倍,并且变得越来越难以制作

我发现 Llama 3 70B 和 GPT-4 之间存在巨大差异。但可能就像音质一样。如果有一款耳机的音质比目前最好的耳机高出 100 倍,几乎没有人会听出差别。

OpenAI 首席运营官 Brad Lightcap 表示,像今天这样的生成式人工智能在一年内将变得“糟糕得可笑”。 ChatGPT 很快就会承担更多“复杂的工作”并成为“伟大的队友”。先是 Sama,现在是 Brad,为什么不直接发布 GPT-5

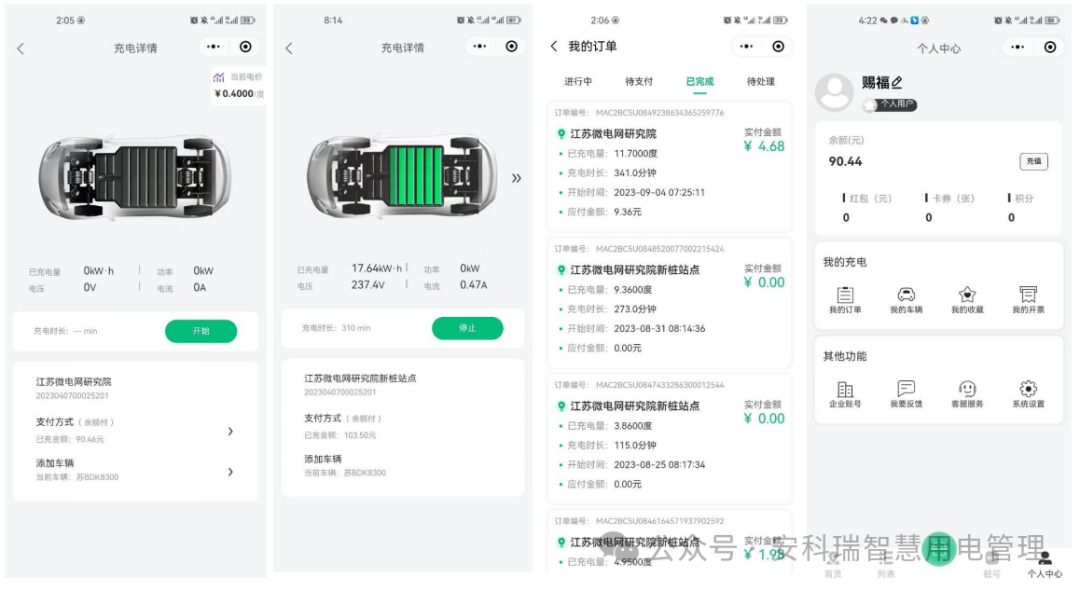

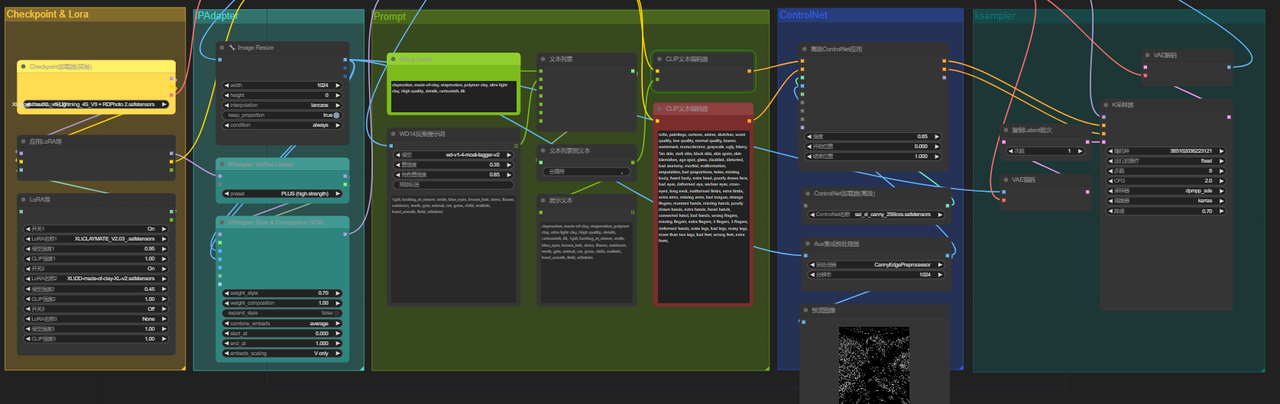

如果“我”可以做到这一点- OpenAI、Claude-3、Midjourney 等…您也可以做到这一点 - 可能比我更好 这是一个非常有用的功能,包含在 ChatGPT、Claude-3、Midjourney 等,而不至于每个都需要去开通PLUS

![[已解决]oneforAll ImportError: cannot import name ‘sre_parse‘ from ‘re‘](https://img-blog.csdnimg.cn/2e9b176a4d8640cf95857602c4aa85e5.png)