🐱 个人主页:TechCodeAI启航,公众号:TechCodeAI

🙋♂️ 作者简介:2020参加工作,专注于前端各领域技术,共同学习共同进步,一起加油呀!

💫 优质专栏:AI相关最新技术分享(目前在向AI方向发展,欢迎大佬交流)

📢 资料领取:前端进阶资料可以找我免费领取

🔥 摸鱼学习交流:我们的宗旨是在「工作中摸鱼,摸鱼中进步」,期待大佬一起来摸鱼!

令人瞩目的 Apple Intelligence 在今日总算现身了,然而,却又并非是完完全全地到来。

伴随 iOS 18.1 Beta 版的成功推送,自此刻起,注册开发者已然能够率先领略到部分来自苹果的 AI 功能。

众多提前尝鲜的海外网友早已沉浸其中,玩得不亦乐乎。其火爆程度通过下图便可清晰知晓:

从贯穿整个系统的写作工具,到最为关键的 Siri,让我们一同来领略由苹果所定义的 Apple 智能。

介绍之前,首先来讲一讲体验的前置条件:

iOS 18.1 Beta 版仅限注册开发者使用,普通用户需等待。

建议将设备地区设为美国,并将 Siri 语言设为英语。

仅 M 系列和 A17 Pro 芯片设备兼容,比如最新版 Pro/Pro Max。

用户需在设置中加入候补名单,目前通过速度比较快。

Siri:UI 界面大不同,但还是那么不聪明

博主 @Brandon Butch 在 YouTube 上分享了他第一时间的实测结果。

就分享的视频信息来看,新版 Siri 拥有了崭新的 UI 设计,看起来更酷炫了,像触发后会存有一个跑马灯的效果,并且附带一个触发的音效。

然而,iOS 18 Beta 1 中的 Siri 仍处于 1.0 版本,尚未接入 ChatGPT,预计其 2.0 版本会在 2025 年推出。

也正因如此,Siri 的智商还有待提升,例如当博主询问 Siri 4 个小时后的具体时间时,Siri 只是淡淡地回了一句「To who」。

召唤 Siri 的方式增添了新的一种,轻轻点击一下 iPhone 底部就会有横条亮起,且点击两次就能把 Siri 调出。

渐变色的新键盘界面与全新的文字输入相搭配,这回 Siri 确实有了很大的变化。而且貌似打字版的 Siri 还能够回答那些语音回答不了的问题。

为了让你好好说话,Writing tools 操碎了心

几个月以前,我们所定义的 Apple Intelligence 是,Apple 智能是天生就属于系统的功能,而这在新更新的 Writing tools(写作工具)功能里表现得极为淋漓尽致。

爱范儿

,赞24

在信息、备忘录里进行文字输入,你就会看到手机键盘的右上方有一个 Apple 智能按钮,点击之后即可得到完整的写作工具功能,包含但不限于三种不同类型重写句子的办法——“友好”“专业”“简洁”。

总之,这项功能的作用是帮助你找到一个更好的途径来表达你内心真正想说的话。

与友人聊天之际,让 AI 掌控语调的轻重缓急,避免不必要的误解与矛盾,既能够使其书写得更为专业、更为友好,也能够更简洁。对于不太善于言辞的低情商 i 人而言,这无疑是宝藏般的功能。

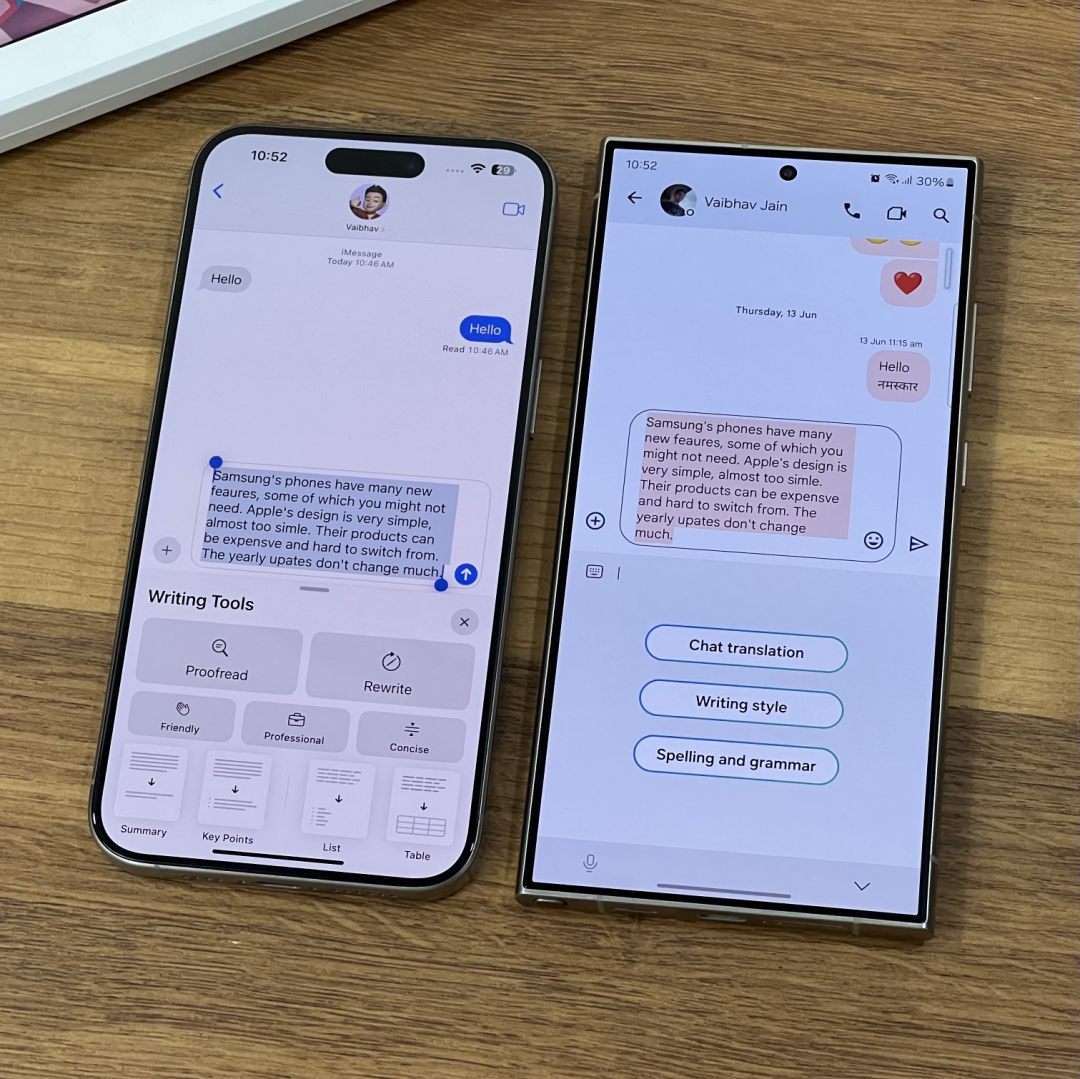

网友 @techdroider 也对比了与三星 Galaxy AI 类似功能的表现。没有任何悬念,「Apple 智能 1:0 三星 Galaxy AI 」。

当然,要是您对写作工具修改后的措辞没有兴趣,那照样能一键还原,就是这般任性。

而且,这一功能于 Safari 也可行,长按选定段落,然后写作工具就会弹出,之后自行执行前述操作。

而摘要、分点总结等功能更适合用于长文阅读。

作为一名邮箱被外网新闻报道塞满的编辑,现在能够通过页面右上角的默认摘要按钮帮我们提高工作效率,只需一键就能生成摘要,节省的时间绝非一星半点。

点击按钮之后,Apple 智能将会自动浏览和阅读信息,仅需大约 1 分钟左右的时间,就会在顶部留下简洁有力的摘要,即便是普通的电子邮件,此功能也同样适用。

写作工具里所提供的「prooffread(校对)」更是语法错误的克星。输入文字后,校对错误的记录清晰可见,哪怕是标点符号使用不规范,它都能够为您指出。

通话录音:寄予期待,也不失期待

心心念念许久的通话录音功能终于现身了。

怎样去录制?录音的效果好不好?识别准不准确?一条视频跟您讲透彻。

通话期间,点击左上角新增的录音键,便能开启录音,同时对方的电话里面也会收到录音已开启的语音提示。

爱范儿

,赞119

通话结束后,录音文件会自动保存至备忘录当中,其中不但有音频文件,还存在实时转录的语音文字。

与此同时,录音文件也能够转存至文件 App 里,录音文件为 m4a 格式,整体的录音文件会被压缩得很小,所以最终的效果只能说是勉强能听,并且转录的文字还能够区分发言人。

另外,我们还对方言的转录效果进行了测试,不妨点击观看上方的视频号吧。像是和普通话较为接近的北方方言,其转录的效果就相对精准,然而像粤语这类和普通话差别较大的方言,或许 iPhone 就不太能听懂了。

怎么样,对这个功能您还满意吗?

另外,还有一些小功能,例如用户能够通过自然语言创建幻灯片,以及搜索特定的照片和视频等。

Apple 智能内部更多细节曝光

在之前的文章中,我们简单揭秘了 Apple 智能是怎么炼成的,甚至即使没有 GPT-4o 也能打。

而在今天,苹果也发布了全面的技术报告,披露了关于 Apple 智能的更多细节。

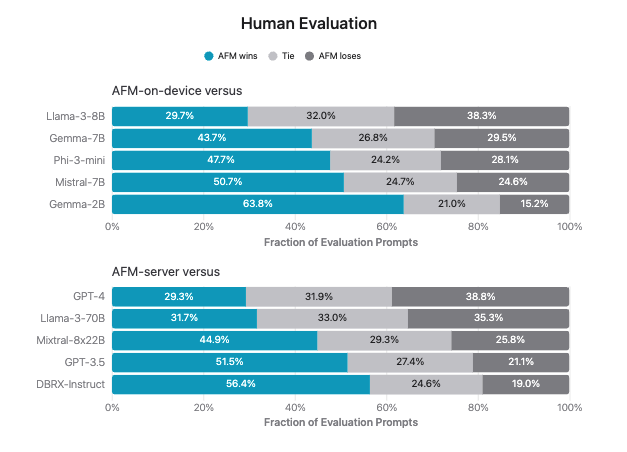

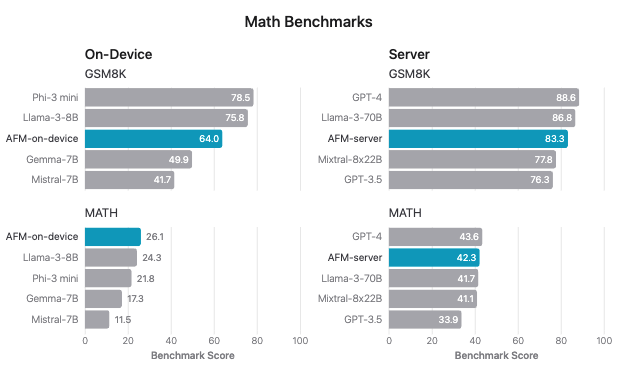

先来感受一下苹果官方给出的测试结果:

向左滑动查看更多内容

![]()

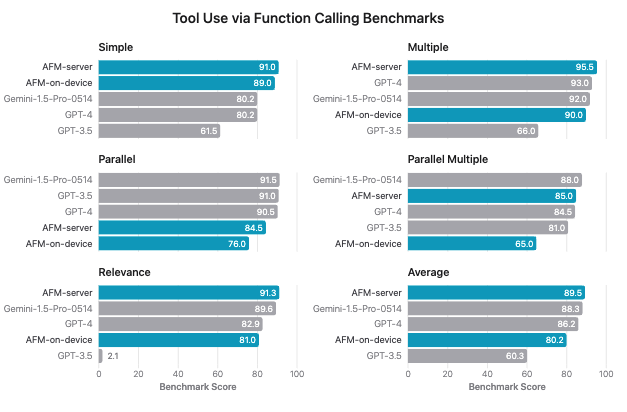

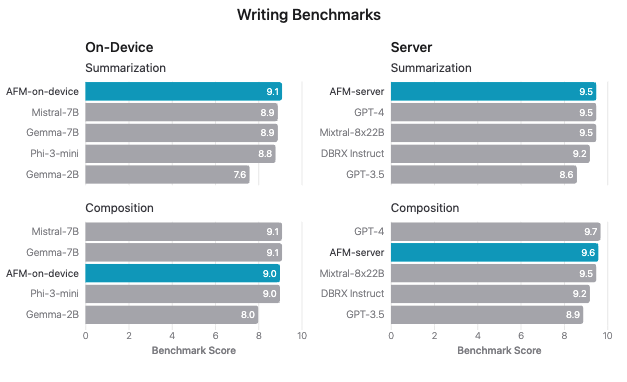

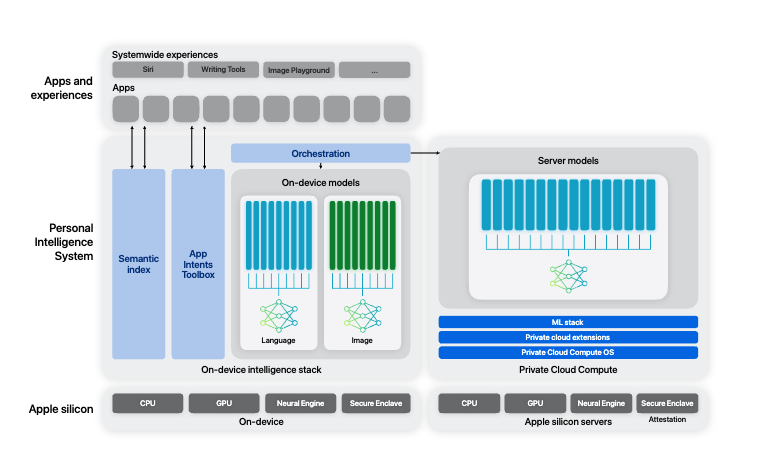

简单来讲,这份技术报告详尽阐述了 3B 参数大小的端侧模型 AFM-on-device,还有一种参数更大的云端模型 AFM-server。

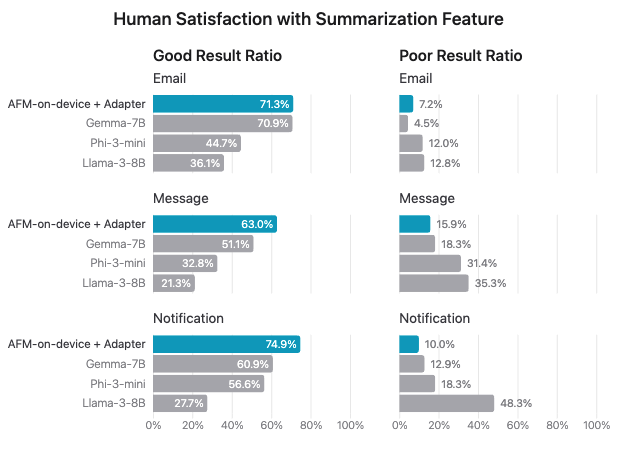

苹果的报告表明,前者端侧模型主要用于达成摘要的功能,例如适用于上文提及的电子邮件、消息和通知的摘要。苹果还特意与设计团队合作确立了电子邮件、消息和通知摘要的规范。

虽然端侧模型在生成一般摘要时表现不错,但难以生成完全符合规范的摘要。为处理这一问题,项目团队在 AFM 端侧模型上运用了 LoRA 适配器进行微调,以提升摘要生成的准确性。

后者云端模型则依据规则的过滤器采用启发式手段,如长度、格式、视角和语态限制;基于模型的过滤器用于应对更为复杂的摘要问题,以此提高摘要的质量。

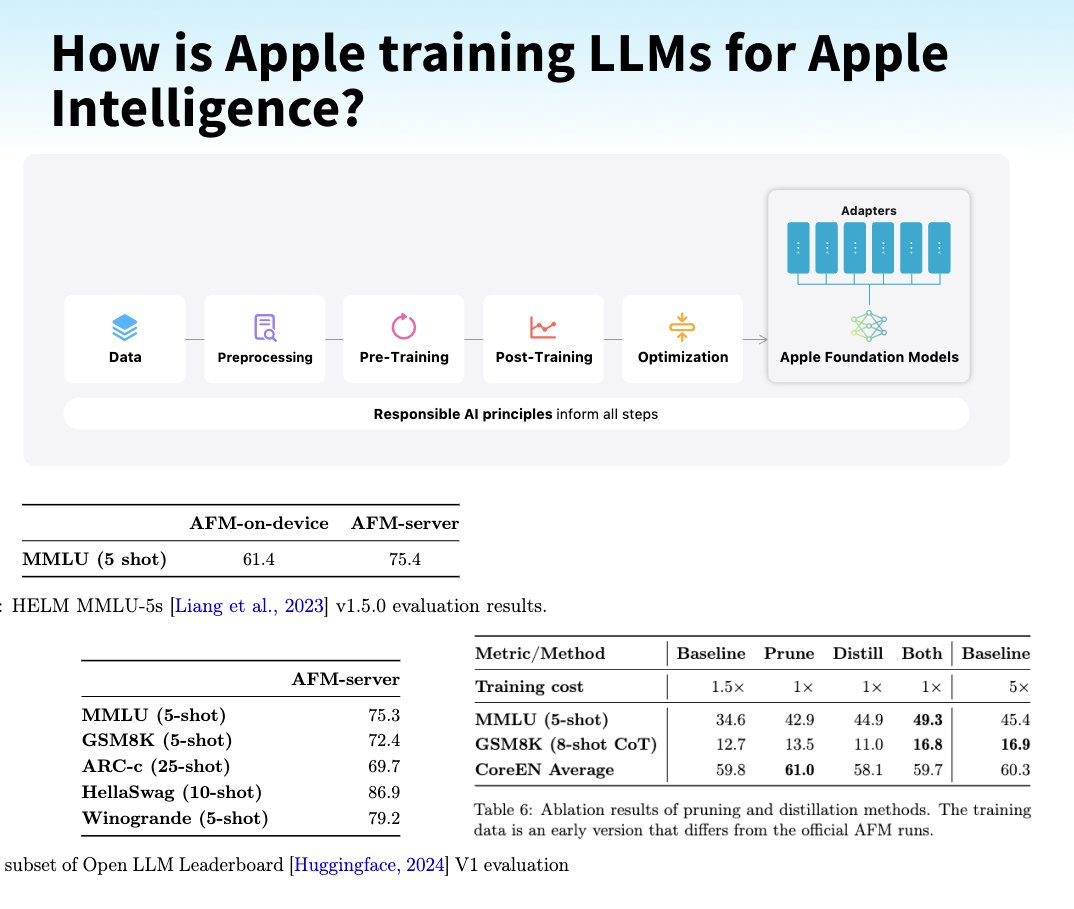

AI 发展的三要素无非算法、数据和算力。

在数据层面,AFM 预训练数据集是由多种高品质的数据相互混合构成的。这当中涵盖了苹果从出版商那里获取授权的数据、精心筹备的公开可用或开源数据集,还有由网络爬虫 Applebot 抓取的公开可用信息。

其中报告还着重提及了尊重网页使用标准的 robots.txt 指令选择不让 Applebot 抓取的权利,不太对劲,怎么有种在暗指 Anthropic 的感觉。

苹果也着重强调,训练数据里不存在任何私人的苹果用户数据,甚至专门过滤掉个人身份信息之后,才将其归入预训练混合数据当中。

值得留意的是,AFM 云端模型的核心训练是从零开始展开的,而 AFM 端侧模型则是通过蒸馏和剪枝从更大的模型里获取的。

在硬件方面采用了 Google TPU,其中云端和端侧分别使用了 8192 和 2048 颗 TPUv5p 芯片。

要是你想在电脑上制作视频,那你得安装一些额外的应用程序。在 AI 模型的天地里,苹果模型背后使用的「适配器」也是如此。

简单来讲,适配器就是一些模型权重的小集合,如同一个小型的插件,让模型可以快速适应各类任务。

举例来说,模型处理邮件和通知的总结,看起来差不多,然而实际上有很多细微的不同,因而苹果给模型装上了一个叫 LoRA 的适配器,使它能够更好地完成这种任务。

附上技术报告全文:

https://machinelearning.apple.com/papers/apple\_intelligence\_foundation\_language\_models.pdf

写在最后,不可否认的一个事实是,当下手机端侧 AI 不管是在技术方面还是产品应用方面都难以称得上成熟。

但也正因为这样,我们才会对苹果牌 AI 怀有极大的期望。

自苹果发布会之后,我们获取到的有关 Apple 智能的消息并不好。

在众多泄露出来的小道消息里,Apple 智能的推出日期也不断“跳票”。

就连最近彭博社也报道说,苹果会在 10 月底前给用户推送“Apple 智能”的软件升级,不过这要比今年发布的 iOS 18 和 iPadOS 18 操作系统还要晚好几周。

今天推出的 iOS 18.1 Beta 虽然只是公布了 Apple 智能的一些细微之处,但至少也让我们安了心。

那就是 Apple 智能至少不是虚无缥缈的,它正在朝我们靠近。

没错,我所指的就是 OpenAI 那个反面的例子,也就是官宣了大半年,还处于如同未来才有的状态的“期货”Sora。当然,我们也盼望 Apple 智能的完整面貌能够早日呈现,这对于消费者而言是一件好事,也能够给众多终端厂商做个榜样。