目录

- 第一门课:第二门课 改善深层神经网络:超参数调试、正 则 化 以 及 优 化 (Improving Deep Neural Networks:Hyperparameter tuning, Regularization and Optimization)

- 第一周:深度学习的 实践层面 (Practical aspects of Deep Learning)

- 1.6 dropout 正则化(Dropout Regularization)

第一门课:第二门课 改善深层神经网络:超参数调试、正 则 化 以 及 优 化 (Improving Deep Neural Networks:Hyperparameter tuning, Regularization and Optimization)

第一周:深度学习的 实践层面 (Practical aspects of Deep Learning)

1.6 dropout 正则化(Dropout Regularization)

除了𝐿2正则化,还有一个非常实用的正则化方法——“Dropout(随机失活)”,我们来看看它的工作原理。

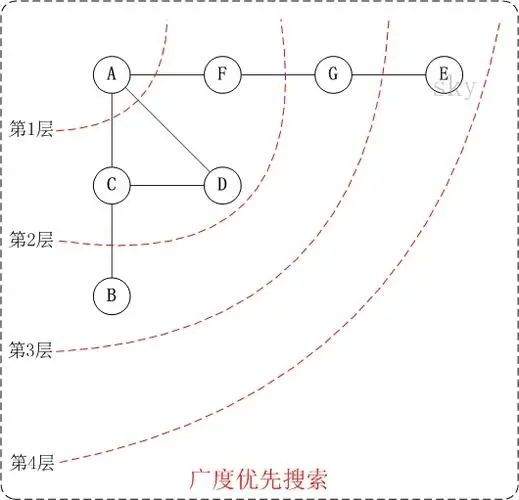

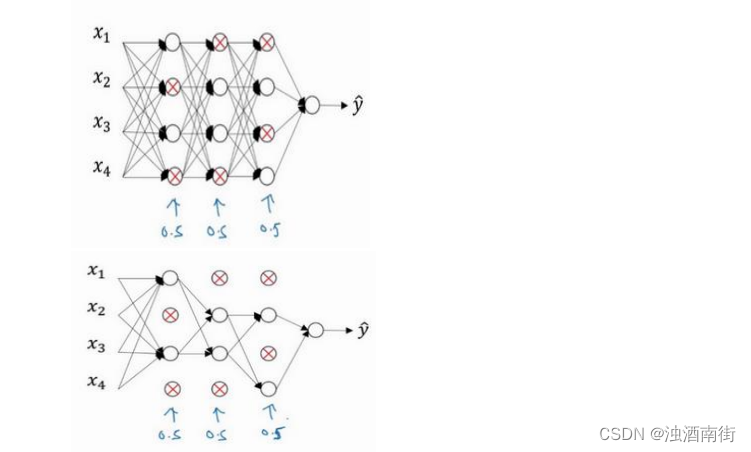

假设你在训练上图这样的神经网络,它存在过拟合,这就是 dropout 所要处理的,我们复制这个神经网络,dropout 会遍历网络的每一层,并设置消除神经网络中节点的概率。假设网络中的每一层,每个节点都以抛硬币的方式设置概率,每个节点得以保留和消除的概率都是 0.5,设置完节点概率,我们会消除一些节点,然后删除掉从该节点进出的连线,最后得到一个节点更少,规模更小的网络,然后用 backprop 方法进行训练。

这是网络节点精简后的一个样本,对于其它样本,我们照旧以抛硬币的方式设置概率,保留一类节点集合,删除其它类型的节点集合。对于每个训练样本,我们都将采用一个精简后神经网络来训练它,这种方法似乎有点怪,单纯遍历节点,编码也是随机的,可它真的有效。不过可想而知,我们针对每个训练样本训练规模极小的网络,最后你可能会认识到为什么要正则化网络,因为我们在训练极小的网络。

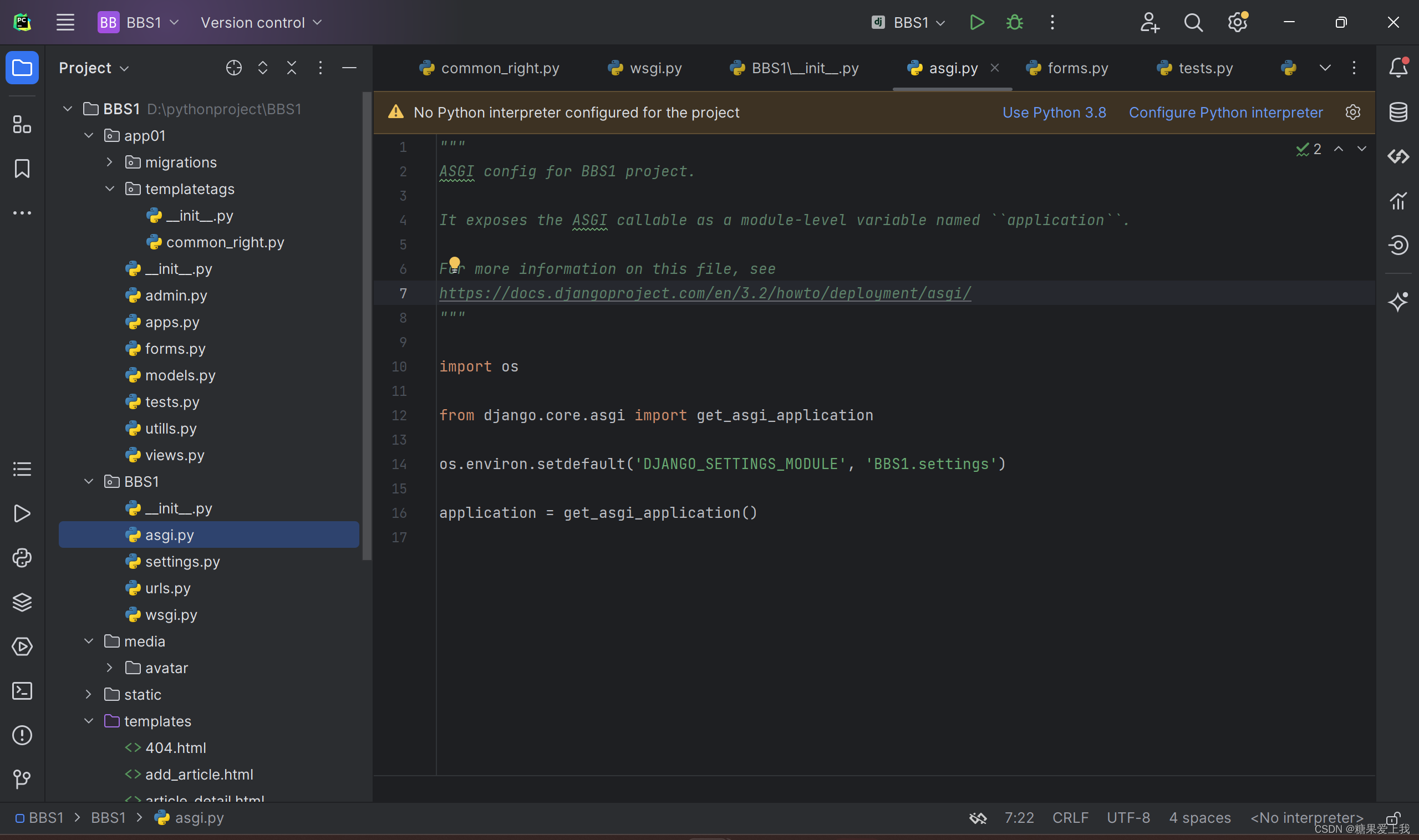

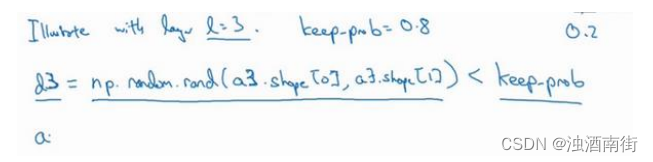

如何实施 dropout 呢?方法有几种,接下来我要讲的是最常用的方法,即 inverted dropout(反向随机失活),出于完整性考虑,我们用一个三层(𝑙 = 3)网络来举例说明。编码中会有很多涉及到 3 的地方。我只举例说明如何在某一层中实施 dropout。首先要定义向量𝑑,𝑑[3]表示一个三层的 dropout 向量:

d3 = np.random.rand(a3.shape[0],a3.shape[1])

然后看它是否小于某数,我们称之为 keep-prob,keep-prob 是一个具体数字,上个示例中它是 0.5,而本例中它是 0.8,它表示保留某个隐藏单元的概率,此处 keep-prob 等于 0.8,它意味着消除任意一个隐藏单元的概率是 0.2,它的作用就是生成随机矩阵,如果对 a [ 3 ] a^{[3]} a[3]进行

因子分解,效果也是一样的。 d [ 3 ] d^{[3]} d[3]是一个矩阵,每个样本和每个隐藏单元,其中 d [ 3 ] d^{[3]} d[3]中的对应值为 1 的概率都是 0.8,对应为 0 的概率是 0.2,随机数字小于 0.8。它等于 1 的概率是 0.8,等于 0 的概率是 0.2。

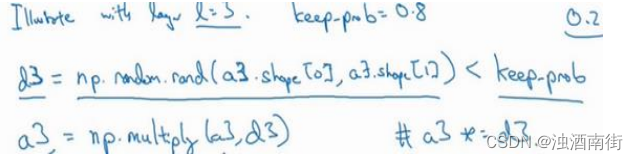

接下来要做的就是从第三层中获取激活函数,这里我们叫它 a [ 3 ] a^{[3]} a[3], a [ 3 ] a^{[3]} a[3]含有要计算的激活函数, a [ 3 ] a^{[3]} a[3]等于上面的 a [ 3 ] a^{[3]} a[3]乘以 d [ 3 ] d^{[3]} d[3],a3 =np.multiply(a3,d3),这里是元素相乘,也可写为𝑎3 ∗= 𝑑3,它的作用就是让 d [ 3 ] d^{[3]} d[3]中所有等于 0 的元素(输出),而各个元素等于 0 的概率只有 20%,乘法运算最终把 d [ 3 ] d^{[3]} d[3]中相应元素输出,即让 d [ 3 ] d^{[3]} d[3]中 0 元素与 a [ 3 ] a^{[3]} a[3]中相对元素归零。

如果用 python 实现该算法的话,𝑑[3]则是一个布尔型数组,值为 true 和 false,而不是1 和 0,乘法运算依然有效,python 会把 true 和 false 翻译为 1 和 0,大家可以用 python 尝试一下。

最后,我们向外扩展𝑎[3],用它除以 0.8,或者除以 keep-prob 参数。

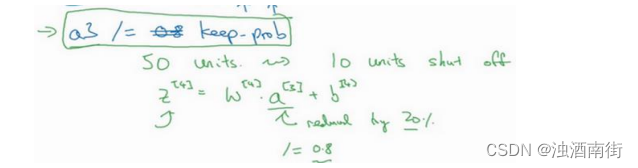

𝑎3/= 𝑘𝑒𝑒𝑝 − 𝑝𝑟𝑜𝑏

下面我解释一下为什么要这么做,为方便起见,我们假设第三隐藏层上有 50 个单元或50 个神经元,在一维上𝑎[3]是 50,我们通过因子分解将它拆分成50 × 𝑚维的,保留和删除它们的概率分别为 80%和 20%,这意味着最后被删除或归零的单元平均有 10(50×20%=10)个,现在我们看下𝑧[4],𝑧[4] = 𝑤[4]𝑎[3] + 𝑏[4],我们的预期是,𝑎[3]减少 20%,也就是说𝑎[3]中有 20%的元素被归零,为了不影响𝑧[4]的期望值,我们需要用𝑤[4]𝑎[3]/0.8,它将会修正或弥补我们所需的那 20%,𝑎[3]的期望值不会变,划线部分就是所谓的 dropout 方法。