Gemma的简单介绍

Gemma 是一系列轻量级、最先进的开放式模型,采用与创建 Gemini 模型相同的研究和技术而构建。 Gemma 由 Google DeepMind 和 Google 的其他团队开发,其灵感来自 Gemini,其名称反映了拉丁语 gemma,意思是“宝石”。 除了模型权重之外,Google还发布了工具来支持开发人员创新、促进协作并指导负责任地使用 Gemma 模型。

以下是关键细节:

- 发布了两种尺寸的模型配重:Gemma 2B 和 Gemma 7B。 每个尺寸都发布了经过预训练和指令调整的变体。

- Responsible Generative AI 工具包为使用 Gemma 创建更安全的 AI 应用程序提供了指导和基本工具。

- 通过原生 Keras 3.0 提供跨所有主要框架的推理和监督微调 (SFT) 工具链:JAX、PyTorch 和 TensorFlow。

- 即用型 Colab 和 Kaggle 笔记本,以及与 Hugging Face、MaxText、NVIDIA NeMo 和 TensorRT-LLM 等流行工具的集成,让您可以轻松开始使用 Gemma。

- 预先训练和指令调整的 Gemma 模型可以在您的笔记本电脑、工作站或 Google Cloud 上运行,并可轻松部署在 Vertex AI 和 Google Kubernetes Engine (GKE) 上。

- 跨多个 AI 硬件平台的优化可确保行业领先的性能,包括 NVIDIA GPU 和 Google Cloud TPU

基于Colab的搭建过程

- 注册Colab账号,全称Colaboratory,谷歌推出的笔记本应用,可以在线运行Python程序,是Google运行的Jupyter Notebooks,提供免费的CPU和GPU运算。

- 登录下方网址,进入Kaggle,找到Gemma模型,kaggle是一个被谷歌收购的科学竞赛社区,上面会发布各种模型和资料。Gemma | Kaggle

https://www.kaggle.com/models/google/gemma

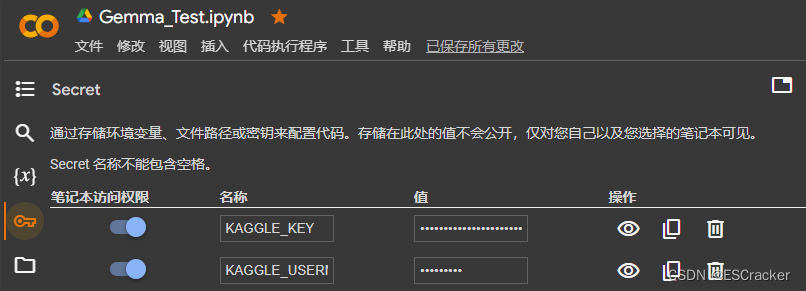

https://www.kaggle.com/models/google/gemma - 注册Kaggle账号,然后进入Settings,设置API并下载打开Kaggle.json文件,记住里面的账号名和密码,然后添加到Colab的环境变量中,名称分别为KAGGLE_KEY和KAGGLE_USERNAME.

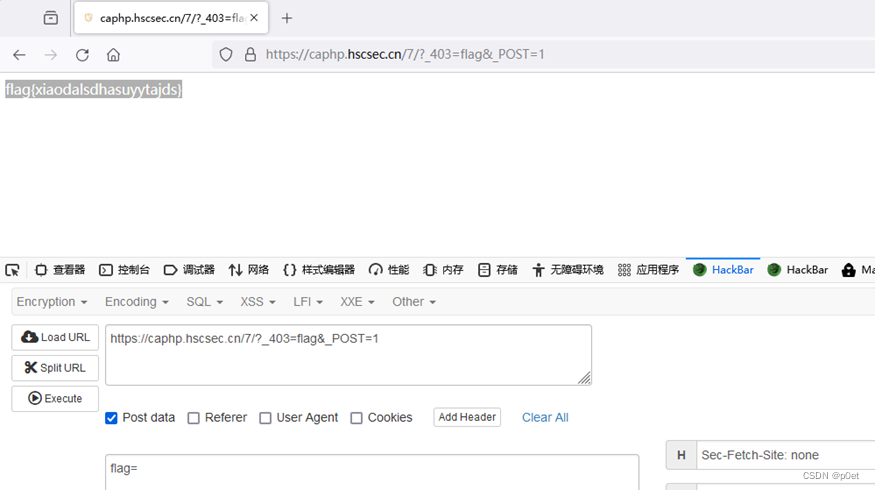

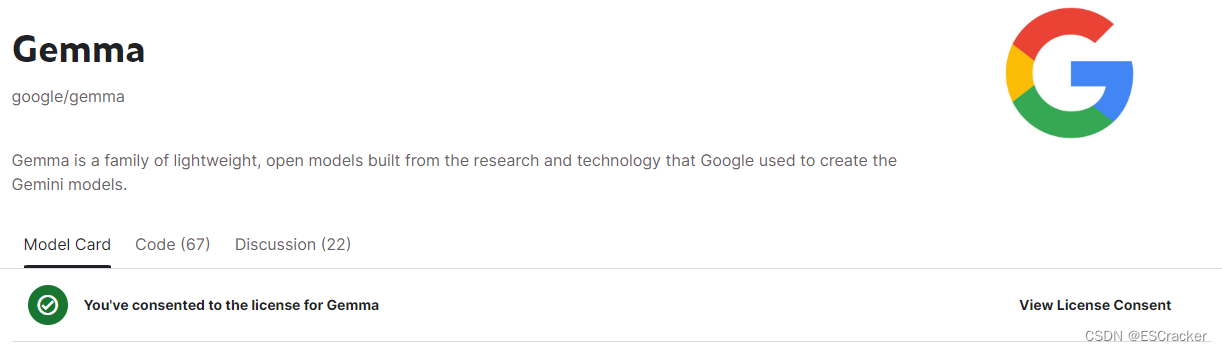

- 填写Gemma模型的使用条款,如图所示的绿色图标位置

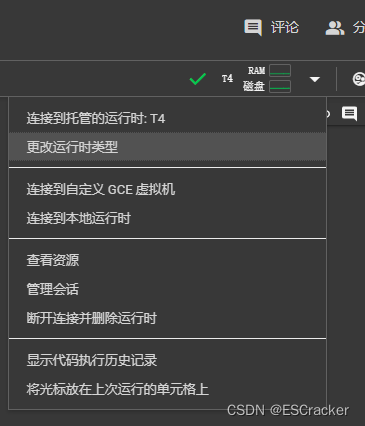

- 进入Colab笔记本,配置环境,设置连接的服务器,选择更改运行时的类型,选择T4,然后会看到这个图标显示。

- 安装keras-nlp和keras,安装完可能会提示重启Session,按提示来

!pip install -U keras-nlp

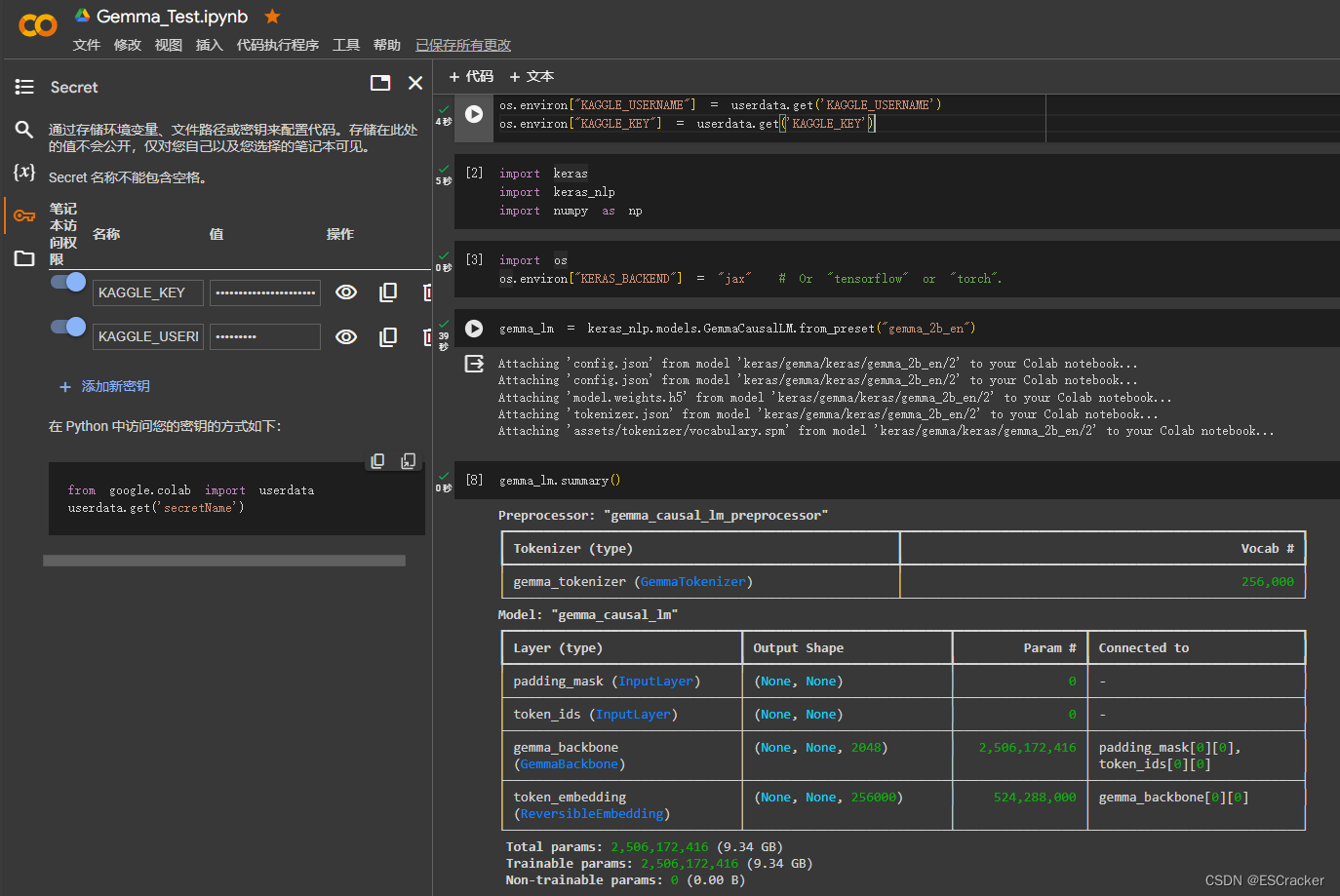

!pip install -U keras- 然后我们import一下库,先把用户信息变量设置好

import os

from google.colab import userdataos.environ["KAGGLE_USERNAME"] = userdata.get('KAGGLE_USERNAME')

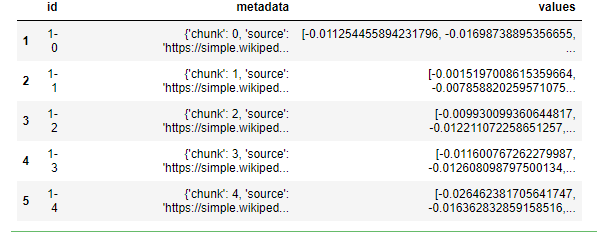

os.environ["KAGGLE_KEY"] = userdata.get('KAGGLE_KEY')- 然后配置环境,导入模型

import keras

import keras_nlp

import numpy as npos.environ["KERAS_BACKEND"] = "jax" # Or "tensorflow" or "torch".gemma_lm = keras_nlp.models.GemmaCausalLM.from_preset("gemma_2b_en")- 输入下面命令查看是否运行成功,成功的话会和下面图片显示一致

gemma_lm.summary()

- 使用方法的话,就是直接写代码加提示词

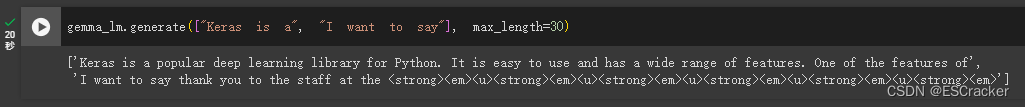

gemma_lm.generate(["Keras is a", "I want to say"], max_length=30)