文章目录

- 2.1 数据清洗和预处理

- 2.1.1 基础知识

- 2.1.2 主要案例:电商平台的顾客购买历史数据清洗

- 2.1.3 拓展案例 1:社交媒体用户行为的数据清洗

- 2.1.4 拓展案例 2:金融交易数据的预处理

- 2.2 探索性数据分析(EDA)

- 2.2.1 基础知识

- 2.2.2 主要案例:电信客户流失分析

- 2.2.3 拓展案例 1:电影评分数据分析

- 2.2.4 拓展案例 2:网站用户行为日志分析

- 2.3 数据可视化技术

- 2.3.1 基础知识

- 2.3.2 主要案例:销售数据的可视化分析

- 2.3.3 拓展案例 1:用户行为数据的可视化

- 2.3.4 拓展案例 2:金融市场数据的可视化

2.1 数据清洗和预处理

在数据科学的世界里,数据清洗和预处理就像是准备一顿美味佳肴之前的准备工作。没有人喜欢在沙拉里吃到沙子,对吧?这就是为什么数据清洗至关重要的原因。让我们深入了解一下如何打扫我们的“数据厨房”,确保我们的分析是基于干净、整洁的数据进行的。

2.1.1 基础知识

- 缺失数据处理:面对缺失数据,我们有几个选择:删除含有缺失值的记录,填充缺失值(例如,使用平均数、中位数或众数),或者使用模型预测缺失值。

- 异常值检测和处理:异常值可能会扭曲数据分析的结果。我们可以通过各种方法来识别异常值,如 IQR 方法或 Z 分数方法,并决定是删除它们、替换它们,还是保留它们。

- 数据标准化和归一化:这些技术用于将数据缩放到一个标准范围内,特别是在处理具有不同量级的特征时非常重要。

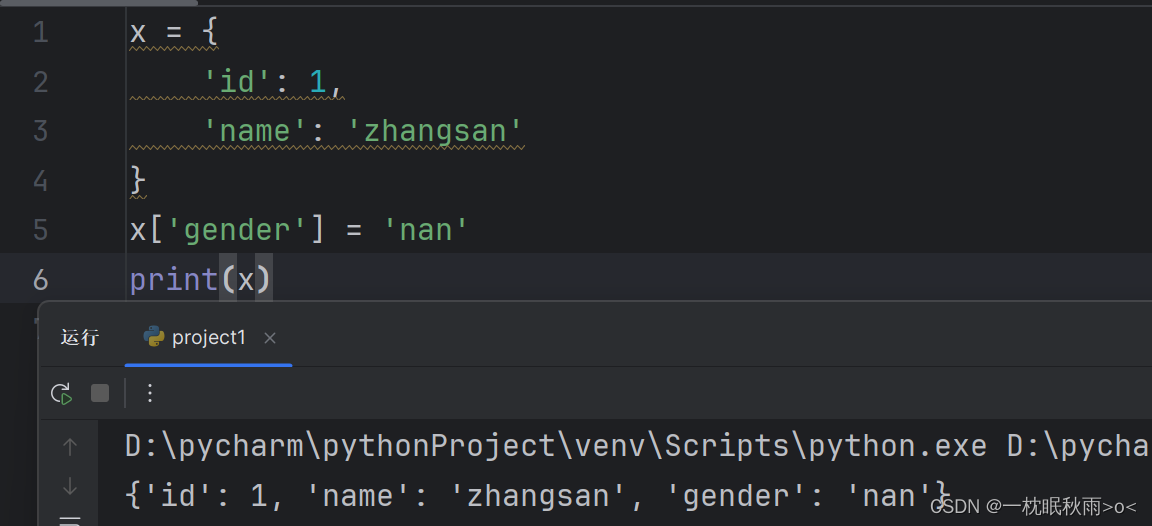

- 数据编码:将分类数据转换为数值数据,以便于分析。常见的方法包括独热编码(One-Hot Encoding)和标签编码(Label Encoding)。

2.1.2 主要案例:电商平台的顾客购买历史数据清洗

场景:一家电商平台想要分析其顾客的购买历史,以便进行市场细分和个性化推荐。

步骤:

- 处理缺失值:检查顾客信息和购买记录中的缺失值,并填充或删除。

- 识别并处理异常值:识别不合理的购买金额(如负数或异常高的值)并进行处理。

- 标准化数据:对顾客的购买频率和金额进行标准化处理,以便进行比较。

Python 示例:

import pandas as pd

from sklearn.preprocessing import StandardScaler# 加载数据

data = pd.read_csv('customer_purchase_history.csv')# 处理缺失值,这里我们选择填充缺失值

data.fillna(data.mean(), inplace=True)# 识别并处理异常值,这里我们将购买金额为负数的记录设为 NaN,然后填充平均值

data['purchase_amount'] = data['purchase_amount'].apply(lambda x: x if x >= 0 else None)

data.fillna(data.mean(), inplace=True)# 数据标准化

scaler = StandardScaler()

data[['purchase_frequency', 'purchase_amount']] = scaler.fit_transform(data[['purchase_frequency', 'purchase_amount']])print(data.head())

2.1.3 拓展案例 1:社交媒体用户行为的数据清洗

场景:一家社交媒体公司希望分析用户的行为数据,以优化其内容推荐算法。

步骤:

- 处理缺失值:对用户的互动数据(如点赞、评论数)中的缺失值进行处理。

- 数据编码:将用户的活动类型(如“点赞”、“评论”、“分享”)转换为数值数据,以便分析。

Python 示例:

from sklearn.preprocessing import OneHotEncoder# 假设 user_behavior 是包含用户行为数据的 DataFrame

user_behavior = pd.DataFrame({'activity': ['like', 'comment', 'share', 'like', 'comment'],'activity_count': [5, None, 2, 3, None]

})# 处理缺失值

user_behavior.fillna({'activity_count': user_behavior['activity_count'].mean()}, inplace=True)# 数据编码

encoder = OneHotEncoder(sparse=False)

encoded_activity = encoder.fit_transform(user_behavior[['activity']])

encoded_df = pd.DataFrame(encoded_activity, columns=encoder.get_feature_names(['activity']))# 合并编码后的 DataFrame

user_behavior_encoded = pd.concat([user_behavior, encoded_df], axis=1)print(user_behavior_encoded)

2.1.4 拓展案例 2:金融交易数据的预处理

场景:一家银行想要分析客户的交易数据,以识别欺诈行为。

步骤:

- 异常值检测:识别异常大的交易金额,这可能表明欺诈行为。

- 数据归一化:对交易金额进行归一化处理,以便模型更好地处理。

Python 示例:

from sklearn.preprocessing import MinMaxScaler# 假设 transactions 是包含交易金额的 DataFrame

transactions = pd.DataFrame({'amount': [50, 20000, 100, 150, 200000, 75]

})# 异常值处理:这里我们简单地使用 IQR 方法

Q1 = transactions['amount'].quantile(0.25)

Q3 = transactions['amount'].quantile(0.75)

IQR = Q3 - Q1

lower_bound = Q1 - 1.5 * IQR

upper_bound = Q3 + 1.5 * IQRtransactions_filtered = transactions[(transactions['amount'] >= lower_bound) & (transactions['amount'] <= upper_bound)]# 数据归一化

scaler = MinMaxScaler()

transactions_filtered['normalized_amount'] = scaler.fit_transform(transactions_filtered[['amount']])print(transactions_filtered)

通过这些案例,我们可以看到,无论是处理缺失值、异常值,还是进行数据标准化和编码,Python 都为数据清洗和预处理提供了强大的工具和库。这些步骤虽然看起来像是厨房里的杂务,但却是确保我们的“数据佳肴”美味可口的关键所在。

2.2 探索性数据分析(EDA)

探索性数据分析(EDA)是数据分析过程中一步极其有趣且充满好奇的探索。这就像是数据的自我介绍,让你在深入建模和假设检验之前,先对数据有个初步的了解和感觉。EDA 的核心在于“探索”和“分析”——通过可视化和基本统计来揭示数据的隐藏结构和特征。

2.2.1 基础知识

- 单变量分析:关注单一变量的分布情况,通过绘制直方图、箱线图等方式来观察其分布特征。

- 多变量分析:分析变量之间的关系,例如使用散点图观察两个连续变量之间的关系,或是通过交叉表探索分类变量之间的联系。

- 缺失值和异常值的处理:在 EDA 过程中,识别并处理缺失值和异常值,以防它们扭曲分析结果。

- 基本统计量:计算均值、中位数、标准差等统计量,为数据分布提供量化描述。

2.2.2 主要案例:电信客户流失分析

场景:电信公司希望通过分析客户的使用数据和个人信息,来识别可能流失的客户。

步骤:

- 单变量分析:分析客户月消费金额和使用时长的分布情况。

- 多变量分析:探索月消费金额与客户流失率之间的关系。

- 缺失值处理:检查数据集中的缺失值并决定如何处理它们。

Python 示例:

import pandas as pd

import matplotlib.pyplot as plt

import seaborn as sns# 加载数据集

data = pd.read_csv('telecom_churn_data.csv')# 单变量分析:月消费金额的分布

plt.figure(figsize=(8, 6))

sns.histplot(data['MonthlyCharges'], kde=True)

plt.title('Distribution of Monthly Charges')

plt.xlabel('Monthly Charges')

plt.ylabel('Frequency')

plt.show()# 多变量分析:月消费金额与客户流失的关系

plt.figure(figsize=(8, 6))

sns.boxplot(x='Churn', y='MonthlyCharges', data=data)

plt.title('Monthly Charges by Churn Status')

plt.xlabel('Churn Status')

plt.ylabel('Monthly Charges')

plt.show()

2.2.3 拓展案例 1:电影评分数据分析

场景:一个电影推荐系统希望通过分析电影的评分数据来提高推荐质量。

步骤:

- 单变量分析:分析电影评分的分布情况。

- 多变量分析:探索电影类型与评分之间的关系。

Python 示例:

# 加载数据集

movie_data = pd.read_csv('movies_ratings.csv')# 单变量分析:电影评分的分布

plt.figure(figsize=(8, 6))

sns.histplot(movie_data['rating'], bins=20, kde=True)

plt.title('Distribution of Movie Ratings')

plt.xlabel('Rating')

plt.ylabel('Frequency')

plt.show()# 多变量分析:电影类型与评分的关系

plt.figure(figsize=(12, 6))

sns.boxplot(x='genre', y='rating', data=movie_data)

plt.xticks(rotation=45)

plt.title('Movie Ratings by Genre')

plt.xlabel('Genre')

plt.ylabel('Rating')

plt.show()

2.2.4 拓展案例 2:网站用户行为日志分析

场景:一个网站运营团队想要通过分析用户的访问日志来优化网站布局和内容。

步骤:

-

单变量分析:分析用户访问时长的分布情况。

-

多变量分析:探索用户访问时长与访问页面数量之间的关系。

Python 示例:

# 加载数据集

web_log_data = pd.read_csv('web_user_log.csv')# 单变量分析:用户访问时长的分布

plt.figure(figsize=(8, 6))

sns.histplot(web_log_data['visit_duration'], bins=30, kde=True)

plt.title('Distribution of Visit Duration')

plt.xlabel('Visit Duration (seconds)')

plt.ylabel('Frequency')

plt.show()# 多变量分析:用户访问时长与访问页面数量的关系

plt.figure(figsize=(8, 6))

sns.scatterplot(x='visit_duration', y='pages_visited', data=web_log_data)

plt.title('Visit Duration vs. Pages Visited')

plt.xlabel('Visit Duration (seconds)')

plt.ylabel('Pages Visited')

plt.show()

通过这些案例,我们可以看到 EDA 如何帮助我们从不同角度理解数据,揭示数据背后的故事。无论是通过单变量还是多变量分析,EDA 都是数据分析过程中不可或缺的一步,为后续的深入分析和建模打下坚实的基础。

2.3 数据可视化技术

数据可视化是将复杂的数据集转换成图形或图像形式的过程,它是数据分析不可或缺的一部分。通过可视化,我们可以直观地看到数据的模式、趋势和异常值,这有助于我们更快地理解数据并做出决策。

2.3.1 基础知识

- 基本图表:如条形图、折线图、散点图等,适用于展示数据的分布、趋势和关系。

- 复杂图表:如箱线图、热力图、树状图等,用于展示数据的深层结构和多维度关系。

- 可视化库:Python 提供了多个强大的可视化库,如 Matplotlib、Seaborn、Plotly,它们支持创建从简单到复杂的各种图表。

- 可视化原则:在设计图表时,应保持简洁、明确的目标,合理使用颜色和标记,确保图表易于理解且信息量大。

2.3.2 主要案例:销售数据的可视化分析

场景:一家公司希望通过可视化分析其产品的销售数据,以识别销售趋势和季节性模式。

步骤:

- 使用折线图展示销售趋势:折线图能清晰展示销售额随时间的变化趋势。

- 使用条形图比较不同产品的销售量:条形图适合比较类别数据。

- 使用热力图分析产品销售的季节性模式:热力图可以展示销售量在不同月份的分布情况。

Python 示例:

import pandas as pd

import matplotlib.pyplot as plt

import seaborn as sns# 加载数据

sales_data = pd.read_csv('sales_data.csv')# 折线图展示销售趋势

plt.figure(figsize=(10, 6))

plt.plot(sales_data['Month'], sales_data['Sales'])

plt.title('Sales Trend Over Time')

plt.xlabel('Month')

plt.ylabel('Sales')

plt.xticks(rotation=45)

plt.show()# 条形图比较不同产品的销售量

plt.figure(figsize=(10, 6))

sns.barplot(x='Product', y='Sales', data=sales_data)

plt.title('Sales by Product')

plt.xlabel('Product')

plt.ylabel('Sales')

plt.show()# 热力图分析产品销售的季节性模式

sales_pivot = sales_data.pivot("Month", "Product", "Sales")

plt.figure(figsize=(12, 6))

sns.heatmap(sales_pivot, annot=True, fmt=".1f", cmap='YlGnBu')

plt.title('Seasonal Sales Patterns by Product')

plt.xlabel('Product')

plt.ylabel('Month')

plt.show()

2.3.3 拓展案例 1:用户行为数据的可视化

场景:一款应用希望通过可视化用户的活跃时间和行为模式,来优化用户体验。

步骤:

- 使用散点图展示用户活跃时间分布。

- 使用箱线图分析用户行为的离散程度。

Python 示例:

# 假设 user_data 包含用户行为数据

user_data = pd.read_csv('user_behavior.csv')# 散点图展示用户活跃时间分布

plt.figure(figsize=(10, 6))

sns.scatterplot(x='Hour', y='ActivityCount', data=user_data)

plt.title('User Activity Distribution by Hour')

plt.xlabel('Hour of Day')

plt.ylabel('Activity Count')

plt.show()# 箱线图分析用户行为的离散程度

plt.figure(figsize=(10, 6))

sns.boxplot(x='ActivityType', y='ActivityCount', data=user_data)

plt.title('Dispersion of User Behavior')

plt.xlabel('Type ofActivity')

plt.ylabel('Activity Count')

plt.show()

2.3.4 拓展案例 2:金融市场数据的可视化

场景:金融分析师需要可视化股票价格和交易量的变化,以便进行市场分析。

步骤:

- 使用折线图展示股票价格变化趋势。

- 使用条形图展示交易量变化。

Python 示例:

# 假设 stock_data 包含股票市场数据

stock_data = pd.read_csv('stock_data.csv')# 折线图展示股票价格变化趋势

plt.figure(figsize=(10, 6))

plt.plot(stock_data['Date'], stock_data['Price'])

plt.title('Stock Price Trend')

plt.xlabel('Date')

plt.ylabel('Price')

plt.xticks(rotation=45)

plt.show()# 条形图展示交易量变化

plt.figure(figsize=(10, 6))

plt.bar(stock_data['Date'], stock_data['Volume'])

plt.title('Trading Volume Over Time')

plt.xlabel('Date')

plt.ylabel('Volume')

plt.xticks(rotation=45)

plt.show()

通过这些案例,我们可以看到数据可视化在揭示数据趋势、模式和异常值方面的强大能力。无论是分析销售数据、用户行为还是金融市场,适当的可视化技术都能帮助我们更加直观和有效地理解数据,为决策提供有力支持。