文章目录

- Flume

- Flume 定义

- Flume 基础架构

- Agent

- Source

- Sink

- Channel

- Event

- Flume 安装部署

- 安装地址

- 安装部署

- Flume 入门案例

- 监控端口数据官方案例

- 实时监控单个追加文件

- 实时监控目录下多个新文件

- 实时监控目录下的多个追加文件

Flume

Flume 定义

Flume 是 Cloudera 提供的一个高可用的,高可靠的,分布式的海量日志采集、聚合和传输的系统。Flume基于流式架构,灵活简单。

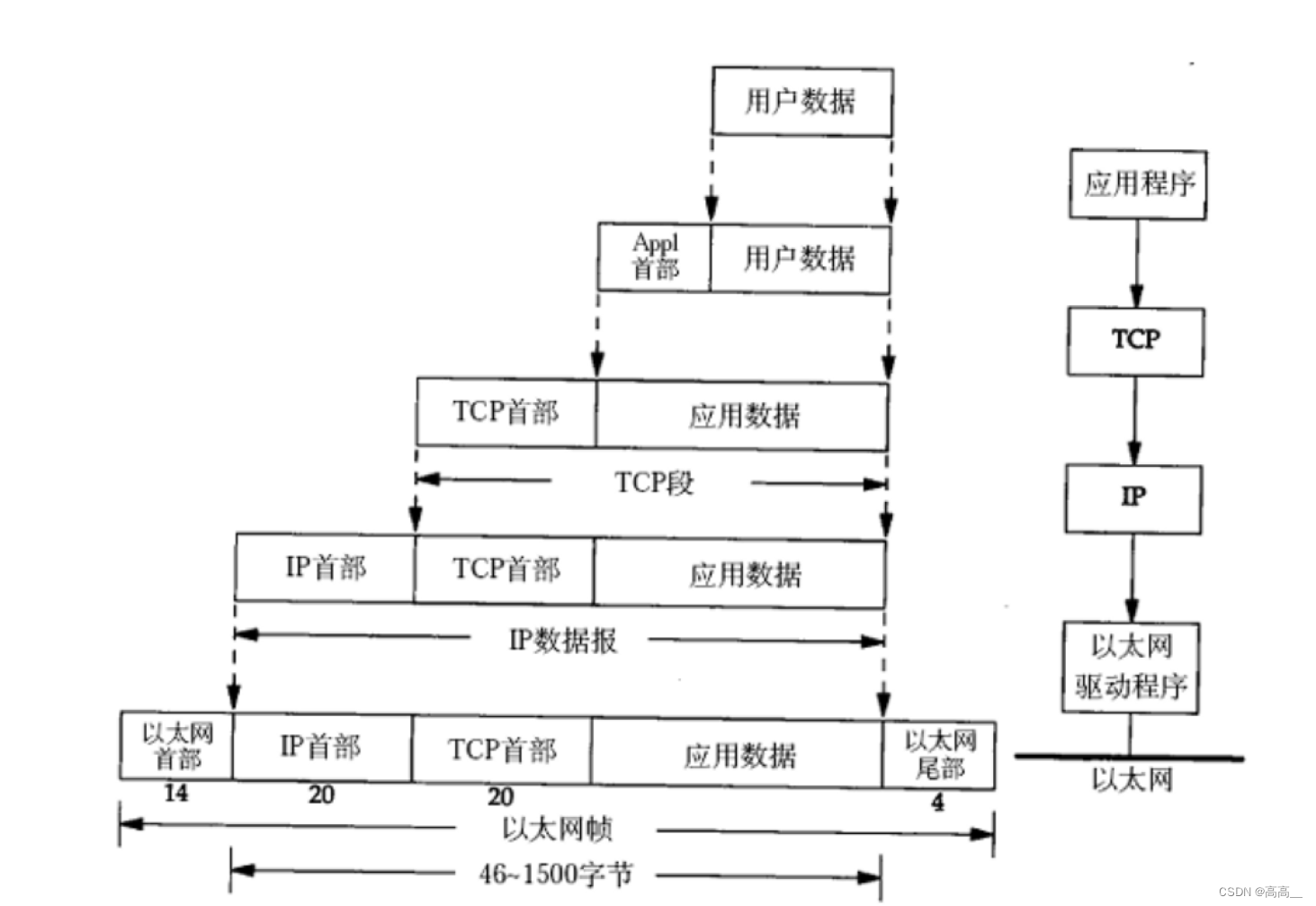

Flume 基础架构

Agent

Agent 是一个JVM进程,它以事件的形式将数据从源头送至目的。

Agent 主要有3个部分组成,Source、Channel、Sink。

Source

Source 是负责接收数据到Flume Agent的组件。Source组件可以处理各种类型、各种

格式的日志数据,包括avro、thrift、exec、jms、spooling directory、netcat、taildir、sequence generator、syslog、http、legacy。

Sink

Sink 不断地轮询 Channel 中的事件且批量地移除它们,并将这些事件批量写入到存储或索引系统、或者被发送到另一个Flume Agent。

Sink 组件目的地包括hdfs、logger、avro、thrift、ipc、file、HBase、solr、自定义。

Channel

Channel 是位于Source 和Sink之间的缓冲区。因此,Channel允许Source和Sink运作在不同的速率上。Channel 是线程安全的,可以同时处理几个Source 的写入操作和几个Sink 的读取操作。

Flume 自带两种Channel:Memory Channel 和 File Channel。

Memory Channel 是内存中的队列。Memory Channel在不需要关心数据丢失的情景下适

用。如果需要关心数据丢失,那么Memory Channel就不应该使用,因为程序死亡、机器宕机或者重启都会导致数据丢失。

File Channel 将所有事件写到磁盘。因此在程序关闭或机器宕机的情况下不会丢失数

据。

Event

传输单元,Flume 数据传输的基本单元,以Event 的形式将数据从源头送至目的地。Event 由Header 和 Body 两部分组成,Header用来存放该event的一些属性,为K-V结构,Body 用来存放该条数据,形式为字节数组。

Flume 安装部署

安装地址

(1)Flume 官网地址:http://flume.apache.org/

(2)文档查看地址:http://flume.apache.org/FlumeUserGuide.html

(3)下载地址:http://archive.apache.org/dist/flume

(4)Flume tar包

链接:https://pan.baidu.com/s/1O_CEiuHafNyuWSsrtZaydg?pwd=kw9k

提取码:kw9k

安装部署

(1)将apache-flume-1.9.0-bin.tar.gz 上传到 linux 的/opt/software 目录下

(2)解压apache-flume-1.9.0-bin.tar.gz 到/opt/module/目录下

[yudan@hadoop102 software]$ tar -zxf /opt/software/apache-flume-1.9.0-bin.tar.gz -C /opt/module/

(3)修改apache-flume-1.9.0-bin 的名称为flume

[yudan@hadoop102 module]$ mv /opt/module/apache-flume-1.9.0-bin /opt/module/flume

(4)将lib文件夹下的guava-11.0.2.jar删除以兼容Hadoop 3.1.3

[yudan@hadoop102 lib]$ rm /opt/module/flume/lib/guava-11.0.2.jar

Flume 入门案例

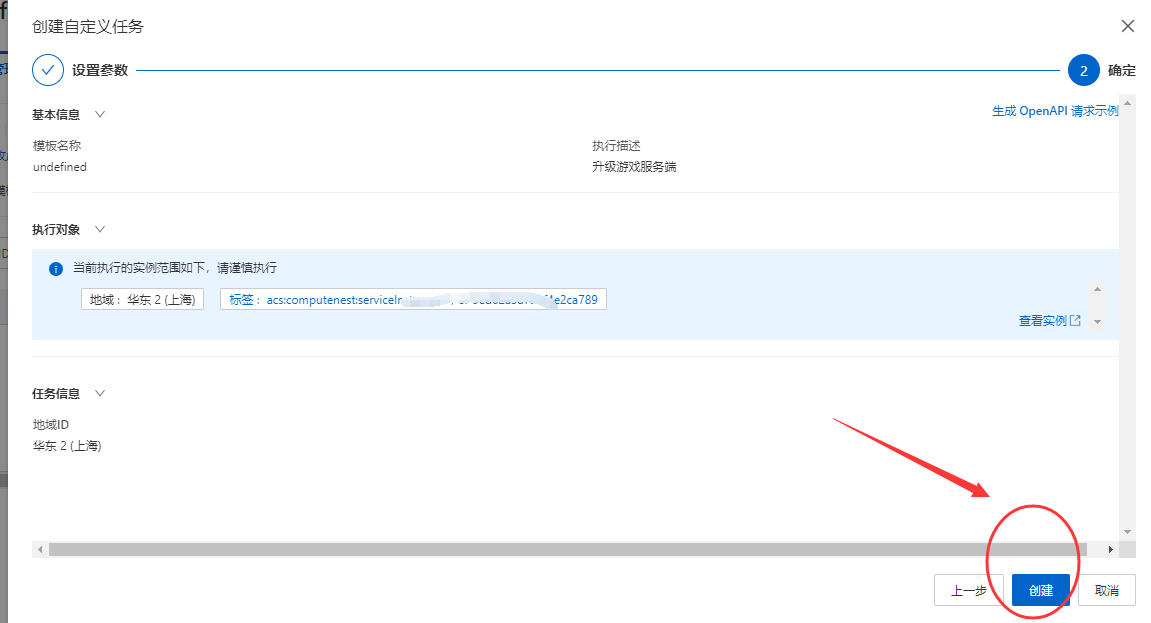

监控端口数据官方案例

1)案例需求:

使用Flume监听一个端口,收集该端口数据,并打印到控制台。

2)需求分析:

3)实现步骤:

(1)安装netcat工具

[yudan@hadoop102 software]$ sudo yum install -y nc

(2)判断44444端口是否被占用

[yudan@hadoop102 flume-telnet]$ sudo netstat -nlp | grep 44444

(3)创建Flume Agent配置文件flume-netcat-logger.conf

(4)在flume目录下创建job文件夹并进入job文件夹。

[yudan@hadoop102 flume]$ mkdir job

[yudan@hadoop102 flume]$ cd job/

(5)在job文件夹下创建Flume Agent配置文件flume-netcat-logger.conf

[yudan@hadoop102 job]$ vim flume-netcat-logger.conf

(6)在flume-netcat-logger.conf 文件中添加如下内容。

# Name the components on this agent

a1.sources = r1

a1.sinks = k1

a1.channels = c1 # Describe/configure the source

a1.sources.r1.type = netcat

a1.sources.r1.bind = localhost

a1.sources.r1.port = 44444 # Describe the sink

a1.sinks.k1.type = logger # Use a channel which buffers events in memory

a1.channels.c1.type = memory

a1.channels.c1.capacity = 1000

a1.channels.c1.transactionCapacity = 100# Bind the source and sink to the channel

a1.sources.r1.channels = c1

a1.sinks.k1.channel = c1

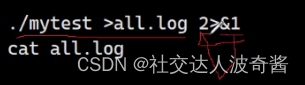

(7)先开启flume监听端口

-

第一种写法:

[yudan@hadoop102 flume]$ bin/flume-ng agent -c conf/ -n a1 -f job/flume-netcat-logger.conf -Dflume.root.logger=INFO,console -

第二种写法:

[yudan@hadoop102 flume]$ bin/flume-ng agent -c conf/ -n a1 -f job/flume-netcat-logger.conf -Dflume.root.logger=INFO,console -

参数说明:

- –conf/-c:表示配置文件存储在conf/目录

- –name/-n:表示给agent起名为a1

- –conf-file/-f:flume 本次启动读取的配置文件是在 job 文件夹下的 flume-telnet.conf

文件。 - -Dflume.root.logger=INFO,console :-D 表示 flume 运行时动态修改 flume.root.logger参数属性值,并将控制台日志打印级别设置为INFO级别。日志级别包括:log、info、warn、error。

(8)使用netcat工具向本机的44444端口发送内容

[yudan@hadoop102 ~]$ nc localhost 44444

hello

yudan

(9)在Flume监听页面观察接收数据情况

实时监控单个追加文件

1)案例需求:实时监控Hive日志,并上传到HDFS中

2)需求分析:

3)实现步骤:

(1)Flume 要想将数据输出到HDFS,依赖Hadoop相关jar包

检查/etc/profile.d/my_env.sh 文件,确认 Hadoop和 Java 环境变量配置正确

JAVA_HOME=/opt/module/jdk1.8.0_212

HADOOP_HOME=/opt/module/hadoop-3.1.3

PATH=$PATH:$JAVA_HOME/bin:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

export PATH JAVA_HOME HADOOP_HOME

(2)创建flume-file-hdfs.conf 文件

[yudan@hadoop102 job]$ vim flume-file-hdfs.conf

注:要想读取Linux系统中的文件,就得按照Linux命令的规则执行命令。由于Hive日志在 Linux 系统中所以读取文件的类型选择:exec 即 execute 执行的意思。表示执行Linux 命令来读取文件。

# Name the components on this agent

a2.sources = r2

a2.sinks = k2

a2.channels = c2 # Describe/configure the source

a2.sources.r2.type = exec

a2.sources.r2.command = tail -F /opt/module/hive/logs/hive.log # Describe the sink

a2.sinks.k2.type = hdfs

a2.sinks.k2.hdfs.path = hdfs://hadoop102:8020/flume/%Y%m%d/%H

#上传文件的前缀

a2.sinks.k2.hdfs.filePrefix = logs-

#是否按照时间滚动文件夹

a2.sinks.k2.hdfs.round = true

#多少时间单位创建一个新的文件夹

a2.sinks.k2.hdfs.roundValue = 1

#重新定义时间单位

a2.sinks.k2.hdfs.roundUnit = hour

#是否使用本地时间戳

a2.sinks.k2.hdfs.useLocalTimeStamp = true

#积攒多少个Event才flush到HDFS一次

a2.sinks.k2.hdfs.batchSize = 100

#设置文件类型,可支持压缩

a2.sinks.k2.hdfs.fileType = DataStream

#多久生成一个新的文件

a2.sinks.k2.hdfs.rollInterval = 60

#设置每个文件的滚动大小

a2.sinks.k2.hdfs.rollSize = 134217700

#文件的滚动与Event数量无关

a2.sinks.k2.hdfs.rollCount = 0 # Use a channel which buffers events in memory

a2.channels.c2.type = memory

a2.channels.c2.capacity = 1000

a2.channels.c2.transactionCapacity = 100 # Bind the source and sink to the channel

a2.sources.r2.channels = c2

a2.sinks.k2.channel = c2

a2.sinks.k2.hdfs.path = hdfs://hadoop102:端口号/flume/%Y%m%d/%H

端口号是NameNode的地址,这个端口号在/opt/module/hadoop-3.1.3/etc/hadoop下core-site.xml文件中的fs.defaultFS配置过

注意:对于所有与时间相关的转义序列,Event Header中必须存在以 “timestamp”的

key(除非hdfs.useLocalTimeStamp设置为true,此方法会使用TimestampInterceptor自

动添加timestamp)。

a3.sinks.k3.hdfs.useLocalTimeStamp = true

(3)运行Flume

[yudan@hadoop102 flume]$ bin/flume-ng agent -c conf/ -n a2 -f job/flume-file-hdfs.conf

(4)开启Hadoop和Hive并操作Hive产生日志

[yudan@hadoop102 hadoop-3.1.3]$ sbin/start-dfs.sh

[yudan@hadoop103 hadoop-3.1.3]$ sbin/start-yarn.sh[yudan@hadoop102 hive]$ bin/hive

hive (default)>

(5)在HDFS上查看文件。

实时监控目录下多个新文件

1)案例需求:使用Flume监听整个目录的文件,并上传至HDFS

2)需求分析:

3)实现步骤:

(1)创建配置文件flume-dir-hdfs.conf

创建一个文件

[yudan@hadoop102 job]$ vim flume-dir-hdfs.conf

# 添加以下内容a3.sources = r3

a3.sinks = k3

a3.channels = c3 # Describe/configure the source

a3.sources.r3.type = spooldir

a3.sources.r3.spoolDir = /opt/module/flume/upload

a3.sources.r3.fileSuffix = .COMPLETED

a3.sources.r3.fileHeader = true

#忽略所有以.tmp结尾的文件,不上传

a3.sources.r3.ignorePattern = ([^ ]*\.tmp) # Describe the sink

a3.sinks.k3.type = hdfs

a3.sinks.k3.hdfs.path =

hdfs://hadoop102:8020/flume/upload/%Y%m%d/%H

#上传文件的前缀

a3.sinks.k3.hdfs.filePrefix = upload-

#是否按照时间滚动文件夹

a3.sinks.k3.hdfs.round = true

#多少时间单位创建一个新的文件夹

a3.sinks.k3.hdfs.roundValue = 1

#重新定义时间单位

a3.sinks.k3.hdfs.roundUnit = hour

#是否使用本地时间戳

a3.sinks.k3.hdfs.useLocalTimeStamp = true

#积攒多少个Event才flush到HDFS一次

a3.sinks.k3.hdfs.batchSize = 100

#设置文件类型,可支持压缩

a3.sinks.k3.hdfs.fileType = DataStream

#多久生成一个新的文件

a3.sinks.k3.hdfs.rollInterval = 60

#设置每个文件的滚动大小大概是128M

a3.sinks.k3.hdfs.rollSize = 134217700

#文件的滚动与Event数量无关

a3.sinks.k3.hdfs.rollCount = 0 # Use a channel which buffers events in memory

a3.channels.c3.type = memory

a3.channels.c3.capacity = 1000

a3.channels.c3.transactionCapacity = 100 # Bind the source and sink to the channel

a3.sources.r3.channels = c3

a3.sinks.k3.channel = c3

(2)启动监控文件夹命令

[yudan@hadoop102 flume]$ bin/flume-ng agent -c conf/ -n a3 -f job/flume-dir-hdfs.conf

说明:在使用Spooling Directory Source 时,不要在监控目录中创建并持续修改文件;上传完成的文件会以.COMPLETED结尾;被监控文件夹每500毫秒扫描一次文件变动。

(3)向upload文件夹中添加文件

在/opt/module/flume 目录下创建upload 文件夹

[yudan@hadoop102 flume]$ mkdir upload

向upload文件夹中添加文件

[yudan@hadoop102 upload]$ touch 1.txt

[yudan@hadoop102 upload]$ touch 2.tmp

[yudan@hadoop102 upload]$ touch 3.log

(4)查看HDFS上的数据

实时监控目录下的多个追加文件

Exec source 适用于监控一个实时追加的文件,不能实现断点续传;Spooldir Source适合用于同步新文件,但不适合对实时追加日志的文件进行监听并同步;而Taildir Source适合用于监听多个实时追加的文件,并且能够实现断点续传。

1)案例需求:使用Flume监听整个目录的实时追加文件,并上传至HDFS

2)需求分析:

3)实现步骤:

(1)创建配置文件flume-taildir-hdfs.conf

创建一个文件

[yudan@hadoop102 job]$ vim flume-taildir-hdfs.conf

# 添加如下内容

a3.sources = r3

a3.sinks = k3

a3.channels = c3 # Describe/configure the source

a3.sources.r3.type = TAILDIR

a3.sources.r3.positionFile = /opt/module/flume/tail_dir.json

a3.sources.r3.filegroups = f1 f2

a3.sources.r3.filegroups.f1 = /opt/module/flume/files/.*file.*

a3.sources.r3.filegroups.f2 = /opt/module/flume/files2/.*log.* # Describe the sink

a3.sinks.k3.type = hdfs

a3.sinks.k3.hdfs.path =

hdfs://hadoop102:8020/flume/upload2/%Y%m%d/%H

#上传文件的前缀

a3.sinks.k3.hdfs.filePrefix = upload-

#是否按照时间滚动文件夹

a3.sinks.k3.hdfs.round = true

#多少时间单位创建一个新的文件夹

a3.sinks.k3.hdfs.roundValue = 1

#重新定义时间单位

a3.sinks.k3.hdfs.roundUnit = hour

#是否使用本地时间戳

a3.sinks.k3.hdfs.useLocalTimeStamp = true

#积攒多少个Event才flush到HDFS一次

a3.sinks.k3.hdfs.batchSize = 100

#设置文件类型,可支持压缩

a3.sinks.k3.hdfs.fileType = DataStream

#多久生成一个新的文件

a3.sinks.k3.hdfs.rollInterval = 60

#设置每个文件的滚动大小大概是128M

a3.sinks.k3.hdfs.rollSize = 134217700

#文件的滚动与Event数量无关

a3.sinks.k3.hdfs.rollCount = 0 # Use a channel which buffers events in memory

a3.channels.c3.type = memory

a3.channels.c3.capacity = 1000

a3.channels.c3.transactionCapacity = 100 # Bind the source and sink to the channel

a3.sources.r3.channels = c3

a3.sinks.k3.channel = c3

(2)启动监控文件夹命令

[yudan@hadoop102 flume]$ bin/flume-ng agent -cconf/ -n a3 -f job/flume-taildir-hdfs.conf

(3)向files文件夹中追加内容

在/opt/module/flume目录下创建files文件夹

[yudan@hadoop102 flume]$ mkdir files 向upload文件夹中添加文件

[yudan@hadoop102 files]$ echo hello >> file1.txt

[yudan@hadoop102 files]$ echo atguigu >> file2.txt

(4)查看HDFS上的数据

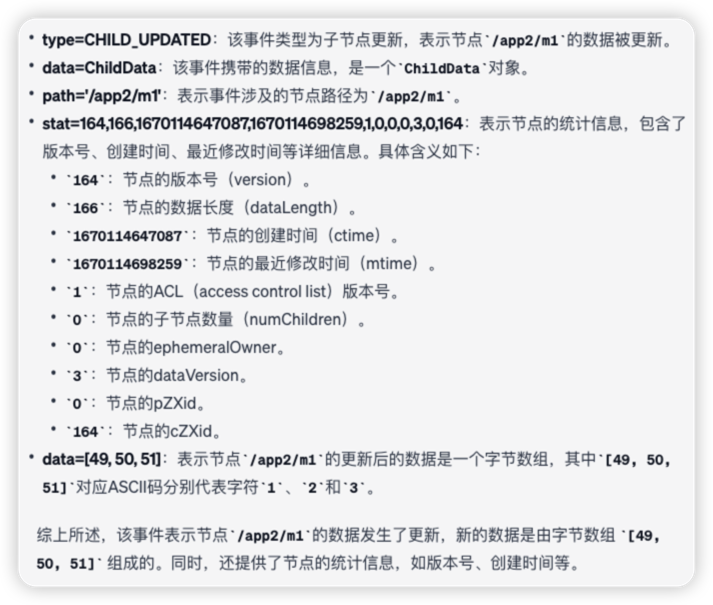

Taildir 说明:

Taildir Source 维护了一个json 格式的position File,其会定期的往position File中更新每个文件读取到的最新的位置,因此能够实现断点续传。Position File的格式如下:

{"inode":2496272,"pos":12,"file":"/opt/module/flume/files/file1.txt"}

{"inode":2496275,"pos":12,"file":"/opt/module/flume/files/file2.txt"}

注:Linux中储存文件元数据的区域就叫做inode,每个inode都有一个号码,操作系统用inode 号码来识别不同的文件,Unix/Linux系统内部不使用文件名,而使用inode号码来识别文件。