一、全文检索基础

1. 什么是全文检索

将⾮结构化数据中的⼀部分信息提取出来,重新组织,使其变得有⼀定结构,然后对此有⼀定结构的数

据进⾏搜索,从⽽达到搜索相对较快的⽬的。这部分从⾮结构化数据中提取出的然后重新组织的信息,

我们称之索引。

例如:字典。字典的拼⾳表和部⾸检字表就相当于字典的索引,对每⼀个字的解释是⾮结构化的,如果

字典没有⾳节表和部⾸检字表,在茫茫辞海中找⼀个字只能顺序扫描。然⽽字的某些信息可以提取出来

进⾏结构化处理,⽐如读⾳,就⽐较结构化,分声母和韵母,分别只有⼏种可以⼀⼀列举,于是将读⾳

拿出来按⼀定的顺序排列,每⼀项读⾳都指向此字的详细解释的页数。我们搜索时按结构化的拼⾳搜到

读⾳,然后按其指向的页数,便可找到我们的⾮结构化数据——也即对字的解释。

这种先建⽴索引,再对索引进⾏搜索的过程就叫全⽂检索(Full-text Search)。

虽然创建索引的过程也是⾮常耗时的,但是索引⼀旦创建就可以多次使⽤,全⽂检索主要处理的是查

询,所以耗时间创建索引是值得的。

2.全文检索流程

3.相关概念

1.索引库

索引库就是存储索引的保存在磁盘上的⼀系列的⽂件。⾥⾯存储了建⽴好的索引信息以及⽂档对象。

一个索引库相当于数据库中的一张表

2.document对象

获取原始内容的目的是为了索引,在索引前需要将原始内容创建成文档(Document),⽂档中包括⼀个⼀个的域(Field),域中存储内容。每个⽂档都有⼀个唯⼀的编号,就是⽂档id。

document对象相当于表中的一条记录

3.field对象

如果我们把document看做是数据库中⼀条记录的话,field相当于是记录中的字段。field是索引库中存储数据的最⼩单位。field的数据类型⼤致可以分为数值类型和⽂本类型,⼀般需要查询的字段都是⽂本类型的,field的还有如下属性:

- 是否分词:是否对域的内容进⾏分词处理。前提是我们要对域的内容进⾏查询。

- 是否索引:将Field分析后的词或整个Field值进⾏索引,只有索引⽅可搜索到。⽐如:商品名称、商品简介分析后进⾏索引,订单号、⾝份证号不⽤分词但也要索引,这些将来都要作为查询条件。

- 是否存储:将Field值存储在⽂档中,存储在⽂档中的Field才可以从Document中获取⽐如:商品名称、订单号,凡是将来要从Document中获取的Field都要存储。

- term对象

从⽂档对象中拆分出来的每个单词叫做⼀个Term,不同的域中拆分出来的相同的单词是不同的term。term中包含两部分⼀部分是⽂档的域名,另⼀部分是单词的内容。term是创建索引的关键词对象。

二、Elasticsearch简介

2.1什么是ElasticSearch

Elaticsearch,简称为es, es是⼀个开源的⾼扩展的分布式全⽂检索引擎,它可以近乎实时的存储、检索数据;本⾝扩展性很好,可以扩展到上百台服务器,处理PB级别的数据。es也使⽤Java开发并使⽤Lucene作为其核⼼来实现所有索引和搜索的功能,但是它的⽬的是通过简单的RESTful API来隐藏Lucene的复杂性,从⽽让全⽂搜索变得简单。

2.2Elasticsearch的使用案例

- 2013年初,GitHub抛弃了Solr,采取ElasticSearch 来做PB级的搜索。 “GitHub使⽤ElasticSearch搜索20TB的数据,包括13亿⽂件和1300亿⾏代码”

- 维基百科:启动以elasticsearch为基础的核⼼搜索架构

- SoundCloud:“SoundCloud使⽤ElasticSearch为1.8亿⽤户提供即时⽽精准的⾳乐搜索服务”

- 百度:百度⽬前⼴泛使⽤ElasticSearch作为⽂本数据分析,采集百度所有服务器上的各类指标数据及⽤户⾃定义数据,通过对各种数据进⾏多维分析展⽰,辅助定位分析实例异常或业务层⾯异常。⽬前覆盖百度内部20多个业务线(包括casio、云分析、⽹盟、预测、⽂库、直达号、钱包、风控等),单集群最⼤100台机器,200个ES节点,每天导⼊30TB+数据

- 新浪使⽤ES 分析处理32亿条实时⽇志

- 阿⾥使⽤ES 构建挖财⾃⼰的⽇志采集和分析体系

2.3Elasticsearch对比Solr

- Solr 利⽤ Zookeeper 进⾏分布式管理,⽽ Elasticsearch ⾃⾝带有分布式协调管理功能;

- Solr ⽀持更多格式的数据,⽽ Elasticsearch 仅⽀持json⽂件格式;

- Solr 官⽅提供的功能更多,⽽ Elasticsearch 本⾝更注重于核⼼功能,⾼级功能多有第三⽅插件提供;

- Solr 在传统的搜索应⽤中表现好于 Elasticsearch,但在处理实时搜索应⽤时效率明显低于Elasticsearch

三、Elasticsearch相关术语

3.1概述

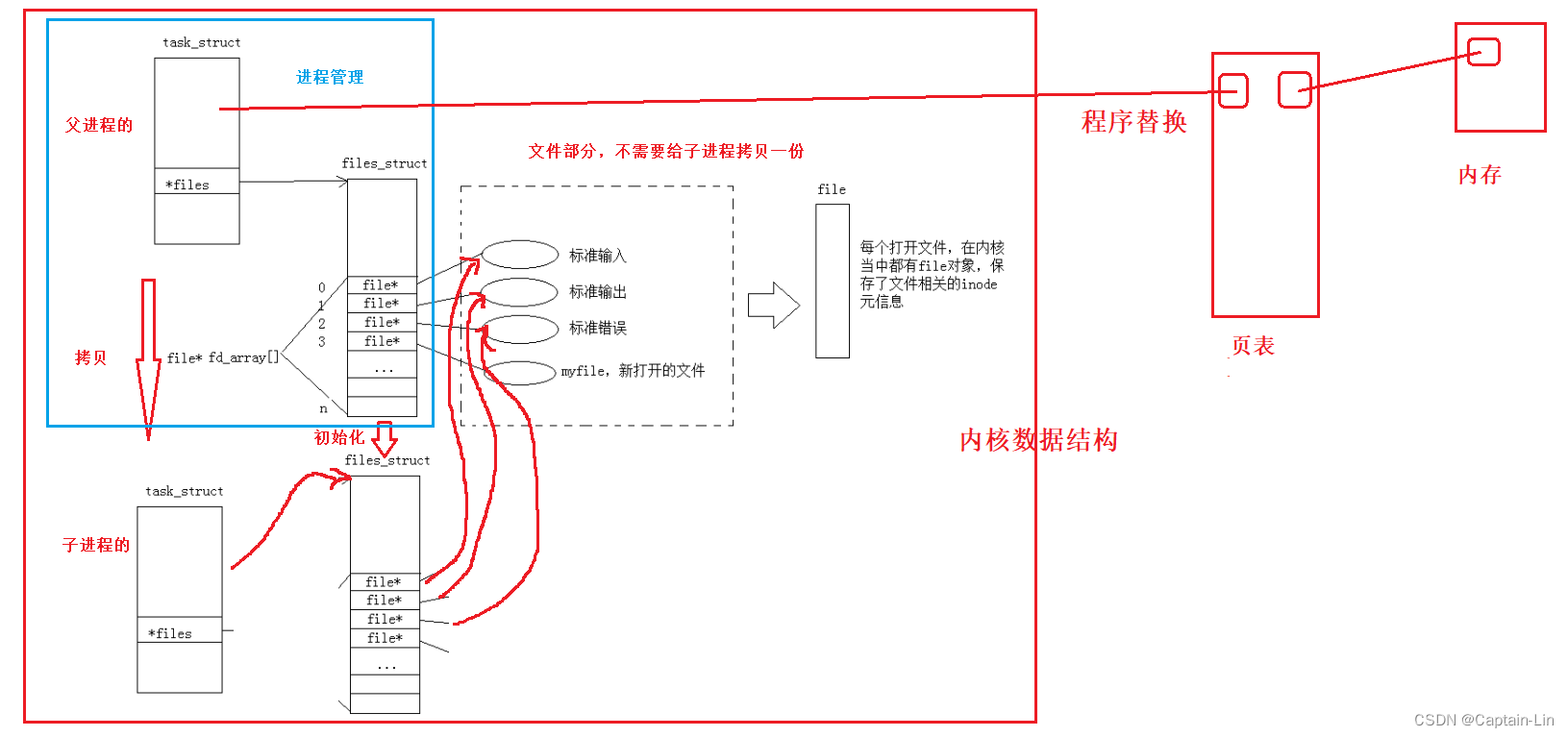

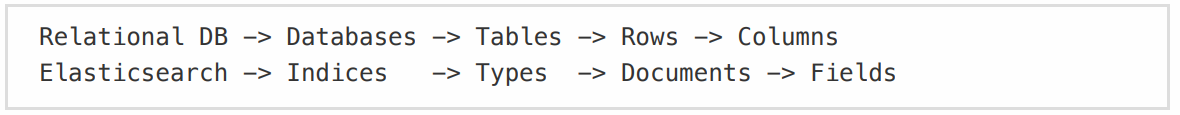

Elasticsearch是面向文档(document oriented)的,这意味着它可以存储整个对象或文档(document)。然而它不仅仅是存储,还会索引(index)每个文档内容使之可以被搜索。在Elasticsearch中,你可以对文档(而非成行成列的数据)进行索引、搜索、排序、过滤。Elasticsearch对比统关系型数据库如下:

3.2Elsticsearch核心概念

3.2.1 索引 index

一个索引就是一个拥有积分相似特征的文档集合。比如说,你可以有一个用户数据的索引,另一个产品目录的索引,还有一个订单数据的索引,还有一个订单数据的索引。一个索引由一个名字来标识(必须全部是小写字母),并且当我们对对应于这个索引中的文档进行索引、搜索、更新和删除的时候,都要使用到这个名字。在一个集群中,可以定义任意多的索引。

3.2.2 类型 type

在一个索引中,你可以定义一种或多种类型。一个类型是你的索引的一个逻辑上的分类/分区,其语义完全由你来定。通常,会为具有一组共同字段的文档定义一个类型。比如说,我们假设你运营一个博客平台并且将你所有的数据存储到一个索引中。在这个索引中,你可以为用户数据定义一个类型,为博客数据定义一个类型,当然,也可以为评论数据定义另一个类型。

3.2.3 字段 field

相当于是数据表的字段,对文档数据根据不同数据进行的分类标识。

3.2.4 映射 mapping

mapping 是处理数据的方式和规则方面做一些限制,比如某个字段的数据类型、默认值、分析器、是否被索引等等,这些都是映射里面可以设置的,其他就是处理es里面数据的一些使用规则设置也叫做映射,按着最优规则处理数据对性能提高很大,因此才需要建立映射,并且需要思考如何建立映射才能对性能更好。

3.2.5 文档 document

一个文档是一个可被索引的基础信息单元。比如,你可以拥有某一个客户文案,某一个产品的一个文档,当然,也可以拥有某个订单的一个文档。文档以JSON(JavaScript Object Notation)格式来表示,而JSON是一个到处存在的互联网数据交互格式。

在一个index/type里面,你可以存储任意多的文档。注意,尽管一个文档,物理上存在于一个索引之中,文档必须被索引/赋予一个索引的type。

3.2.6 接近实施 NRT

Elasticsearch是一个接近实时的搜索平台。这意味着,从索引一个文档直到这个文档能够被搜索到有一个轻微的延迟(通常是1秒以内)

3.2.7 集群 cluster

一个集群就是一个或多个节点组织在一起,他们共同持有整个数据,并一起提供索引和搜索功能。一个集群由一个唯一的名字标识,这个名字默认就是"elasticsearch"。这个名字很重要,因为一个节点智能通过指定某个集群的名字,来加入这个集群。

3.2.8 节点 node

一个节点是集群中的一个服务器,作为集群的一部分,它存储数据,参与集群的索引和搜索功能。和集群类似,一个节点也是由一个名字标识的,默认情况下,这个名字是一个随机的漫威漫画角色名字,这个名字会在启动的时候赋予节点。这个名字对于管理工作来说挺重要的,因为在这个管理过程中,你会去确定网络中的哪些服务器对应于Elasticsearch集群中的哪些节点。

一个节点可以通过配置集群名称的方式来加入一个指定的集群。默认情况下,每个节点都会被安排加入到一个叫做"elasticseach"的集群中,这意味着,如果在你的网络中启动了若干个节点,并假定它们能够相互发现彼此,它们将会自动地形成并加入到一个叫做“elasticsearch”的集群中。

在一个集群里,只要你想,可以拥有任意多个节点。并且,如果当你的网络中没有任何Elasticsearch节点,这是启动一个节点,会默认创建并加入一个叫做"elasticsearch"的集群。

3.2.9 分片和复制shards&replicas

⼀个索引可以存储超出单个结点硬件限制的⼤量数据。⽐如,⼀个具有10亿⽂档的索引占据1TB的磁盘空间,⽽任⼀节点都没有这样⼤的磁盘空间;或者单个节点处理搜索请求,响应太慢。为了解决这个问题,Elasticsearch提供了将索引划分成多份的能⼒,这些份就叫做分⽚。当你创建⼀个索引的时候,你可以指定你想要的分⽚的数量。每个分⽚本⾝也是⼀个功能完善并且独⽴的“索引”,这个“索引”可以被放置到集群中的任何节点上。分⽚很重要,主要有两⽅⾯的原因:

1)允许你⽔平分割/扩展你的内容容量。

2)允许你在分⽚(潜在地,位于多个节点上)之上进⾏分布式的、并⾏的操作,进⽽提⾼性能/吞吐量。⾄于⼀个分⽚怎样分布,它的⽂档怎样聚合回搜索请求,是完全由Elasticsearch管理的,对于作为⽤户的你来说,这些都是透明的。在⼀个⽹络/云的环境⾥,失败随时都可能发⽣,在某个分⽚/节点不知怎么的就处于离线状态,或者由于任何原因消失了,这种情况下,有⼀个故障转移机制是⾮常有⽤并且是强烈推荐的。为此⽬的,Elasticsearch允许你创建分⽚的⼀份或多份拷贝,这些拷贝叫做复制分⽚,或者直接叫复制。复制之所以重要,有两个主要原因: 在分⽚/节点失败的情况下,提供了⾼可⽤性。因为这个原因,注\意到复制分⽚从不与原/主要(original/primary)分⽚置于同⼀节点上是⾮常重要的。扩展你的搜索量/吞吐量,因为搜索可以在所有的复制上并⾏运⾏。总之,每个索引可以被分成多个分⽚。⼀个索引也可以被复制0次(意思是没有复制)或多次。⼀旦复制了,每个索引就有了主分⽚(作为复制源的原来的分⽚)和复制分⽚(主分⽚的拷贝)之别。分⽚和复制的数量可以在索引创建的时候指定。在索引创建之后,你可以在任何时候动态地改变复制的数量,但是你事后不能改变分⽚的数量。默认情况下,Elasticsearch中的每个索引被分⽚5个主分⽚和1个复制,这意味着,如果你的集群中⾄少有两个节点,你的索引将会有5个主分⽚和另外5个复制分⽚(1个完全拷贝),这样的话每个索引总共就有10个分⽚。

四、Elasticsearch安装

使用docker 安装 elasticsearch

- docker 镜像下载

docker pull elasticsearch:5.6.8

- 查看镜像是否下载成功

docker iamges

安装成功如图:

3. 运行容器

docker run -di --name=kkb_es -p 9200:9200 -p 9300:9300 elasticsearch:5.6.8

9200端⼜(Web管理平台端⼜) 9300(服务默认端⼜)

浏览器输⼊地址访问:http://自己的ip:9200/

4. 开启远程连接

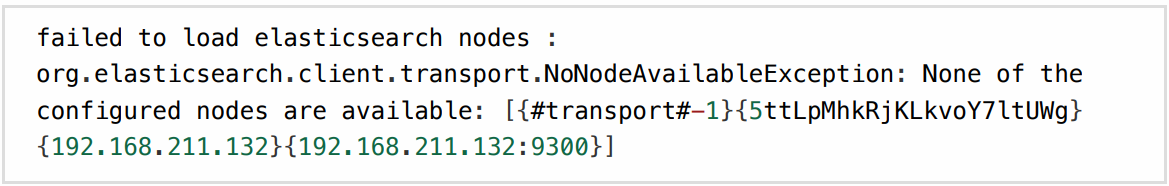

上⾯完成安装后,es并不能正常使⽤,elasticsearch从5版本以后默认不开启远程连接,程序直接连接会报如下错误:

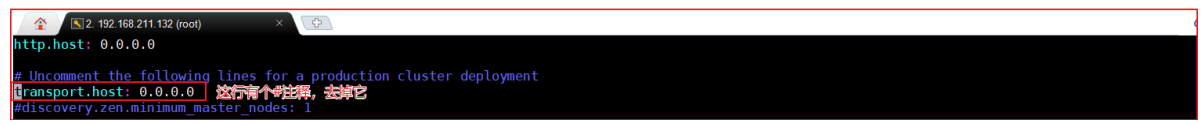

我们需要修改es配置开启远程连接,代码如下:

登录容器

docker exec -it kkb_es /bin/bash

- 安装vim编辑器

apt-get update

apt-get install

- 修改配置文件

vim elasticsearch.yml

同时添加代码

cluster.name: my-elasticsearch# 解决跨域问题

http.cors.enabled: true

http.cors.allow-origin: "*"

network.host: 192.168.220.100

- 重启docker

docker restart kkb_es

- 参数配置

重启后发现重启启动失败了,这时什么原因呢?这与我们刚才修改的配置有关,因为elasticsearch在启动的时候会进⾏⼀些检查,⽐如最多打开的⽂件的个数以及虚拟内存区域数量等等,如果你放开了此配置,意味着需要打开更多的⽂件以及虚拟内存,所以我们还需要系统调优修改vi /etc/security/limits.conf ,追加内容 (nofile是单个进程允许打开的最⼤⽂件个数 soft nofile 是软限制 hard nofile是硬限制 ),(追加到文档末尾即可)

* soft nofile 65536

* hard nofile 65536

修改vi /etc/sysctl.conf,追加内容 (限制⼀个进程可以拥有的VMA(虚拟内存区域)的数量 )

vm.max_map_count=655360

执⾏下⾯命令 修改内核参数马上⽣效

sysctl -p

重启虚拟机、再次启动容器,发下已经可以启动并远程访问

reboot

⼩提⽰:如果想让容器开机重启,可以执⾏下⾯命令

docker update --restart=always + 容器名称或者id

五、ElasticSearch的客户端(Kibana)

使用docker 安装Kibana

- 镜像下载

docke pull docker.io/kibana:5.6.8

为了节省时间,虚拟机中已经存在该版本镜像了。

- 安装kibana容器

执行如下命令,开始安装kibana容器

docker run -it -d -e ELASTICSEARCH_URL=http://192.168.220.100:9200 --namekibana -p 5601:5601 kibana:5.6.8

ELASTICSEARCH_URL=http://192.168.220.100:9200:是指链接的ES地址

restart=always:每次服务都会重启,也就是开启启动

5601:5601:端⼜号

- 访问测试

访问http://192.168.220.100:5601如下:

Kibana使用

要使⽤Kibana,您必须⾄少配置⼀个索引。索引⽤于标识Elasticsearch索引以运⾏搜索和分析。它们还⽤于配置字段。

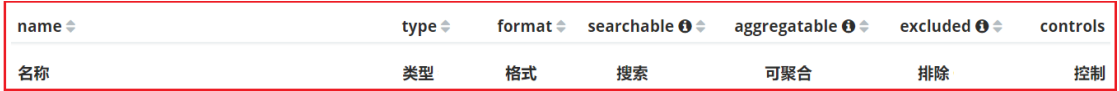

我们修改索引名称的匹配⽅式即可,下⾯2个选项不⽤勾选。点击create,会展⽰出当前配置的索引的域信息,如下图:

域的每个标题选项分别代表如下意思:

数据搜索

Discover为数据搜索部分,可以对⽇志信息进⾏搜索操作。

可以使⽤Discover实现数据搜索过滤和搜索条件显⽰以及关键词搜索,如下图:

DSL语句使用

DSL介绍

Query DSL是⼀个Java开源框架⽤于构建类型安全的SQL查询语句。采⽤API代替传统的拼接字符串来构造查询语句。⽬前Querydsl⽀持的平台包括JPA,JDO,SQL,Java Collections,RDF,Lucene,Hibernate Search。elasticsearch提供了⼀整套基于JSON的DSL语⾔来定义查询。

索引操作

- 查询所有索引

GET /_cat/indices?v

结果如下:

2. 删除某个索引

DELETE /skuinfo

效果如下:

3. 新增索引

PUT /user

效果如下:

4. 创建映射

PUT /user/userinfo/_mapping{"properties": {"name":{"type": "text","analyzer": "ik_smart","search_analyzer": "ik_smart"},"city":{"type": "text","analyzer": "ik_smart","search_analyzer": "ik_smart"},"age":{"type": "long"},"description":{"type": "text","analyzer": "ik_smart","search_analyzer": "ik_smart"}}

}

5.新增文档数据

PUT /user/userinfo/1

{"name":"李四","age":22,"city":"深圳","description":"李四来⾃湖北武汉!"

}

- 更新数据

#更新数据,id=4

PUT /user/userinfo/4

{"name":"张三丰","description":"在武汉读书,家在武汉!在深圳⼯作!"

}

Spring Data ElasticSearch

Spring Data ElasticSearch 基于 spring data API 简化 elasticSearch操作,将原始操作elasticSearch的客户端API 进⾏封装 。Spring Data为Elasticsearch项⽬提供集成搜索引擎。Spring Data ElasticsearchPOJO的关键功能区域为中⼼的模型与Elastichsearch交互⽂档和轻松地编写⼀个存储库数据访问层。官⽅⽹站:http://projects.spring.io/spring-data-elasticsearch/

- 导入Spring Data ElasticSearch做标记

<?xml version="1.0" encoding="UTF-8"?>

<project xmlns="http://maven.apache.org/POM/4.0.0" xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 https://maven.apache.org/xsd/maven-4.0.0.xsd"><modelVersion>4.0.0</modelVersion><parent><groupId>org.springframework.boot</groupId><artifactId>spring-boot-starter-parent</artifactId><version>2.1.5.RELEASE</version><relativePath/> <!-- lookup parent from repository --></parent><groupId>com.wz.es</groupId><artifactId>es-demo2</artifactId><version>0.0.1-SNAPSHOT</version><name>es-demo2</name><description>es-demo2</description><properties><java.version>1.8</java.version></properties><dependencies><dependency><groupId>org.springframework.boot</groupId><artifactId>spring-boot-starter-data-elasticsearch</artifactId></dependency><dependency><groupId>org.springframework.boot</groupId><artifactId>spring-boot-starter-test</artifactId><scope>test</scope></dependency></dependencies><build><plugins><plugin><groupId>org.springframework.boot</groupId><artifactId>spring-boot-maven-plugin</artifactId></plugin></plugins></build>

</project>- 启动器配置文件

package com.wz.esdemo2;import org.springframework.boot.SpringApplication;

import org.springframework.boot.autoconfigure.SpringBootApplication;@SpringBootApplication

public class EsDemo2Application {public static void main(String[] args) {SpringApplication.run(EsDemo2Application.class, args);}

}

spring:data:elasticsearch:cluster-name: my-elasticsearchcluster-nodes: 192.168.220.100:9300

- 编写实体Article

@Document(indexName = "lxs_blog", type = "article")

public class Article {@Id@Field(type = FieldType.Long, store = true)private long id;@Field(type = FieldType.Text, store = true, analyzer = "ik_smart")private String title;@Field(type = FieldType.Text, store = true, analyzer = "ik_smart")private String content;。。。

}

- 编写Dao

⽅法命名规则查询的基本语法findBy + 属性 + 关键词 + 连接符

package com.example.demo.repositories;

import com.example.demo.entity.Article;

import org.springframework.data.domain.Pageable;

import org.springframework.data.elasticsearch.repository.ElasticsearchRepository;

import java.util.List;public interface ArticleRepository extends ElasticsearchRepository<Article,Long> {

}

- 创建测试类

package com.example.demo;

import com.example.demo.entity.Article;

import com.example.demo.repositories.ArticleRepository;

import org.elasticsearch.index.query.QueryBuilders;

import org.junit.Test;

import org.junit.runner.RunWith;

import org.springframework.beans.factory.annotation.Autowired;

import org.springframework.boot.test.context.SpringBootTest;

import org.springframework.data.domain.PageRequest;

import org.springframework.data.domain.Pageable;

import org.springframework.data.elasticsearch.core.ElasticsearchTemplate;

import org.springframework.data.elasticsearch.core.query.NativeSearchQuery;

import org.springframework.data.elasticsearch.core.query.NativeSearchQueryBuilder;

import org.springframework.test.context.junit4.SpringRunner;

import java.util.List;

import java.util.Optional;@RunWith(SpringRunner.class)

@SpringBootTest

public class DemoApplicationTests {@Autowiredprivate ArticleRepository articleRepository;@Autowiredprivate ElasticsearchTemplate template;@Testpublic void createIndex() throws Exception {//创建索引,并配置映射关系template.createIndex(Article.class);//配置映射关系//template.putMapping(Article.class);}@Testpublic void addDocument() throws Exception {for (int i = 10; i <= 20; i++) {//创建⼀个Article对象Article article = new Article();article.setId(i);article.setTitle("⼥护⼠路遇昏迷男⼦跪地抢救:救⼈是职责更是本能" + i);article.setContent("这是⼀个美丽的⼥护⼠妹妹" + i);//把⽂档写⼊索引库articleRepository.save(article);}}@Testpublic void deleteDocumentById() throws Exception {

// articleRepository.deleteById(1l);//全部删除articleRepository.deleteAll();}@Testpublic void findAll() throws Exception {Iterable<Article> articles = articleRepository.findAll();articles.forEach(a-> System.out.println(a));}@Testpublic void testFindById() throws Exception {Optional<Article> optional = articleRepository.findById(10l);Article article = optional.get();System.out.println(article);}@Testpublic void testFindByTitle() throws Exception {List<Article> list = articleRepository.findByTitle("⼥护⼠");list.stream().forEach(a-> System.out.println(a));}@Testpublic void testFindByTitleOrContent() throws Exception {Pageable pageable = PageRequest.of(1, 5);articleRepository.findByTitleOrContent("title", "⼥护⼠", pageable).forEach(a-> System.out.println(a));}@Testpublic void testNativeSearchQuery() throws Exception {//创建⼀个查询对象NativeSearchQuery query = new NativeSearchQueryBuilder().withQuery(QueryBuilders.queryStringQuery("⼥护⼠").defaultField("title")).withPageable(PageRequest.of(0, 15)).build();//执⾏查询List<Article> articleList = template.queryForList(query,Article.class);articleList.forEach(a-> System.out.println(a));}

}