大家好,我是微学AI,今天给大家介绍一下人工智能算法工程师(中级)课程20-模型注意力机制之注意力机制的原理、计算方式与代码详解。本文深入探讨了注意力机制在深度学习中的应用与原理,尤其聚焦于序列到序列模型的上下文中。通过直观的解释和详细的代码示例,文章展示了如何使用PyTorch框架实现注意力机制,包括普通注意力和计算,自注意力和计算,多头注意力和计算,通道注意力,空间注意力,混合注意力。从理论到实践,逐步解析了注意力机制如何帮助模型更好地理解输入序列的关键部分,从而提高预测准确性。适合对深度学习和自然语言处理感兴趣的读者,尤其是希望深入了解并实际操作注意力机制的开发人员。

文章目录

- 一、引言

- 二、普通注意力与计算

- 1. 注意力的原理

- 2. PyTorch代码实现

- 三、自注意力与计算

- 1. 自注意力的原理

- 2. PyTorch代码实现

- 四、多头注意力与计算

- 1. 多头注意力的原理

- 五、通道注意力

- 1. 通道注意力的原理

- 2. PyTorch代码实现

- 六、空间注意力

- 1. 空间注意力的原理

- 2. PyTorch代码实现

- 七、混合注意力

- 1. 混合注意力的原理

- 2. PyTorch代码实现

- 八、总结

一、引言

近年来,注意力机制在深度学习领域取得了显著的成果,尤其是在自然语言处理、计算机视觉等领域。本文将详细介绍注意力机制的不同类型,包括普通注意力、自注意力、多头注意力、通道注意力、空间注意力和混合注意力,并阐述其数学原理,最后提供基于PyTorch的完整可运行代码。

二、普通注意力与计算

1. 注意力的原理

普通注意力机制的核心思想是:为输入序列中的每个元素分配一个权重,权重的大小表示该元素对输出结果的重要性。

假设输入序列为 X = { x 1 , x 2 , … , x n } X = \{x_1, x_2, \ldots, x_n\} X={x1,x2,…,xn},注意力权重为 a = { a 1 , a 2 , … , a n } a = \{a_1, a_2, \ldots, a_n\} a={a1,a2,…,an},则输出为:

O = ∑ i = 1 n a i x i O = \sum_{i=1}^{n} a_i x_i O=i=1∑naixi

其中, a i a_i ai 的计算方式为:

a i = exp ( e i ) ∑ j = 1 n exp ( e j ) a_i = \frac{\exp(e_i)}{\sum_{j=1}^{n} \exp(e_j)} ai=∑j=1nexp(ej)exp(ei)

e i = score ( x i , h ) e_i = \text{score}(x_i, h) ei=score(xi,h)

score \text{score} score 函数用于计算输入元素 x i x_i xi 与隐藏状态 h h h 的匹配程度。

2. PyTorch代码实现

import torch

import torch.nn as nn

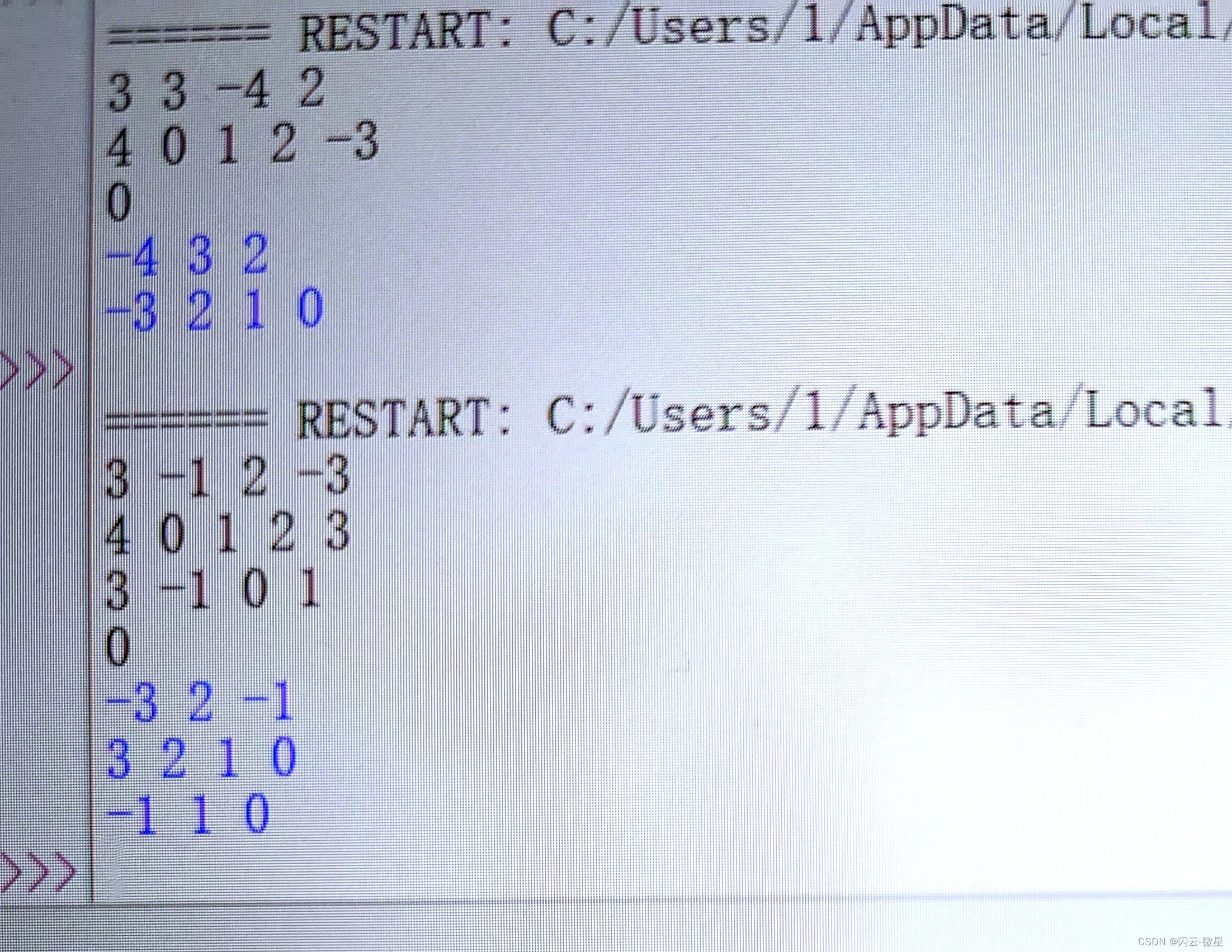

class Attention(nn.Module):def __init__(self):super(Attention, self).__init__()def forward(self, x, h):e = torch.matmul(x, h.unsqueeze(2)).squeeze(2)a = torch.softmax(e, dim=1)o = torch.sum(a.unsqueeze(2) * x, dim=1)return o

x = torch.randn(10, 5) # 假设输入序列长度为10,特征维度为5

h = torch.randn(5) # 隐藏状态维度为5

attention = Attention()

output = attention(x, h)

print(output)

三、自注意力与计算

1. 自注意力的原理

自注意力(Self-Attention)机制允许输入序列中的每个元素都与其他元素进行关联,从而更好地捕捉序列内部的依赖关系。

自注意力计算过程如下:

Q = X W Q , K = X W K , V = X W V Q = XW^Q, K = XW^K, V = XW^V Q=XWQ,K=XWK,V=XWV

Attention ( Q , K , V ) = softmax ( Q K T d k ) V \text{Attention}(Q, K, V) = \text{softmax}\left(\frac{QK^T}{\sqrt{d_k}}\right) V Attention(Q,K,V)=softmax(dkQKT)V

其中, W Q , W K , W V W^Q, W^K, W^V WQ,WK,WV 是可学习的权重矩阵, d k d_k dk 是 K K K 的维度。

2. PyTorch代码实现

class SelfAttention(nn.Module):def __init__(self, embed_size, heads):super(SelfAttention, self).__init__()self.embed_size = embed_sizeself.heads = headsself.head_dim = embed_size // headsself.query_linear = nn.Linear(self.head_dim, self.head_dim)self.key_linear = nn.Linear(self.head_dim, self.head_dim)self.value_linear = nn.Linear(self.head_dim, self.head_dim)def forward(self, x):batch_size = x.shape[0]x = x.reshape(batch_size, -1, self.heads, self.head_dim)query = self.query_linear(x)key = self.key_linear(x)value = self.value_linear(x)attention = torch.matmul(query, key.transpose(-2, -1)) / (self.head_dim ** 0.5)attention = torch.softmax(attention, dim=-1)out = torch.matmul(attention, value)out = out.reshape(batch_size, -1, self.embed_size)return out

x = torch.randn(10, 32, 512) # 假设输入序列长度为10,特征维度为512,head数为32

self_attention = SelfAttention(embed_size=512, heads=32)

output = self_attention(x)

print(output)

四、多头注意力与计算

1. 多头注意力的原理

多头注意力(Multi-Head Attention)机制是将自注意力机制分解为多个头,每个头关注不同的信息,最后将多个头的输出拼接起来。

MultiHead ( Q , K , V ) = Concat ( head 1 , … , head h ) W O \text{MultiHead}(Q, K, V) = \text{Concat}(\text{head}_1, \ldots, \text{head}_h)W^O MultiHead(Q,K,V)=Concat(head1,…,headh)WO

其中, head i = Attention ( Q W i Q , K W i K , V W i V ) \text{head}_i = \text{Attention}(QW_i^Q, KW_i^K, VW_i^V) headi=Attention(QWiQ,KWiK,VWiV), W i Q , W i K , W i V W_i^Q, W_i^K, W_i^V WiQ,WiK,WiV 是第 i i i 个头的权重矩阵。

- PyTorch代码实现方式

class MultiHeadAttention(nn.Module):def __init__(self, embed_size, heads):super(MultiHeadAttention, self).__init__()self.self_attention = SelfAttention(embed_size, heads)self.linear = nn.Linear(embed_size, embed_size)def forward(self, query, key, value):attention = self.self_attention(query, key, value)out = self.linear(attention)return out

x = torch.randn(10, 32, 512) # 假设输入序列长度为10,特征维度为512,head数为32

multi_head_attention = MultiHeadAttention(embed_size=512, heads=32)

output = multi_head_attention(x, x, x)

print(output)

五、通道注意力

1. 通道注意力的原理

通道注意力(Channel Attention)机制是在特征图的通道维度上进行注意力加权,强调重要的特征通道。

通道注意力的一般计算方式为:

ChannelAttention ( F ) = σ ( MLP ( AvgPool ( F ) ) + MLP ( MaxPool ( F ) ) ) \text{ChannelAttention}(F) = \sigma(\text{MLP}(\text{AvgPool}(F)) + \text{MLP}(\text{MaxPool}(F))) ChannelAttention(F)=σ(MLP(AvgPool(F))+MLP(MaxPool(F)))

其中, F F F 是输入特征图, AvgPool \text{AvgPool} AvgPool 和 MaxPool \text{MaxPool} MaxPool 分别表示平均池化和最大池化, MLP \text{MLP} MLP 表示多层感知机, σ \sigma σ 表示sigmoid激活函数。

2. PyTorch代码实现

class ChannelAttention(nn.Module):def __init__(self, in_channels, ratio=16):super(ChannelAttention, self).__init__()self.avg_pool = nn.AdaptiveAvgPool2d(1)self.max_pool = nn.AdaptiveMaxPool2d(1)self.fc = nn.Sequential(nn.Linear(in_channels, in_channels // ratio, bias=False),nn.ReLU(inplace=True),nn.Linear(in_channels // ratio, in_channels, bias=False))self.sigmoid = nn.Sigmoid()def forward(self, x):avg_out = self.fc(self.avg_pool(x).view(x.size(0), -1))max_out = self.fc(self.max_pool(x).view(x.size(0), -1))out = self.sigmoid(avg_out + max_out)return out * x

x = torch.randn(32, 512, 7, 7) # 假设输入特征图的形状为(32, 512, 7, 7)

channel_attention = ChannelAttention(in_channels=512)

output = channel_attention(x)

print(output)

六、空间注意力

1. 空间注意力的原理

空间注意力(Spatial Attention)机制是在特征图的空间维度上进行注意力加权,强调重要的空间位置。

空间注意力的计算方式为:

SpatialAttention ( F ) = σ ( conv ( Concat ( AvgPool ( F ) , MaxPool ( F ) ) ) ) \text{SpatialAttention}(F) = \sigma(\text{conv}(\text{Concat}(\text{AvgPool}(F), \text{MaxPool}(F)))) SpatialAttention(F)=σ(conv(Concat(AvgPool(F),MaxPool(F))))

其中, F F F 是输入特征图, conv \text{conv} conv 表示卷积操作。

2. PyTorch代码实现

class SpatialAttention(nn.Module):def __init__(self, kernel_size=7):super(SpatialAttention, self).__init__()assert kernel_size % 2 == 1, "Kernel size must be odd"self.conv1 = nn.Conv2d(2, 1, kernel_size, padding=kernel_size // 2, bias=False)self.sigmoid = nn.Sigmoid()def forward(self, x):avg_out = torch.mean(x, dim=1, keepdim=True)max_out, _ = torch.max(x, dim=1, keepdim=True)x = torch.cat([avg_out, max_out], dim=1)x = self.conv1(x)return self.sigmoid(x) * x

x = torch.randn(32, 512, 7, 7) # 假设输入特征图的形状为(32, 512, 7, 7)

spatial_attention = SpatialAttention(kernel_size=7)

output = spatial_attention(x)

print(output)

七、混合注意力

1. 混合注意力的原理

混合注意力(Hybrid Attention)机制是将通道注意力与空间注意力结合使用,从而同时捕捉特征通道和空间位置的重要性。

混合注意力的计算方式为:

HybridAttention ( F ) = SpatialAttention ( ChannelAttention ( F ) ) \text{HybridAttention}(F) = \text{SpatialAttention}(\text{ChannelAttention}(F)) HybridAttention(F)=SpatialAttention(ChannelAttention(F))

2. PyTorch代码实现

class HybridAttention(nn.Module):def __init__(self, in_channels, ratio=16, kernel_size=7):super(HybridAttention, self).__init__()self.channel_attention = ChannelAttention(in_channels, ratio)self.spatial_attention = SpatialAttention(kernel_size)def forward(self, x):x = self.channel_attention(x)x = self.spatial_attention(x)return x

x = torch.randn(32, 512, 7, 7) # 假设输入特征图的形状为(32, 512, 7, 7)

hybrid_attention = HybridAttention(in_channels=512)

output = hybrid_attention(x)

print(output)

八、总结

本文详细介绍了注意力机制的不同类型,包括普通注意力、自注意力、多头注意力、通道注意力、空间注意力和混合注意力,并提供了每种注意力的数学原理和基于PyTorch的代码实现。通过这些示例,我们可以看到注意力机制在深度学习模型中的重要作用,它能够有效地提高模型对关键信息的捕捉能力。

![[Vulnhub] Acid-Reloaded SQLI+图片数据隐写提取+Pkexec权限提升+Overlayfs权限提升](https://img-blog.csdnimg.cn/img_convert/d9709e4c2c8ce39e883012e2f64a51e5.jpeg)