NLP - LLM - Langchain-Chatchat修改加载显卡

- 一、Langchain-Chatchat存在问题

- 二、 Langchain-Chatchat加载显卡配置

- 1. 模型加载的位置

- 2. 函数中提供模型加载GPU的配置,但是不生效

- 三、 修改Langchain-Chatchat加载显卡配置

- 1. 第一步修改(create_model_worker_app函数中 args.device参数)

- 2. 第二步修改(ModelWorker函数加载位置)

- 3. 第三步修改(model_adapter1.py文件函数 load_model)

一、Langchain-Chatchat存在问题

Langchain-Chatchat 存在修改加载显卡无效,一直占用GPU0显卡的问题。

二、 Langchain-Chatchat加载显卡配置

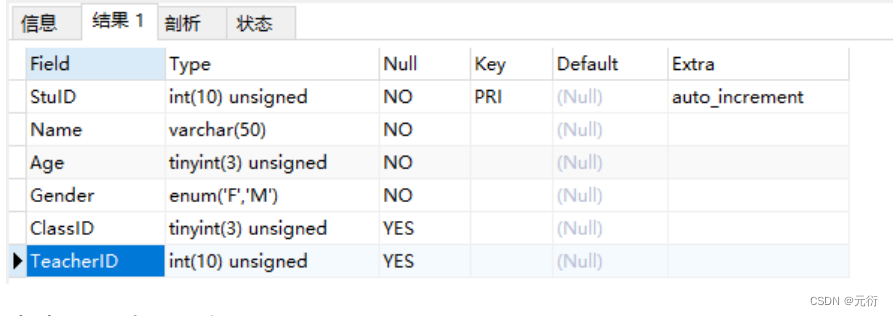

1. 模型加载的位置

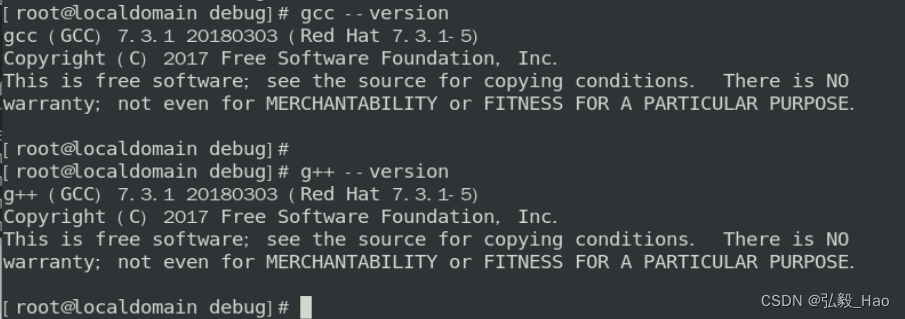

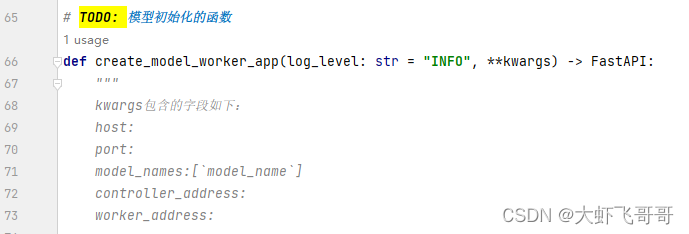

根目录下 startup.py 文件,create_model_worker_app函数中

2. 函数中提供模型加载GPU的配置,但是不生效

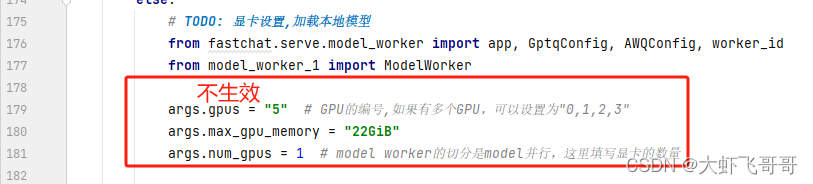

根本问题是底层包的中不支持该修改,只支持多卡平均加载模型

三、 修改Langchain-Chatchat加载显卡配置

1. 第一步修改(create_model_worker_app函数中 args.device参数)

设置为模型加载的显卡位置,这里设置为加载到第六块显卡(显卡编号从0开始)

2. 第二步修改(ModelWorker函数加载位置)

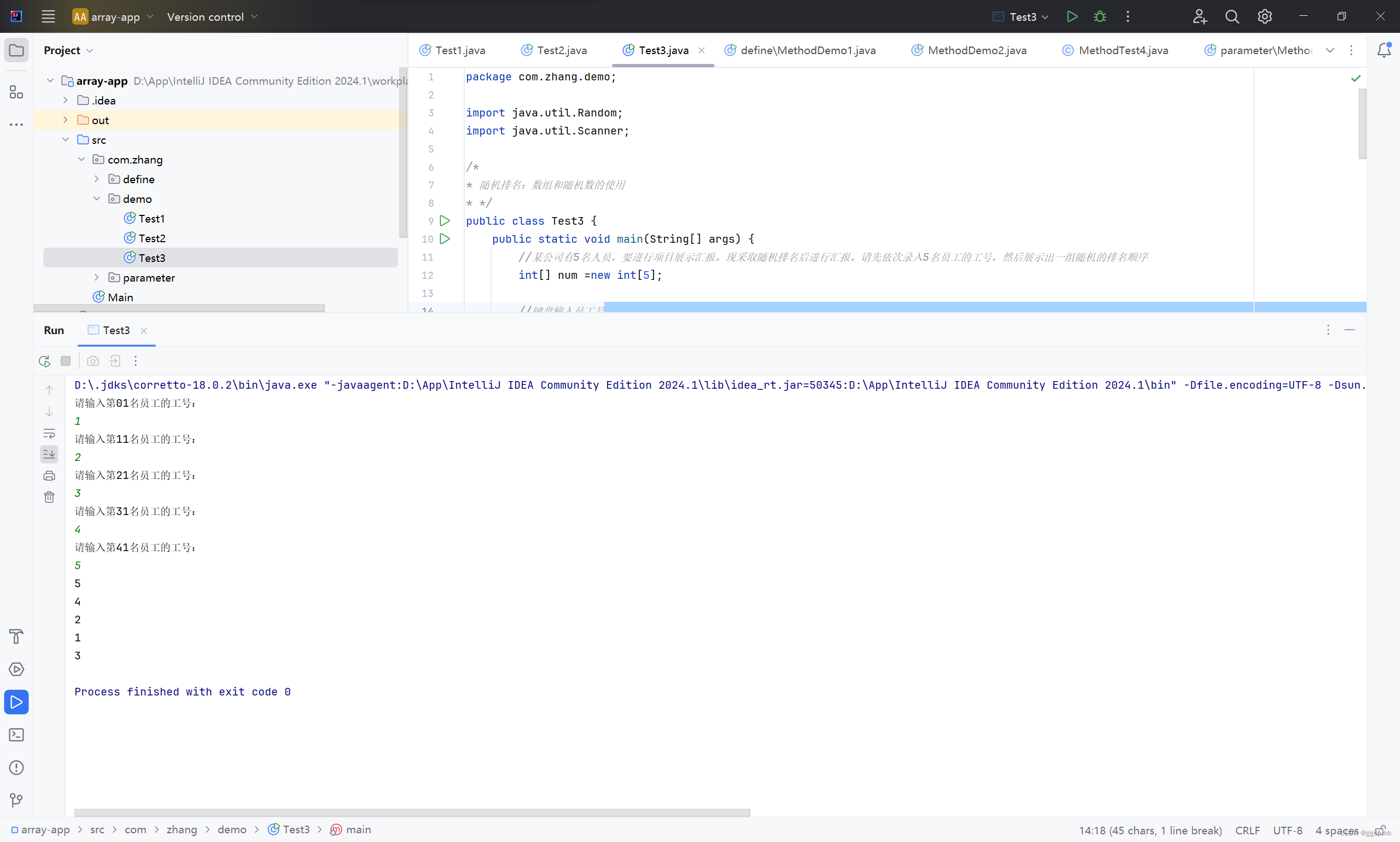

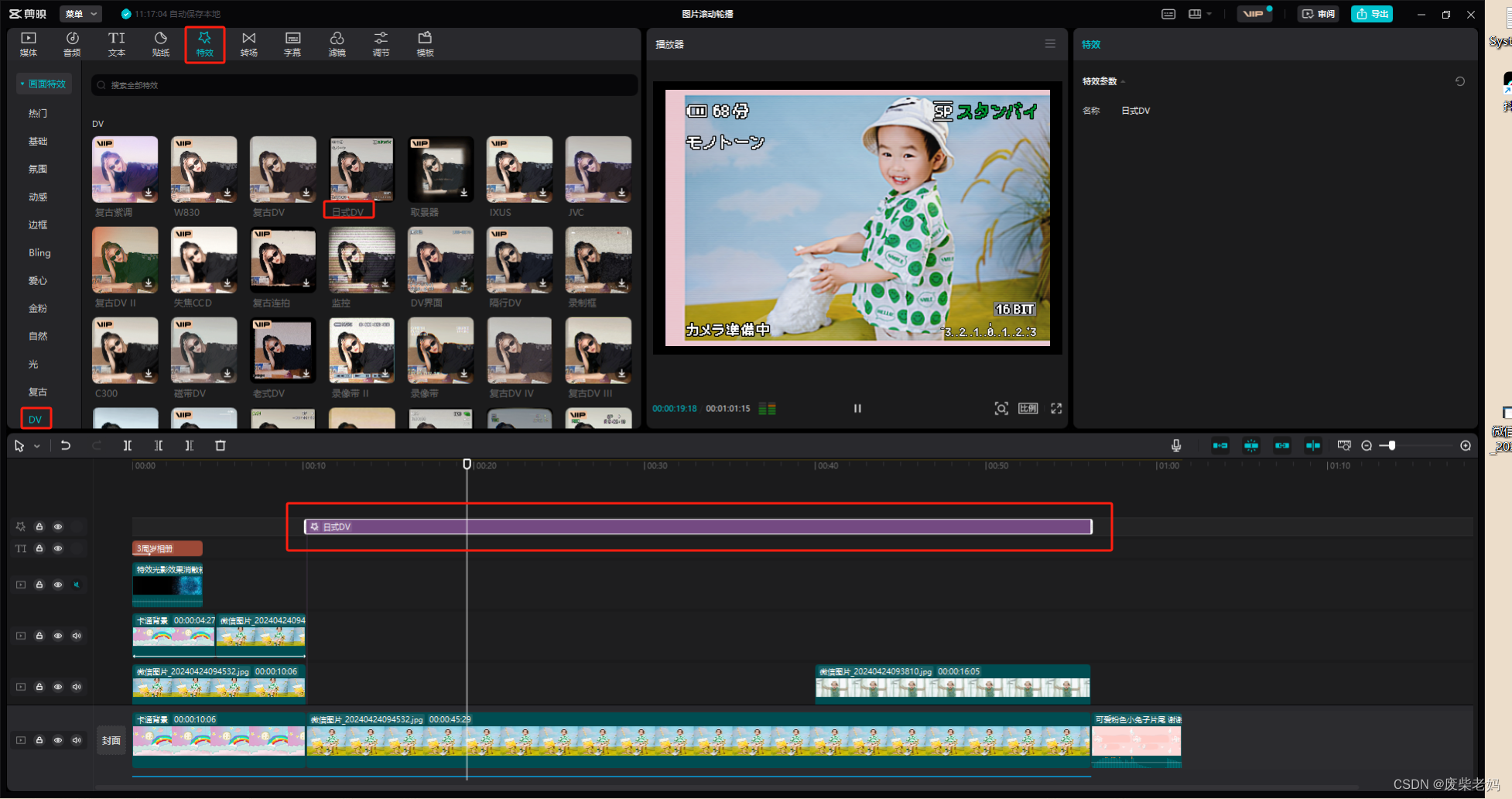

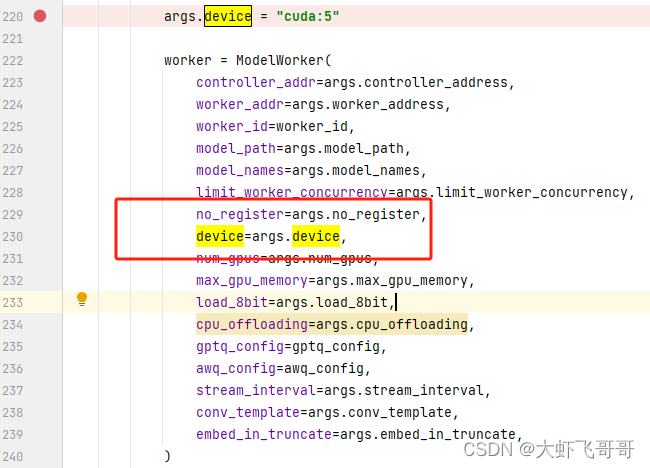

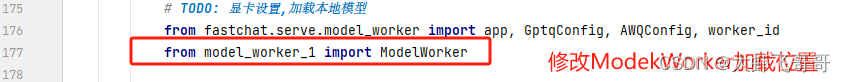

显卡加载不成功的问题存在ModelWorker函数中,这里我们复制fastchat.serve.model_worker.py文件内容另存为 model_worker_1.py放到工程的根目录下 ,修改加载显卡位置。

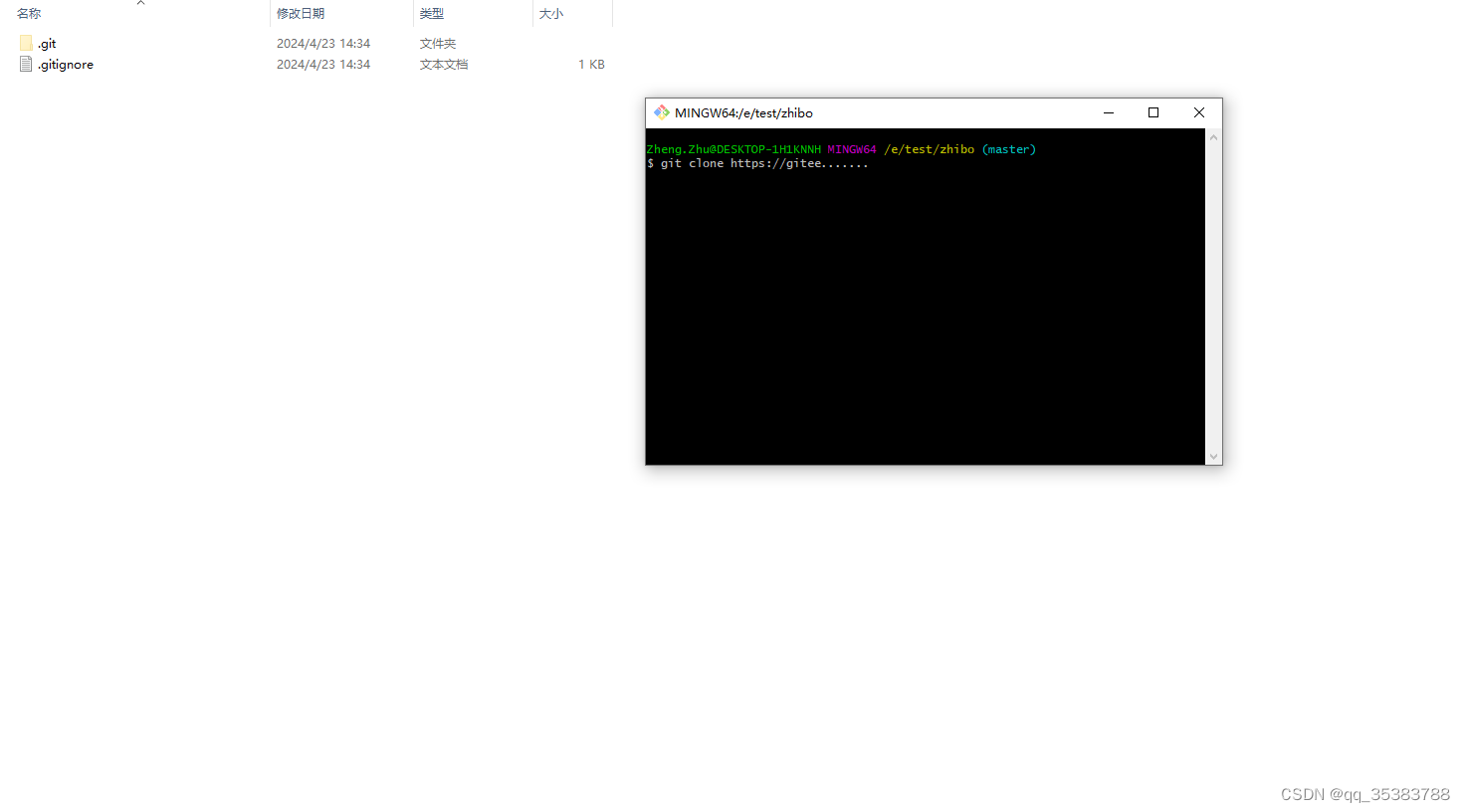

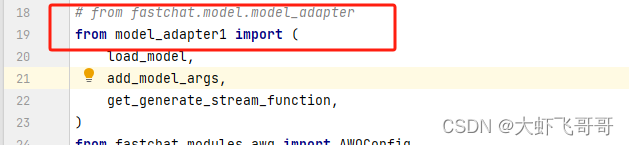

model_worker_1.py只需要修改 model_adapter 加载的位置;同样复制from fastchat.model.model_adapter.py文件的内容,重命名为model_adapter1.py文件放到根目录下

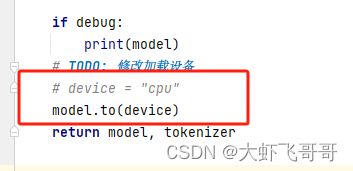

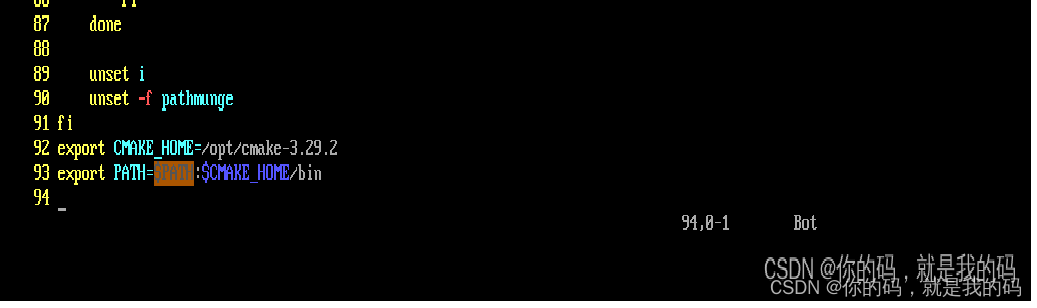

3. 第三步修改(model_adapter1.py文件函数 load_model)

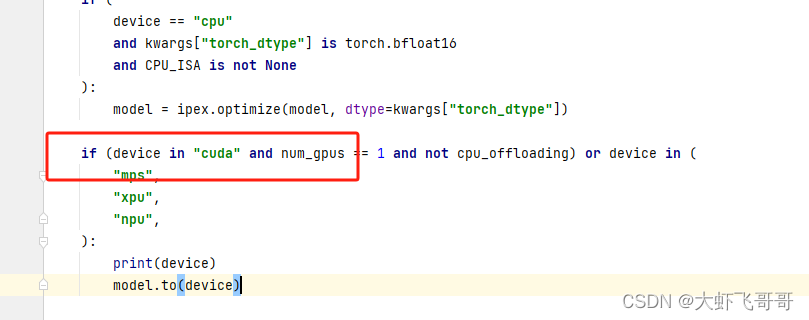

第一个位置:将 “==” 改为 “in”

第一个位置:同样将 “==” 改为 “in”

最后:增加模型加载的GPU,修改完成