符尧 | 网站 | 博客 | 推特 / X

爱丁堡大学 | yao.fu@ed.ac.uk

发布日期:2024年4月22日

原贴:https://yaofu.notion.site/Apr-2024-Llama-3-Opens-the-Second-Chapter-of-the-Game-of-Scale-efff1c0c185f4008af673b78faf83b61

翻译和评论由“强化学徒”提供,已经过符博授权,感谢~

主要观点

- 文本数据的扩展可能已经达到了极限,因为大部分易获取的网络文本(如Common Crawl、Github、Arxiv等)已经被使用完毕。

- 肯定会有新的文本数据,比如更深入地从互联网挖掘、扫描图书馆书籍和合成数据。然而,要增加一个数量级是相当具有挑战性的——更可能的是,它们只是在当前数量级内的增量。

我认为这部分会提供更规范和量级更大的数据。关于扫描书籍,据我所知,在4月份之前,公开发布的工具中,除了mathpix,都无法有效识别PDF,尤其是表格和公式。最近我一个朋友已经免费发布了doc2x(狠狠安利),另外一个simpletex也快上线了,大家可以期待一下。另外,关于多模态和数据合成,我认为可以做出量级更大的数据,尤其是增加指令微调功能。

- 游戏的下一章从多模态开始,特别是统一的视频-语言生成模型,因为只有视频数据才能实现数量级的增长。

- 然而,坏消息是,似乎视频数据无法增加模型的推理能力——请记住,推理是标志强大模型的头号关键能力。

还是得靠正儿八经的扫描版书籍的能力~

- 但好消息是,视频数据增加了其他一切,特别是与现实世界的联系,并展示了成为神经世界模型(而不是像Zelda那样硬编码的物理引擎)的强大潜力,这导致了从模拟物理反馈中学习的可能性。

- 从 X \mathrm{X} X反馈中扩展强化学习 似乎是继续增加模型推理能力最有前途的方向,其中X代表人类、人工智能和环境的反馈。

- 就像AlphaGo Zero在围棋上取得超越人类的表现一样,自我对弈和与环境互动可能是实现超越人类生成模型的方向。使模型在线并从反馈中迭代学习(而不是单次离线优化)可能会潜在地导致持续增加的推理能力。

这部分用于游戏、代码应该是比较合适的,但对于机器人可能难度就大很多了。

- 规模化文本数据是游戏的第一章,达到了GPT-4的高峰,并由Llama 3总结。这个游戏的第二章将是统一的视频-语言生成建模和从 X \mathrm{X} X反馈中迭代强化学习。

如果说PDF也是一种多模态数据,也许也OK?

1. 目录

1 - Llama 3有多好?

2 - 文本扩展数据的极限

3 - 扩展总是赢的,但接下来要扩展什么?

4 - 扩展统一的视频-语言生成模型

5 - 通过从X反馈中迭代强化学习实现AlphaZero风格的智能体

6 - 结论:规模化游戏的第二章

免责声明:本文本质上是阅读Llama 3发布说明后对未来工作的快速个人研究笔记。所提出的观点可能与现有信念不同。我欢迎任何批评和相悖的观点。您可以直接在本文档上发表评论,通过 X \mathrm{X} X向我发送消息,或发送电子邮件进行详细讨论。

2. 1 - Llama 3有多好?

相当不错。

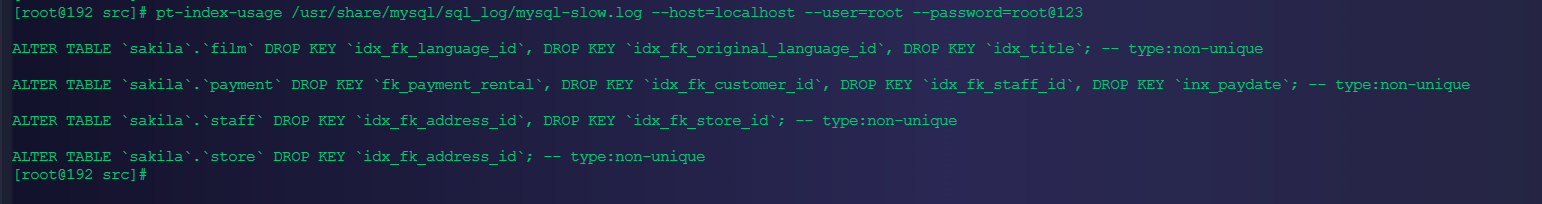

对于基础模型,我们检查 MMLU、MATH、GPQA 和 BBH 作为关键指标,因为它们衡量了高级知识和推理能力,排行榜如下。

| #参数 | MMLU | MATH | GPQA | BBH | |

|---|---|---|---|---|---|

| Claude 3 Opus | ? ? ? | 86.8 | 61.0 | 50.4 | 86.8 |

| GPT-4 Turbo 0409 | ? ? ? | 86.5 | 72.2 | 49.1 | ? ? ? |

| GPT-4 初始发布 | ? ? ? | 86.4 | 52.9 | 35.7 | 83.1 |

| Llama 3 400B(仍在训练中) | 400 B | 84.8 | ? ? ? | ? ? ? | 85.3 |

| Gemini 1.0 Ultra | ? ? ? | 83.7 | 53.2 | 35.7 | 83.6 |

| Reka Core v0.5 | ? ? ? | 83.2 | ? ? ? | 38.2 | ? ? ? |

| Llama 3 70B | 70 B 70 \mathrm{~B} 70 B | 82.0 | 50.4 | 39.5 | ? ? ? |

| Claude 3 Sonnet | ? ? ? | 79.0 | 40.5 | 40.4 | 82.9 |

| Mistral 8x22B | 8 ∗ 22 B 8^{*} 22 \mathrm{~B} 8∗22 B | 77.7 | ? ? ? | ? ? ? | ? ? ? |

| QWen 1.5 72B Chat | 72 B 72 \mathrm{~B} 72 B | 77.1 | 45.2 | 29.3 | 75.7 |

| Reka Flash v1.5 | 21 B 21 \mathrm{~B} 21 B | 75.9 | ? ? ? | 34.0 | ? ? ? |

| Cohere Command R+ | 104 B 104 \mathrm{~B} 104 B | 75.7 | ? ? ? | ? ? ? | ? ? ? |

| Gemini 1.0 Pro | ? ? ? | 71.8 | 32.6 | 27.9 | 75.0 |

| DeepSeek | 67 B 67 \mathrm{~B} 67 B | 71.3 | 18.7 | ? ? ? | 68.7 |

| Mistral 8x7B | 8 ∗ 7 B 8^{*} 7 \mathrm{~B} 8∗7 B | 70.6 | ? ? ? | ? ? ? | ? ? ? |

Yao Fu 15 h 15 \mathrm{~h} 15 h

这些数字来自指向原始 GPTMar 2023 的 Claude-3 技术。请注意,GPT-4 Turbo Nov 2023 比原始版本要好得多。

Llama 3 70B Chat 的 BBH 为 80.5,来源于 https://mp.weixin.qq.com/s/8xJVWibyisrblmxQCC-91w

- 它使用了 15 T 15 \mathrm{~T} 15 T 的训练Token,比其同行要大得多。

- 特别是,混合代码/ arxiv 数据可以提高推理能力。

- 它使用了与基准相关的继续预训练数据(例如 Llemma/ MetaMath/ Mammoth)来改进/ 装饰基准。

- 然而,当分数达到 80+ 时,要装饰 MMLU 就会变得相当困难,尽管不是不可能的,因为数据集本身就很难。

聊天版本在聊天机器人领域看起来也不错

但请注意,在 LLaMA 3 初始发布后,出现了明显的分数提升模式 - 根据文本模式很容易判断出是由 LLaMA 3 提供的答案 - 最初排名约为第 3,但现在 ELO 逐渐下降。然而,你可以看到置信区间(+9/-11)比其他模型(+5/-5)要大得多,因此它的排名可能会继续下降。

哈哈,这个当时群里也聊过,大家很容易看出中英混杂,和夹杂emoji的内容是llama3的数据。

- Llama 3 初始排行榜上升,得票少且方差大

老实说,进行性能装饰和分数提升是完全不必要的 - 它已经是一个相当不错的模型了 - 这样做可能会增加它在普通大众中的声誉(或者可能不会),但肯定会损害在专业人士中的声誉。再次强调,它已经是最好的公开可访问模型。

不知道qwen110B和command-r-plus最终的对比。

我打赌,最终它可能会收敛到大约GPT-4 0314的ELO 1180 - 大约Claude 3 Kaiku的性能(again,相当不错)。

4. 2 - 文本扩展数据的极限

很可能已经到顶了。正如我们观察到,GPT-4 Turbo / Gemini Ultra / Claude 3 Opus / Llama 3 400B都在大致相同的范围内(MMLU约为85)。要继续扩展文本,我们需要更多的数据,问题在于是否可能大幅增加文本数据量超过Llama 3的 15 T 15 \mathrm{~T} 15 TToken。

真的到顶的话,让我们这群做不起大模型的人,还能缓口气。

有以下几个方向,按新数据潜在规模排名:

- C C \mathrm{CC} CC仅是整个互联网的一部分。

- 我们还没有完成从CC中挖掘和爬取的工作。

- 放宽过滤和去重门槛。

Yao Fu 13 h

如果您在您的基准数据上进行训练,肯定会提高i分布性能,但问题在于您的模型是否能够生成超出分布范围的案例。

- 使用现有模型生成合成数据。

- 从图书馆扫描更多书籍

我们逐一讨论它们。

5. CC仅是互联网的一部分

- 这个因素是关于文本扩展的最大未确定因素。我们不知道实际互联网有多大。

- 对于像微软/谷歌和Meta这样的公司,他们可以轻松地倾倒(dump)比 C C \mathrm{CC} CC更大一部分的互联网,他们仍然可以挖掘更多数据。

- 但问题是,在去重和质量过滤之后,还能剩下多少Token。

6. 我们仍在从 C C \mathrm{CC} CC中挖掘

- 这种方法的问题在于,我们可以生成的现有CC的最终Token数量受数据处理管道的上限约束,并且在数量级上可能不会改变。

- 新的CC倾倒随时间线性增加,数量级仍然没有改变。

- 然而,扩展定律表明指数增长的数据导致性能线性增加。因此,最终我们可能会在 15 T 15 \mathrm{~T} 15 T Llama 3数据之上再产生大约 5 T 5 \mathrm{~T} 5 T新Token,但我们真正想要的是另外50T Token。

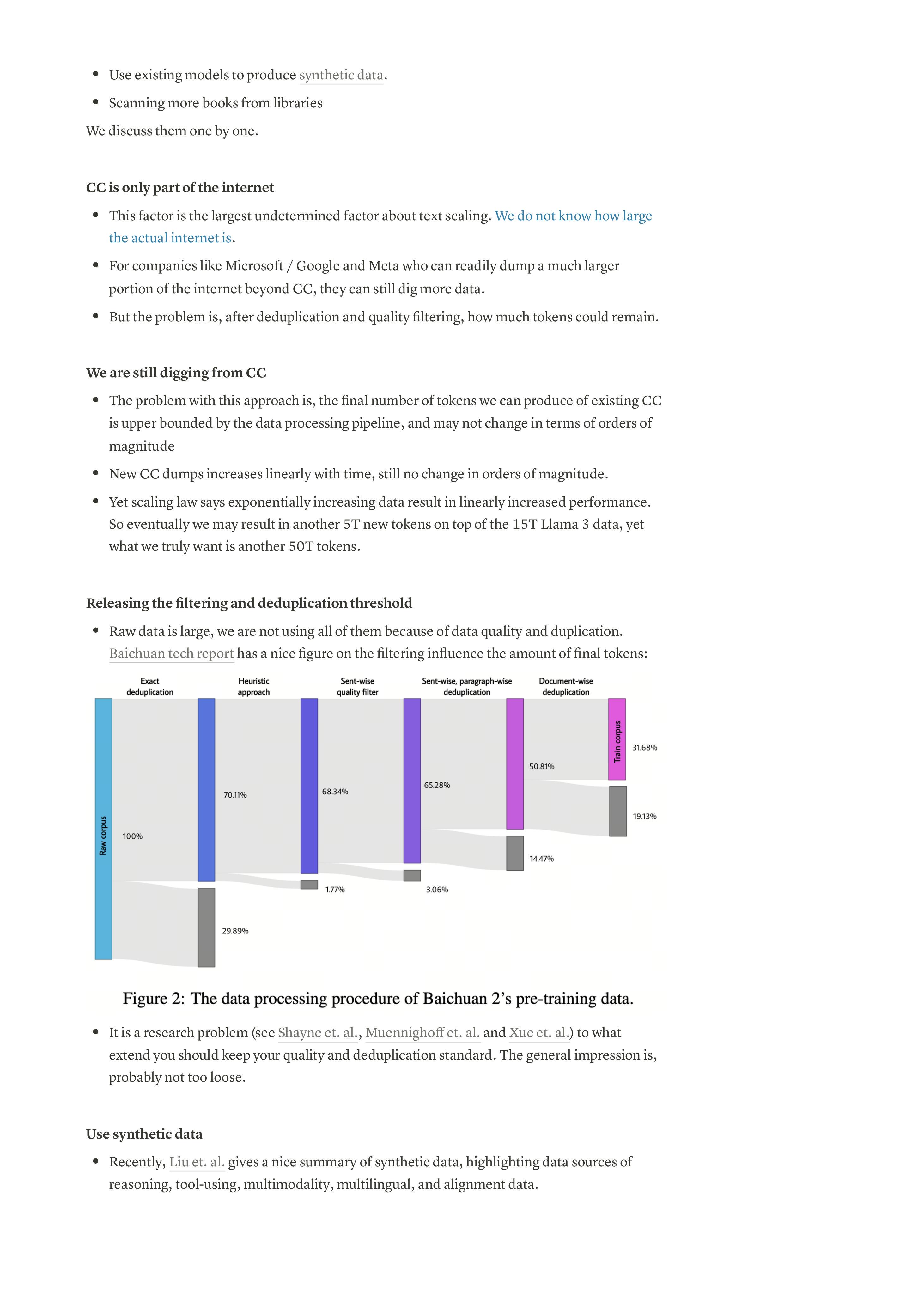

7. 放宽过滤和去重门槛

- 原始数据很大,我们没有使用所有数据是因为数据质量和重复。百川的技术报告中有一个很好的图表,说明过滤对最终Token数量的影响:

图2:百川2 预训练数据的数据处理流程。

- 保持质量和去重标准的程度是一个研究问题(参见Shayne等人,Muennighoff等人和Xue等人)。一般印象是,可能不要太松散(loose)。

8. 使用合成数据

- 最近,Liu等人对合成数据进行了很好的总结,强调了推理、工具使用、多模态、多语言和对齐数据的数据来源。

- 主要挑战仍然存在:似乎大多数现有的数据工作无法改变数量级,因此它们主要用于继续预训练和微调,而不是直接用于预训练。

没有自己玩过全流程,没法有体会,难受。

- 唯一的例外是Phi模型系列,因为它们使用GPT-4生成的数据来训练一个更小的模型。这里的问题是他们的方法是否能扩展到更大的模型并突破GPT-4的上限。

9. 扫描更多图书馆的书籍

- 显然,这些是有前途的方向,因为图书馆的书籍绝对是非常高质量的 - 比网络高得多 - 并且可以明显提高专业知识基准,如MMLU。下面列出了世界上最大的图书馆列表

| 名称 | 国家 ∀ ^ \hat{\forall} ∀^ | 位置 | 编目大小 (项目数量) | 每年访客数{fdd853376-9077-41f8-8904-fc4c243c66cb} | 预算 | 员工 ∼ ^ \hat{\sim} ∼^ |

|---|---|---|---|---|---|---|

| 大英图书馆 | 英国 | 伦敦和波士顿斯帕 [ 1 ] { }^{[1]} [1] | 170 − 200 170-200 170−200 百万 [ 2 ] [ 3 ] [ 4 ] ^{[2][3][4]} [2][3][4] | 175万 [ 5 ] ^{[5]} [5] | £ 141百万 [ 6 ] ^{[6]} [6] | 1,977人 [ 6 ] ^{[6]} [6] |

| 国会图书馆 | 美国 | 华盛顿特区 | 1.75亿 [ 7 ] { }^{[7]} [7] | 1.9百万 [ 8 ] ^{[8]} [8] | 美国 $$ 838.992$百万 [ 8 ] ^{[8]} [8] | 3,149人 [ 8 ] ^{[8]} [8] |

| 上海图书馆 | 中国 | 上海 | 5700万 [ 9 ] ^{[9]} [9] | |||

| 纽约公共图书馆 | 美国 | 纽约市 | 5500万 [ 10 ] ^{[10]} [10] | 1800万 [ 10 ] ^{[10]} [10] | 美国 $$ 250$百万 [ 10 ] ^{[10]} [10] | 3,000人 [ 10 ] ^{[10]} [10] |

| 加拿大图书馆和档案馆 | 加拿大 | 渥太华 | 5400万 [ 11 ] ^{[11]} [11] | C $ 116.9百万 [ 12 ] ^{[12]} [12] | 874人 [ 12 ] ^{[12]} [12] | |

| 俄罗斯国家图书馆 | 俄罗斯 | 莫斯科 | 4810万 [ 13 ] ^{[13]} [13] | 49.8万 [ 13 ] ^{[13]} [13] | 27亿卢布 [ 13 ] { }^{[13]} [13] | 1,613人 [ 13 ] ^{[13]} [13] |

| 国会图书馆 | 日本 | 东京和京都 | 4410万 [ 14 ] ^{[14]} [14] | 79.1万 [ 14 ] ^{[14]} [14] | 218亿日元 [ 14 ] ^{[14]} [14] | 908人 [ 14 ] ^{[14]} [14] |

| 德国国家图书馆 | 德国 | 莱比锡和法兰克福 | 4370万 [ 15 ] ^{[15]} [15] | 35.1万 [ 15 ] ^{[15]} [15] | 57.6百万欧元 [ 15 ] ^{[15]} [15] | 639人 [ 15 ] ^{[15]} [15] |

| 丹麦皇家图书馆 | 丹麦 | 哥本哈根和奥胡斯 | 4250万(实体物品,不包括数字物品) [ 16 ] ^{[16]} [16] | 145万 [ 16 ] ^{[16]} [16] | 52.38亿丹麦克朗 [ 16 ] ^{[16]} [16] | 800 + + [ 17 ] 800++^{[17]} 800++[17] |

| 中国国家图书馆 | 中国 | 北京 | 4327万 [ 18 ] ^{[18]} [18] | 520万 [ 19 ] ^{[19]} [19] | 136 5 [ 19 ] 1365^{[19]} 1365[19] | |

| 加利福尼亚大学图书馆 | 美国 | 伯克利,戴维斯,欧文,洛杉矶,默塞德,里弗赛德,圣迭戈,旧金山,圣巴巴拉和圣克鲁斯 | 4080万 [ 20 ] ^{[20]} [20] | 美国 $2.95亿 [ 20 ] ^{[20]} [20] | 2000 + [ 20 ] 2000+[20] 2000+[20] | |

| 法国国家图书馆 | 法国 | 巴黎 | 4166万 [ 21 ] ^{[21]} [21] | 130万 [ 22 ] ^{[22]} [22] | €2.54亿 [ 23 ] { }^{[23]} [23] | 266 8 [ 24 ] 2668^{[24]} 2668[24] |

| 伊利诺伊大学图书馆 | 美国 | 伊利诺伊州厄巴纳 | 3800万 [ 25 ] ^{[25]} [25] | 美国 $4.87亿 [ 26 ] ^{[26]} [26] | ||

| 俄罗斯国家图书馆 | 俄罗斯 | 圣彼得堡 | 3650万 [ 27 ] ^{[27]} [27] | 100万 [ 27 ] ^{[27]} [27] | 569.2亿卢布 | 1850 |

| 巴伐利亚州立图书馆 | 德国 | 慕尼黑 | 3440万 | 110万 | €5.91亿 | 805 |

| 西班牙国家图书馆 | 西班牙 | 马德里 | 3310万 [ 28 ] ^{[28]} [28] | €2.92亿 [ 29 ] { }^{[29]} [29] | 48 2 [ 29 ] 482^{[29]} 482[29] |

- 问题不在于技术方面 - 从这些图书馆购买版权可能会耗尽所有的人工智能投资 - 而其中很大一部分并非待售。再次强调,如果平均每本书有 70 K 70 \mathrm{~K} 70 K个Token,那么2亿本书只有大约 14 T 14 \mathrm{~T} 14 T个Token。这将使现有数量翻倍,但并不会大幅增加。

哈哈,再扩增5倍不过分吧~

10. 3 - 缩放总是胜出,但接下来要扩展什么?

到目前为止,我们已经讨论了GPT-4级别的前沿模型很可能接近文本扩展的极限,进一步扩展文本数据可能会遇到更大的挑战(但仍然可能)。我们当然希望继续这场盛会,因为扩展是一种规律。放缩总是胜出,问题是接下来要扩展什么。

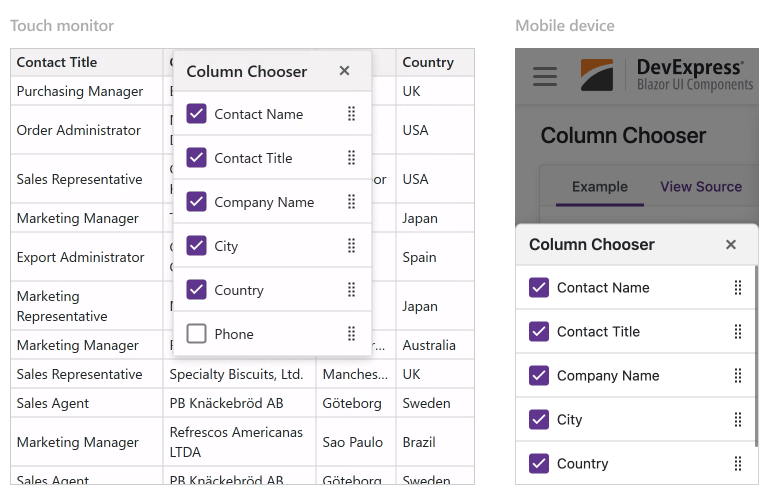

- 一个明确的方向是多模态数据,特别是视频数据。Youtube和Tiktok的规模可能比文本大几个数量级 - 是的,这就是新数量级的来源。但存在一个直接的挑战:多模态数据是否会改善基于文本的推理能力?

- 答案很难,可能是否定的。然后就有了一个随之而来的现实问题:如果OpenAI下个月发布GPT-5,其MMMU得分从56提高到70,但MMLU仍保持在86,这会传递出怎样的信息,公众会如何反应?

- MMMU排行榜截图

- 然而好消息是,即使视频数据不会增加推理能力,它会改善其他方面,特别是grounding,从而使模型能够从现实世界中获得反馈。

要改善推理能力,需要扩大在强化学习中的探索和利用

RLer狂喜。

具体来说,可能需要扩大(scale):

- 模型探索的视野,例如将模型在线部署一年,并每周更新一次,而不是单步优化。

这段没太看懂,原文是:The horizon of model’s exploration, e.g., deployment the model online for a year and update on a weekly basis, instead of single-step optimization

- 搜索空间,例如让模型生成一百万个响应,并选择其中最佳的,而不是最初的InstructGPT的7个最佳选择之一。

我和做RLHF的朋友讨论过这个问题,他的反馈是这样的探索效率还是偏低了,成本hold不住,建议用点自动化的反馈,最简单的应该是cot,或者是self-play。

-

反馈来源,特别是逐渐从人类反馈(因为人类反馈不具备可扩展性,而模型正在变得比他们的人类注释者更强大)转向人工智能和环境反馈(因此需要世界模型)。

-

一个非常不幸的事实是,许多现有的研究工作都在研究小规模单轮优化的细节,例如,在 DPO 上添加一个损失项。然而,关键在于在线迭代大规模探索和利用。

增量创新是最简单的,在线大规模迭代的成本,大家都烧不起啊。

11. 4 - 扩展统一的视频-语言生成模型

所以只是扩展视频-语言对吗?听起来不太难吧?

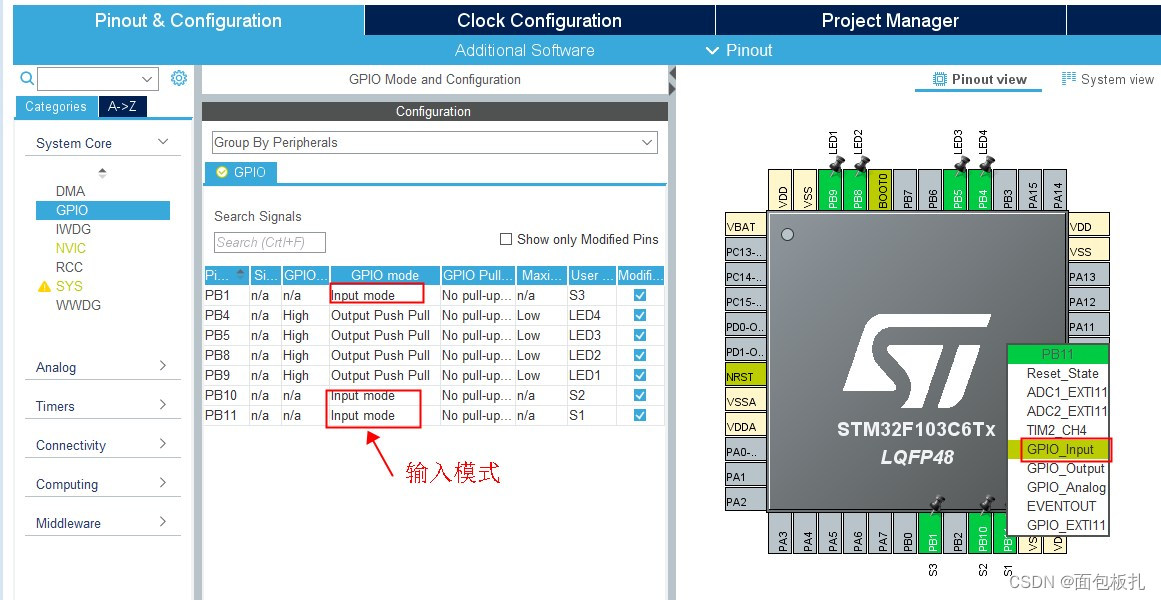

当前情况是,与文本扩展不同,我们有相当标准的架构(MoE transformer)、标准目标(下一个单词预测)、标准流程(预训练然后对齐),视觉/多模态生成模型的设计空间比语言模型要大得多,甚至在一些基本问题上我们还没有达成共识,例如:

- 我们应该先在单独的模态上进行训练,然后使用适配器来桥接模态,就像当前的实践 LLAVA 那样,还是应该直接在所有模态的混合上进行训练?

- 我们应该使用统一的 transformer 骨干,还是一些 CV 的东西,比如 UNet 和 CNN,用于图像/视频部分?我们应该对 transformer 架构进行什么样的修改(例如,3D 位置编码)?如何充分利用专家层的混合?

- 添加新的模态至少不应损害现有的模态,然而普遍观察到,添加视觉可能会对语言产生负面影响。如何调和不同模态之间的矛盾?

- 对于视频理解部分,如何进行Token化/表示学习?应该考虑 VQ-VAE 风格的离散Token还是 Sora 风格的连续时空块?应该使用像 CLIP 这样的对比风格目标还是像原始 VAE 那样的重构风格目标?

- 对于视频生成部分,应该像 VideoPoet 那样自回归,还是像 Sora 那样基于扩散?如何训练一个可以同时执行扩散式生成和自回归生成的 transformer 模型?

最终的解决方案可能非常简单,只需修改现有解决方案的一小部分,但要识别这些小但至关重要的修改,社区需要对这些问题进行“饱和攻击”。

12. 5 - 通过从 X \mathrm{X} X 反馈中进行迭代强化学习来构建 AlphaZero 风格的代理

讨论了预训练可能存在有限的新数据,多模态可能不会改善推理能力之后,为了进一步提高推理能力(毕竟这是语言模型的核心能力),我们将焦点转向扩展强化学习。

问题是,再次,要扩展什么;好消息是,基本上 RL 中的任何维度都可以和应该被扩展。我们首先讨论一个特定的度量标准:pass@K,这意味着在给定 K 次尝试时,模型至少能成功一次。DPO 基本上是在优化通过 2 次(选择一个好的,拒绝一个坏的),而 InstructGPT 的 pass 是在 7 次尝试中成功(从 7 个候选项中选择最佳的一个)。

如果我们扩展 K \mathrm{K} K,而不是考虑通过 7 次,而是考虑通过 100 万次呢? 次尝试中成功(从 7 个候选项中选择最佳的一个)。

原文:What if we scale K and, instead of considering pass at 7, we consider pass at 1million?

并且标注一下:top k:每次采样的时候的参数,用于选择词表中前K个;pass K是多次完整的采样。

从 AlphaCode 论文中,我们看到当扩展 K 时,模型通过率不断提高:

Yuxuan Tong 在 MATH 上验证了 DeepSeek 和 Mistral 在扩展搜索空间 K 时不断提高的情况:

显然,曲线尚未饱和。

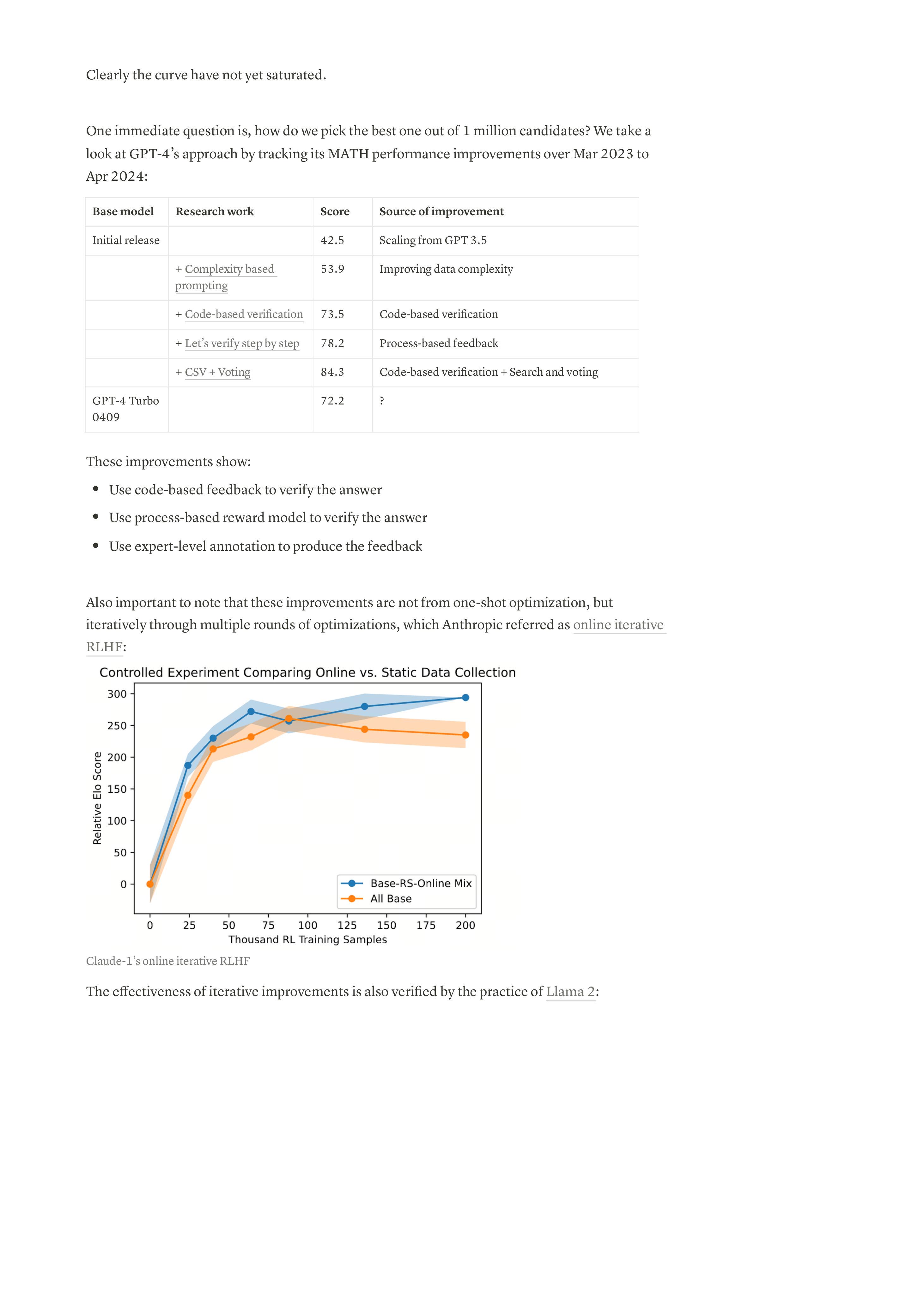

一个直接的问题是,我们如何从 100 万个候选项中选择最佳的一个?我们看一下 GPT-4 在追踪其 MATH 表现改进的过程中采取的方法,从 2023 年 3 月到 2024 年 4 月:

| 基础模型 | 研究工作 | 得分 | 改进来源 |

|---|---|---|---|

| 初始发布 | 42.5 | 从 GPT 3.5 扩展 | |

| + 基于复杂性的提示 | 53.9 | 改进数据复杂性 | |

| + 基于代码的验证 | 73.5 | 基于代码的验证 | |

| + 逐步验证 | 78.2 | 基于过程的反馈 | |

| + CSV + 投票 | 84.3 | 基于代码的验证 + 搜索和投票 |

这些改进显示:

- 使用基于代码的反馈来验证答案

- 使用基于过程的奖励模型来验证答案

- 使用专家级注释来产生反馈

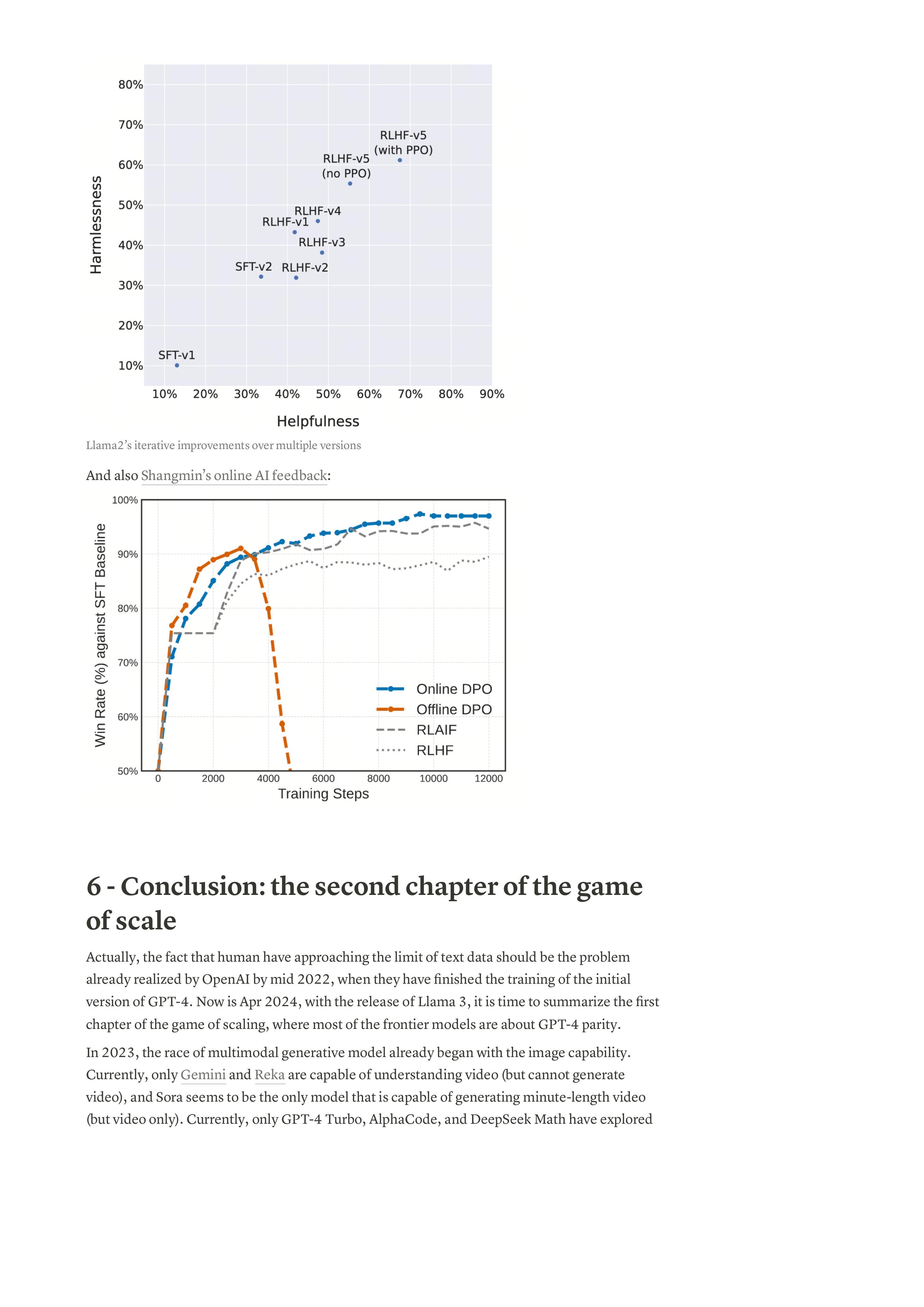

这些改进的重要性也不是一次性优化,而是通过多轮优化迭代逐步实现的,Anthropic将其称为在线迭代RLHF:

Claude-1的在线迭代RLHF

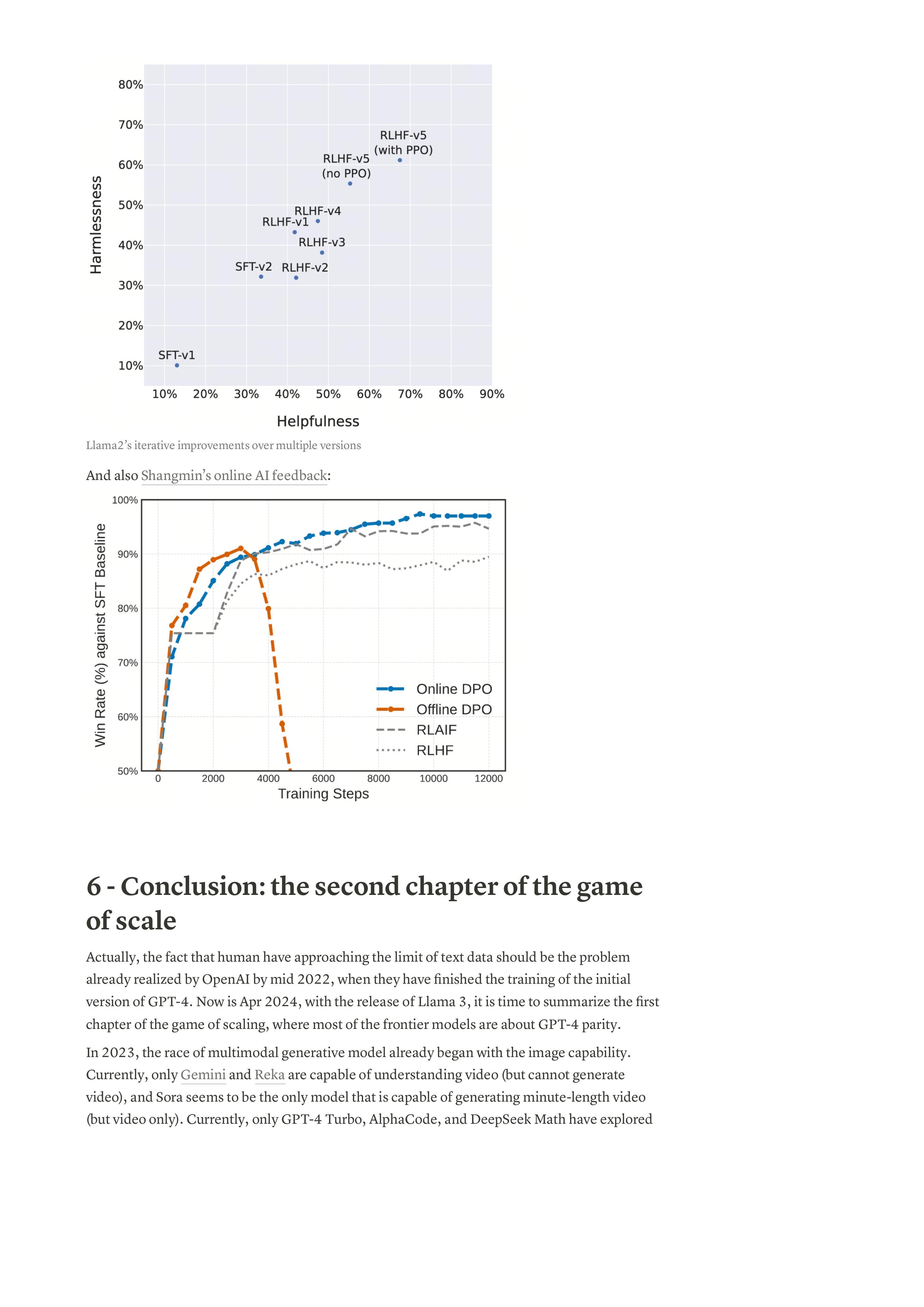

迭代改进的有效性也得到了Llama 2的实践验证:

Llama2在多个版本上的迭代改进

还有Shangmin的在线AI反馈:

13. 6 - 结论:规模游戏的第二章

实际上,人类接近文本数据极限的事实应该已经在2022年中期被OpenAI意识到,当时他们已经完成了GPT-4初始版本的训练。现在是2024年4月,随着Llama 3的发布,是时候总结规模游戏的第一章了,其中大多数前沿模型都与GPT-4的性能相当。在2023年,多模态生成模型的竞赛已经开始,具备图像能力。目前,只有Gemini和Reka能够理解视频(但无法生成视频),Sora似乎是唯一能够生成分钟级视频(但仅限视频)的模型。目前,只有GPT-4 Turbo、AlphaCode和DeepSeek Math进行了探索。