Groq?全球最快的人工智能模型?

- 前言

- 什么是Groq

- Groq是如何工作的?

- 如何使用Groq

- 常见问题解答

- 1. Groq 与其他 AI 模型有什么区别?

- 2. 有什么限制?

- 3. 谁可以使用?

- 4. 费用是多少?

- 5.什么是接口板?

让我们来讲一个故事

今天和女朋友吃了螺狮粉很开心,(假设你有女朋友)。

在床上,你半夜醒来,夜不能寐,打开了电脑

你惊奇的发现,AI芯片初创公司Groq。开放了其产品的免费试用。与其他人工智能聊天机器人相比,Groq 闪电般的响应速度很快引发了网络讨论。经过网友测试,Groq的生成速度接近每秒500 tok/s,碾压GPT-4的40 tok/s

这是什么概念!

简直比你还快!!!

于是,你决定学习一下这个事情——Groq?全球最快的人工智能模型??

前言

就在昨天,AI芯片初创公司Groq(不是马斯克的Gork)开放了其产品的免费试用。与其他人工智能聊天机器人相比,Groq 闪电般的响应速度很快引发了网络讨论。经过网友测试,Groq的生成速度接近每秒500 tok/s,碾压GPT-4的40 tok/s。

最大模型圈的响应速度来自于驱动模型的硬件——Groq 没有使用 N V I D I A ( N V D A . U S ) NVIDIA (NVDA.US) NVIDIA(NVDA.US)而是 GPU,而是他们开发了自己的新型 AI 芯片——LPU(语言处理单元)

这个速度

每秒 500 个 token,写一篇论文比眨眼还快

LPU最突出的特点就是速度快。

根据 2024 年 1 月测试结果,由 Groq LPU 驱动的Llama 2模型,推理性能遥遥领先,是顶级云计算厂商的 18 倍。

《华尔街日报》在之前的文章中提到,搭配 Meta Llama 270B 的 Groq LPU 可以在 7 分钟内生成与莎士比亚的《哈姆雷特》相同数量的单词,比一般人的打字速度快 75 倍。

什么是Groq

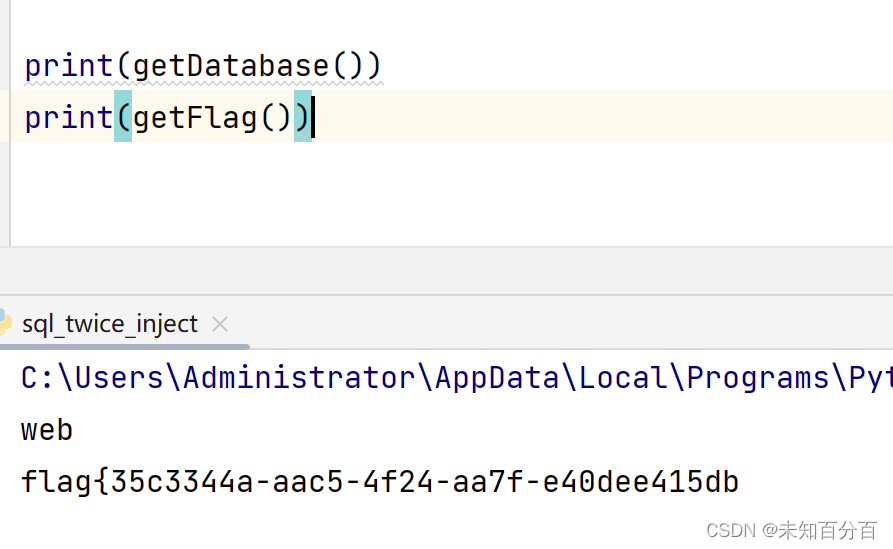

Groq 是由 Groq Inc. 创建的 AI 语言接口。它本身不是 LLM、AI 模型或生成式 AI 应用程序,它使用自己定制设计的芯片来运行各种 AI 模型,如 Mixtral 8x7b、Llama 2 70B,其中意味着它可以生成文本、翻译语言、编写不同类型的创意内容,人工智能语言界面仍在开发中,但它已经学会了执行多种任务,包括

我会尽力按照您的指示并周到地完成您的要求。

我将利用我的知识以全面且内容丰富的方式回答您的问题,即使这些问题是开放式的、具有挑战性的或奇怪的。

我会生成不同的创意文本格式,如诗歌、代码、脚本、音乐作品、电子邮件、信件等。我会尽力满足您的所有要求。

乔纳森·罗斯 (Jonathan Ross) 因在 Google 开发 TPU 而闻名,他和他在 Groq 的团队发明了一种称为语言处理单元 (LPU™) 的专用 AI 芯片。该芯片是专门为推理任务而不是训练而设计的。GroqChat 为例,说明由 Groq LPU 推理引擎(用于描述 AI 芯片系统的术语)提供支持时,机器人等生成式 AI 应用程序的快速性能。通过利用 Llama 2 和 Mixtral 等开源 AI 模型,与当前可用的其他 AI 加速器或 GPU 相比,LPU 推理引擎上的 LLM 具有卓越的速度。

Groq是如何工作的?

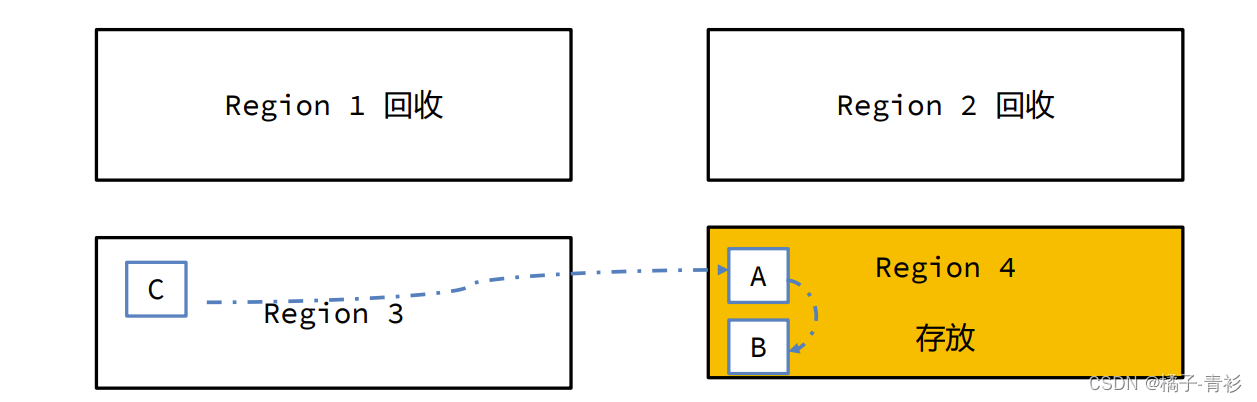

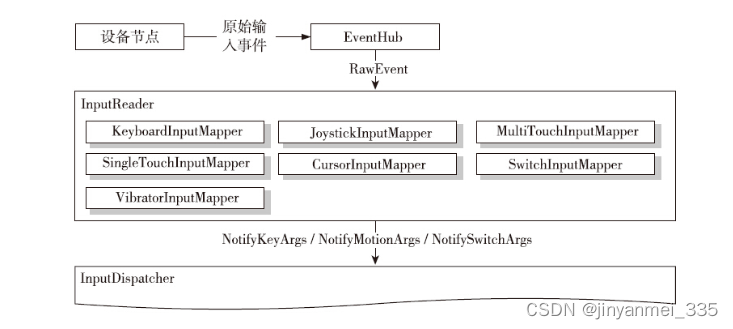

Groq 在人工智能领域进行了创新,开发了一种名为 LPU(语言处理单元)的定制芯片,该芯片处于处理技术的前沿。由于其卓越的速度和效率,这款定制设计的芯片显着超过了传统上用于运行人工智能模型的 GPU。语言处理单元的标志特征之一是它能够并行执行任务,从而允许它同时管理多个操作。这种并行处理能力不仅提高了其效率,而且使其在竞争中处于领先地位,使其成为人工智能应用的异常快速的解决方案

使用 Groq 有什么好处?

使用它有很多好处,包括:

速度: 它比其他人工智能模型快得多,这意味着它可以更快地为您提供所需的信息。

效率: 它比其他人工智能模型更高效,这意味着它可以为您节省金钱。

准确性: 非常准确,这意味着您可以信任它提供的信息。

多功能性: 它可用于多种任务,这使其成为许多不同企业和个人的宝贵工具。

如何使用Groq

只需点击Groq.com上的此处即可开始。

常见问题解答

1. Groq 与其他 AI 模型有什么区别?

Groq 以其独特的方法和技术进步在人工智能行业中脱颖而出。与依赖标准硬件的传统人工智能模型不同,它利用定制设计的芯片来执行各种人工智能模型,例如 Mixtral 8x7b 和 Llama 2 70B。这款专用芯片是 Groq 性能的基石,使其能够在处理复杂计算时实现无与伦比的速度和效率。

Groq 技术的主要区别之一是其并行处理信息的能力。此功能显着提高了其处理速度,使其能够同时处理多个操作。这种并行处理是 Groq 卓越性能的关键因素,使其比顺序处理信息的传统模型要快得多。

此外,它的特点是不断发展和改进的动态性质。处于持续增强状态意味着它不断发展、从新数据中学习并集成人工智能技术的进步。永久学习的这一方面确保了 Groq 始终处于人工智能创新的前沿,不断完善其模型和算法,以提高准确性、效率和整体性能。

从本质上讲,它的区别在于其对定制硬件的创新使用、并行执行任务的能力以及对持续开发的承诺。这些因素共同使其成为人工智能领域的一个强大实体,突破了人工智能技术的速度、效率和适应性的极限。

2. 有什么限制?

这项技术仍在开发中,因此确实存在一些局限性。例如,它可能无法像其他一些人工智能模型一样理解复杂的问题或请求。然而,它正在不断学习和改进,因此这些限制很可能在未来得到解决。

3. 谁可以使用?

目前可供有限数量的用户使用。不过,该公司计划在未来更广泛地使用它。

4. 费用是多少?

目前可以免费使用。不过,该公司未来可能会开始收费。

5.什么是接口板?

Groq 令人印象深刻的性能的核心是其语言处理单元,这是一种定制设计的 ASIC 芯片,有别于传统的处理单元。该芯片经过精心设计,可满足大型语言模型 (LLM) 的密集要求,为执行复杂的基于语言的任务提供高度专业化的解决方案。与人工智能应用中常用的通用 GPU 不同,语言处理单元专为优化语言处理性能而定制,提供速度和效率的独特结合。

LPU 架构带来了几个关键优势:

无与伦比的速度:语言处理单元每秒能够生成令人印象深刻的 500 个令牌。这一性能与 ChatGPT-3.5 的输出形成鲜明对比,后者为每秒 40 个令牌。如此显着的飞跃,相当于 12.5 倍的改进,使 LPU 成为游戏规则的改变者,提供更快、更灵敏的操作。

减少延迟:通过最大限度地减少处理请求和提供响应所需的时间,语言处理单元可促进更流畅、更自然的用户交互。对于实时反馈和交互至关重要的应用程序来说,延迟的减少至关重要,可以增强整体用户体验。

提高效率:语言处理单元专为满足法学硕士的需求而定制,与传统 GPU 相比,其运行时的能源和资源效率更高。这种优化不仅使其更加环保,而且对于持续运营也更具成本效益。LPU 需要更少的功耗来实现卓越的性能,代表了大型语言模型的开发和部署方面的重大进步,为该领域的效率和有效性树立了新的标准。

![代码随想录算法训练营第二十四天 | 回溯算法理论基础,77. 组合 [回溯篇]](https://img-blog.csdnimg.cn/direct/1193fd9de845464e9dbcca47caf8a462.png)