文章目录

- 9.1 爬虫的部署策略

- 9.1.1 重点基础知识讲解

- 9.1.2 重点案例:使用 Docker 部署爬虫到云服务平台

- 9.1.3 拓展案例 1:使用 Kubernetes 管理爬虫的部署和扩展

- 9.1.4 拓展案例 2:利用 GitHub Actions 实现 CI/CD

- 9.2 日志管理与错误处理

- 9.2.1 重点基础知识讲解

- 9.2.2 重点案例:使用 Python logging 模块进行日志管理

- 9.2.3 拓展案例 1:使用 Sentry 进行错误监控和通知

- 9.2.4 拓展案例 2:优雅地处理网络请求错误

- 9.3 爬虫性能监控与优化

- 9.3.1 重点基础知识讲解

- 9.3.2 重点案例:使用 Prometheus 和 Grafana 监控爬虫性能

- 9.3.3 拓展案例 1:调整并发设置以优化性能

- 9.3.4 拓展案例 2:自动调节爬虫速度

9.1 爬虫的部署策略

选择正确的部署策略对于确保爬虫项目的成功至关重要。就像为一次长途航行选择最合适的船只和航线,合理的部署策略可以帮助爬虫在数据的海洋中更加稳定和高效地航行。

9.1.1 重点基础知识讲解

- 云服务平台:利用云服务平台(如 AWS、Google Cloud、Azure)可以提供弹性的计算资源,适应爬虫任务的不同需求,特别适合处理大规模数据抓取任务。

- 容器化部署:通过 Docker 等容器技术,可以确保爬虫在任何环境下都能够以相同的方式运行,简化部署过程并提高可维护性。

- 虚拟私有服务器(VPS):对于中小规模的爬虫项目,使用 VPS 是一种成本效益较高的选择,它提供了更多的控制权和灵活性。

9.1.2 重点案例:使用 Docker 部署爬虫到云服务平台

假设我们有一个使用 Scrapy 框架开发的爬虫项目,我们将通过 Docker 容器化技术,将其部署到 AWS 的 EC2 实例上。

# Dockerfile

FROM python:3.8-slim

RUN pip install Scrapy

COPY . /app

WORKDIR /app

CMD ["scrapy", "crawl", "my_spider"]

使用 AWS CLI 创建一个 EC2 实例,并在实例上安装 Docker。然后,构建 Docker 镜像并运行容器:

docker build -t my_scrapy_project .

docker run my_scrapy_project

9.1.3 拓展案例 1:使用 Kubernetes 管理爬虫的部署和扩展

当爬虫项目需要在多个服务器上运行时,Kubernetes 提供了一种有效管理容器化应用的方法。它支持自动部署、扩展和管理容器应用。

# k8s-deployment.yaml

apiVersion: apps/v1

kind: Deployment

metadata:name: scrapy-deployment

spec:replicas: 3 # 创建3个副本selector:matchLabels:app: scrapytemplate:metadata:labels:app: scrapyspec:containers:- name: scrapyimage: my_scrapy_project:latestports:- containerPort: 6800

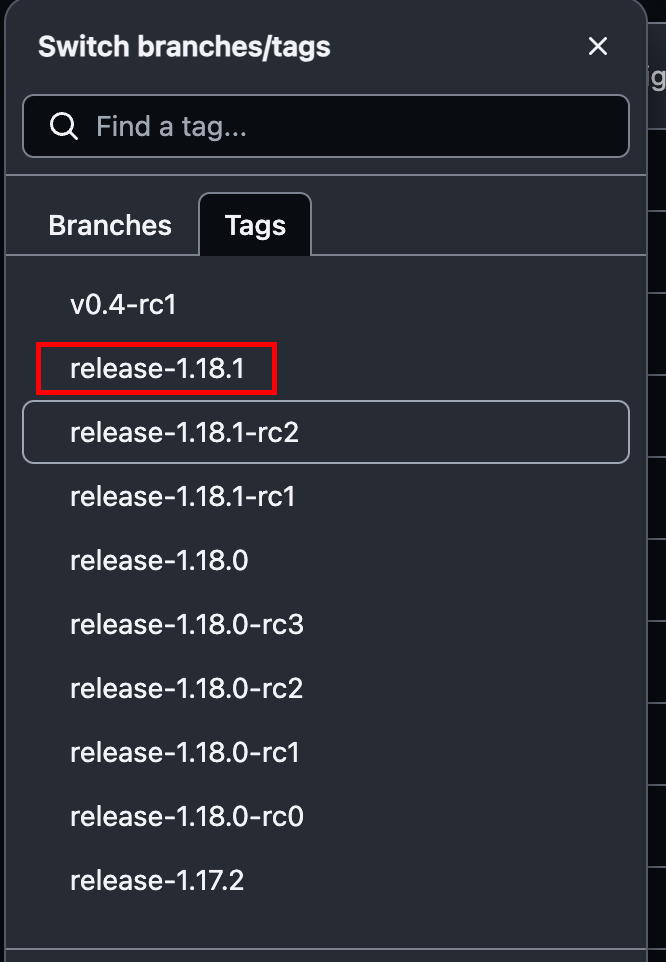

9.1.4 拓展案例 2:利用 GitHub Actions 实现 CI/CD

对于爬虫项目,自动化的持续集成和持续部署(CI/CD)流程可以极大地提高开发和部署的效率。使用 GitHub Actions,我们可以在代码提交到仓库时自动构建 Docker 镜像并部署到服务器。

# .github/workflows/deploy.yml

name: Deploy Spideron:push:branches:- mainjobs:build-and-deploy:runs-on: ubuntu-lateststeps:- uses: actions/checkout@v2- name: Build Docker imagerun: docker build . --tag my_scrapy_project- name: Deploy to Serveruses: appleboy/ssh-action@masterwith:host: ${{ secrets.SERVER_HOST }}username: ${{ secrets.SERVER_USER }}password: ${{ secrets.SERVER_PASSWORD }}script: |docker pull my_scrapy_projectdocker stop scrapy_container || truedocker run --rm -d --name scrapy_container my_scrapy_project

通过这些案例,我们可以看到,不同的部署策略适用于不同规模和需求的爬虫项目。无论是利用云服务平台的弹性资源,还是通过容器化和自动化工具简化部署流程,选择正确的部署策略都是爬虫项目成功的关键。

9.2 日志管理与错误处理

有效的日志管理和错误处理是维持爬虫项目长期健康运行的关键。它们像是船上的导航仪器,帮助你监控航行状况,及时发现并纠正航向。

9.2.1 重点基础知识讲解

- 日志管理:合理地记录日志,不仅可以帮助开发者追踪爬虫的行为和性能,还能在出现问题时提供宝贵的调试信息。日志级别、格式和存储策略应根据项目需求合理配置。

- 错误处理:有效的错误处理能够确保爬虫在遇到问题时不会直接崩溃,而是能够尝试恢复或至少安全地停止。包括网络请求失败、数据解析错误等情况的处理。

- 异常监控:对于生产环境的爬虫项目,实时监控异常并及时通知开发者是非常重要的。

9.2.2 重点案例:使用 Python logging 模块进行日志管理

配置爬虫项目的日志记录,包括设置日志级别、格式和输出位置。

import logging# 配置日志

logging.basicConfig(filename='spider.log',level=logging.INFO,format='%(asctime)s - %(levelname)s - %(message)s')# 在代码中记录日志

logging.info('爬虫启动')

try:# 爬虫抓取逻辑logging.info('数据抓取成功')

except Exception as e:logging.error('抓取过程出错', exc_info=True)

9.2.3 拓展案例 1:使用 Sentry 进行错误监控和通知

对于复杂的爬虫项目,在生产环境中实时监控错误并及时通知开发者是非常有用的。Sentry 是一个流行的错误监控平台,支持多种编程语言和框架。

import sentry_sdksentry_sdk.init(dsn="你的 Sentry DSN")try:# 爬虫抓取逻辑1 / 0 # 模拟一个错误

except Exception as e:sentry_sdk.capture_exception(e)

9.2.4 拓展案例 2:优雅地处理网络请求错误

在进行网络请求时,可能会遇到多种异常情况,如连接超时、服务器错误等。使用 requests 库时,可以通过捕获异常来优雅地处理这些错误。

import requests

from requests.exceptions import RequestException

import loggingurl = 'http://example.com'try:response = requests.get(url, timeout=5)response.raise_for_status() # 将 HTTP 错误转换为异常

except RequestException as e:logging.error(f'请求 {url} 时发生错误', exc_info=True)

通过这些方法,我们可以更好地管理爬虫项目的日志和错误,确保即使在遇到问题时也能够保持爬虫的稳定运行,及时修正问题,避免数据丢失或任务失败。有效的日志和错误处理机制是爬虫项目成功的重要保障。

9.3 爬虫性能监控与优化

为了确保你的爬虫能在数据的大海中迅速而稳定地航行,对其性能进行监控和优化是至关重要的。这就像是对你的船只进行定期的检查和维护,确保它能以最高效率运行。

9.3.1 重点基础知识讲解

- 性能监控:通过实时监控爬虫的关键性能指标(如请求速率、响应时间、成功率等),你可以及时发现并解决可能影响爬虫性能的问题。

- 资源利用率:监控CPU、内存和网络资源的使用情况,确保爬虫不会因资源消耗过多而影响所在服务器的其他应用。

- 响应时间与超时设置:优化网络请求的响应时间和适当设置超时参数,可以避免爬虫在等待慢响应的网页时浪费时间。

- 并发控制:合理设置爬虫的并发级别,既可以提高爬虫的抓取效率,也可以防止因请求过多而被目标网站封禁。

9.3.2 重点案例:使用 Prometheus 和 Grafana 监控爬虫性能

通过 Prometheus 收集爬虫的性能数据,使用 Grafana 创建仪表板展示这些数据,从而实现实时性能监控。

# 假设你已经在爬虫中集成了 Prometheus 客户端,以下是一个概念性代码示例

from prometheus_client import start_http_server, Summary

import random

import timeREQUEST_LATENCY = Summary('request_latency_seconds', 'Description of summary')@REQUEST_LATENCY.time()

def process_request(t):"""模拟请求处理"""time.sleep(t)if __name__ == '__main__':start_http_server(8000)while True:process_request(random.random())

9.3.3 拓展案例 1:调整并发设置以优化性能

在 Scrapy 爬虫中调整 CONCURRENT_REQUESTS 设置,根据目标网站的响应能力和爬虫服务器的资源情况来优化爬虫的并发水平。

# 在 Scrapy 的 settings.py 文件中调整

CONCURRENT_REQUESTS = 32 # 根据实际情况调整

9.3.4 拓展案例 2:自动调节爬虫速度

使用 Scrapy 的 AutoThrottle 扩展,根据目标网站的响应来动态调整爬虫的请求速度,既提高了爬虫的效率,又减少了被封禁的风险。

# 在 Scrapy 的 settings.py 文件中启用 AutoThrottle

AUTOTHROTTLE_ENABLED = True

AUTOTHROTTLE_START_DELAY = 1

AUTOTHROTTLE_MAX_DELAY = 60

AUTOTHROTTLE_TARGET_CONCURRENCY = 1.0

AUTOTHROTTLE_DEBUG = True

通过实施这些性能监控和优化措施,你的爬虫将能够更加高效、稳定地执行任务。性能优化是一个持续的过程,需要根据监控数据和实际运行情况不断调整策略。记住,一个高效的爬虫能够在同等资源下获取更多的数据,为你的数据分析和业务决策提供更强大的支持。