摘要 | Abstract

TO-BE-FILLED

前言 | Introduction

近期想深入了解HMM隐马尔可夫模型和DNN-HMM混合模型,但是尽管网络上有许多关于DNN-HMM的介绍,如李宏毅教授的《深度学习人类语言处理》[1],一些博主的语音识别系列文章[2],斯坦福大学HMM课件[3]。但是这些文章要么不够细致,要么对初学者来说过于复杂深奥(尤以HMM部分的琳琅满目的概率公式为首)。因此,本文旨在用通过通俗易懂的语言,为零基础者解析使用DNN-HMM混合方法的语音识别系统的底层原理(包括训练和推理两个部分)。

笔者希望让仅仅具备本科概率论基础的人也能读懂,如果你符合这个条件但仍觉得理解起来困难,你可以留下你的疑惑,以帮助我们改进文章。

问题描述 | Problem Statement

我们直入主题,语音识别模型是这样一个模型,它将一串语音信号(如一个仅包含语音的.wav音频文件)作为模型的输入,目的在于输出一个与之最为匹配的文字内容

(为了简化问题,本文只考虑英文场景,其它语言原理基本类似)。其中,当我们说“最为匹配”的时候,我们主要考虑的是“最有可能”的,亦即,语音识别模型希望在给定

时,给出

,使得:

上式意味着,我们要找使得最大的

,记作

。

要解决这个问题,一个最直观的办法就是穷举所有可能的,然后比一比他们的概率

,再选出最大的那一个。显然这个想法是不现实的,因为所有可能的

也许是一个无穷的集合。再者,就算能够缩小范围,枚举出大量比较可能的候选

,又如何比较概率

的大小呢?因而枚举法似乎不是好的选择。

HMM类的方法则选择使用贝叶斯理论对概率进行处理,这我们在后面会详细说明。在此之前,笔者想为大家介绍一下其它的更清晰的解决思路。

相关研究 | Related Work

得益于今日神经网络技术的快速发展,熟悉深度学习的我们很容易联想到,似乎只要利用大量的音频以及对应的文本标注进行训练,不需要额外的人工处理应该也能做到很好的泛化能力(即拿到新的语音信号时可以准确地给出真实的文字答案)吧?

答案是:确实有,这种办法被称为Listen Attend, and Spell,简称LAS[4]。它使用一个深度学习模型,直接用声音信号和人工标记的文字训练,在推理时听到新的声音信号就能给出它认为最匹配的文字内容。由于直接输入音频信号就能推理出其中的文字

,LAS被归为端到端(End to End)模型。

不得不说,LAS这种方法确实是最符合(机器学习研究者的)直觉的,就像其它任何的机器学习任务(如图像识别)一样,训练和推理再好理解不过了。

除了即将要介绍的HMM类模型,LAS、Transformer[5],还有CTC模型[6],RNN-T[7]等。这些内容不是本文的重点,就不一一介绍了。

尽管LAS等端到端模型操作非常简单无脑,但是在过去的很长一段时间内,这些堪称暴力的方法并没有想象中的那么强。至少在2020年时[1],商业语音识别系统的主力军还是咱们今天文章的主角DNN-HMM,同时DNN-HMM模型也是第一个被宣称达到人类同级别语音识别水平的模型。接下来我们就要展开介绍HMM类模型:GMM-HMM系统和DNN-HMM混合系统。

TO-BE-FILLED

参考资料

[1] 国立台湾大学李宏毅 (Hung-yi Lee)教授DLHLP2020课程,原网址:Hung-yi Lee (ntu.edu.tw) ,B站Speech Recognition (Option) - HMM_哔哩哔哩_bilibili

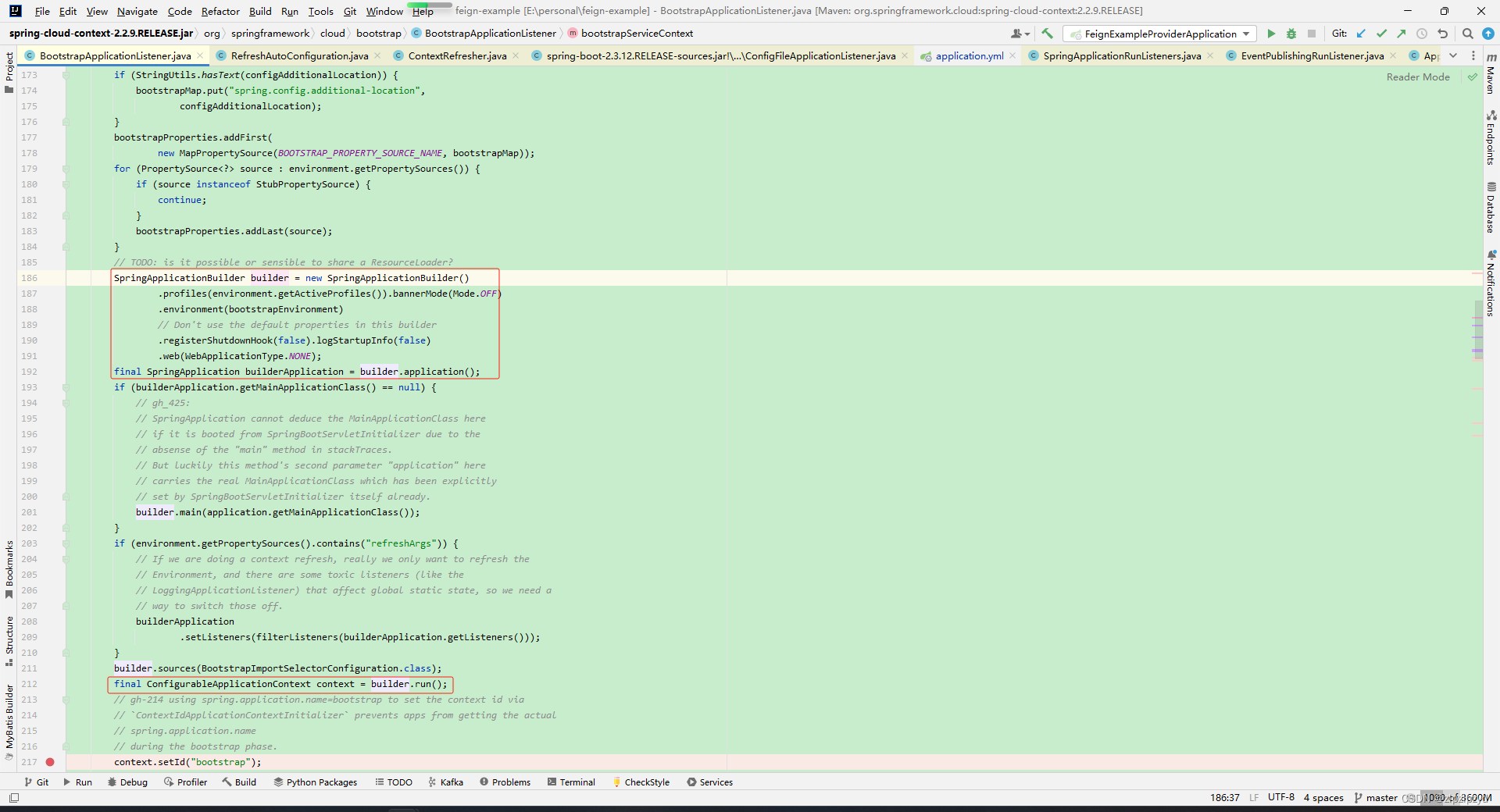

[2] 【AI大道理】AI大语音(十三)——DNN-HMM (深度解析)-CSDN博客

[3] Stanford University EE365: Hidden Markov Models hmm.pdf (stanford.edu)

[4] W. Chan, N. Jaitly, Q. Le and O. Vinyals, "Listen, attend and spell: A neural network for large vocabulary conversational speech recognition," 2016 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP), Shanghai, China, 2016, pp. 4960-4964, doi: 10.1109/ICASSP.2016.7472621.

[5] Linhao Dong, Shuang Xu, and Bo Xu. "Speech-transformer: a no-recurrence sequence-to-sequence model for speech recognition."2018 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). IEEE, 2018.

[6] Graves, Alex & Fernández, Santiago & Gomez, Faustino & Schmidhuber, Jürgen. (2006). Connectionist temporal classification: Labelling unsegmented sequence data with recurrent neural 'networks. ICML 2006 - Proceedings of the 23rd International Conference on Machine Learning. 2006. 369-376. 10.1145/1143844.1143891.

[7] Graves, Alex. “Sequence Transduction with Recurrent Neural Networks.” 2012 ArXiv abs/1211.3711