1. 学习与推断

基于概率图模型定义的分布,能对目标变量的边际分布(marginal distribution)或某些可观测变量

为条件的条件分布进行推断。对概率图模型,还需确定具体分布的参数,称为参数估计或学习问

题,通常使用极大似然估计或后验概率估计求解。单若将参数视为待推测的变量,则参数估计过程

和推断十分相似,可以“吸收”到推断问题中。

假设图模型所对应的变量集x={x1,x2,···,xn}能分为XE和XF两个不相交的变量集,推断问

题的目标就是计算边际概率p(XF)或者条件概率p(XF|XE)。同时,由条件概率定义容易有

其中,联合概率p(xF,xE)可基于图模型获得,所以推断问题的关键就在于如何高效计算边际分

布,即![]()

概率图模型的推断方法可以分两类:①精确推断方法:计算出目标变量的边际分布或条件分布的精

确值,一般情况下,该类方法的计算复杂度随极大团规模增长呈指数增长,适用范围有限。

②近似推断方法:在较低的时间复杂度下获得原问题的近似解,在实际问题中更常用。

1.1 精确推断:变量消去

精确推断实质是一种动态规划算法,利用图模型所描述的条件独立性来削减计算目标概率值所需的

计算量。变量消去是最直观的精确推断方法,也是构建其它精确推断算法的基础。

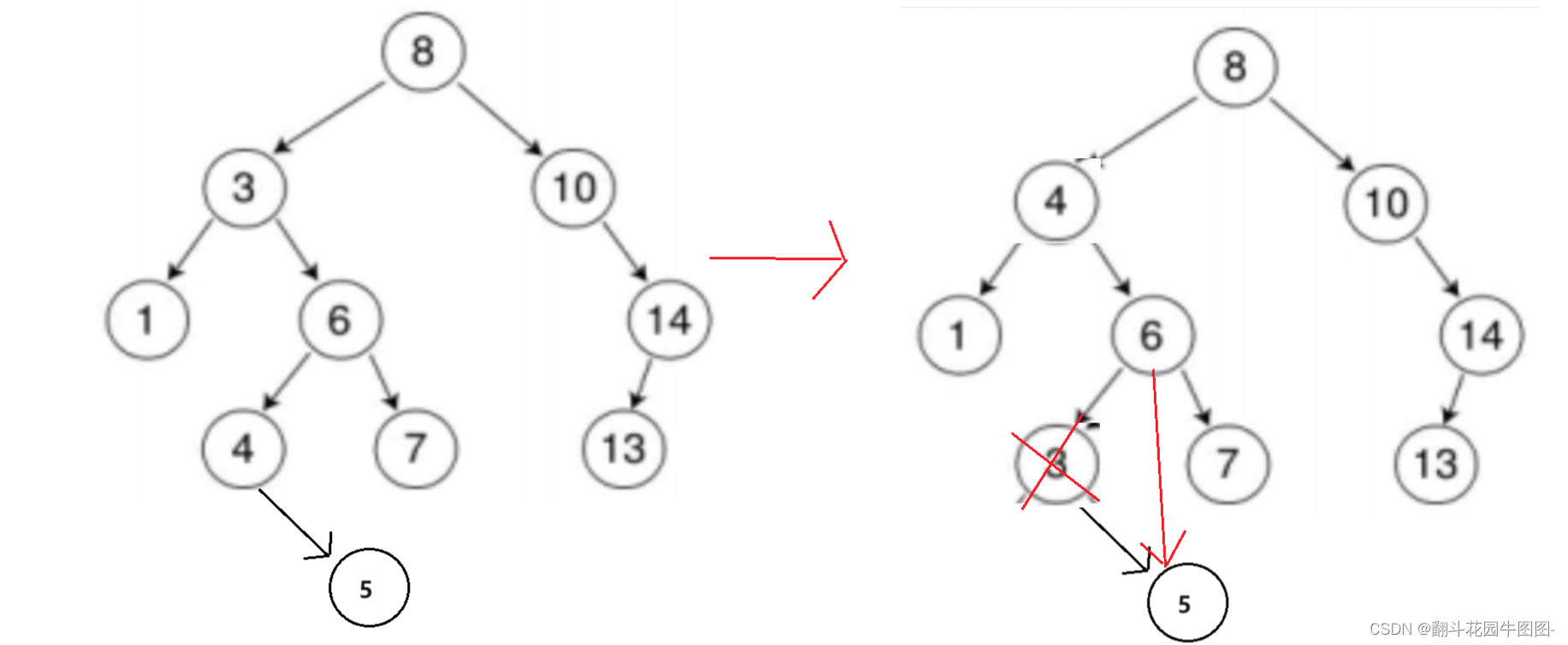

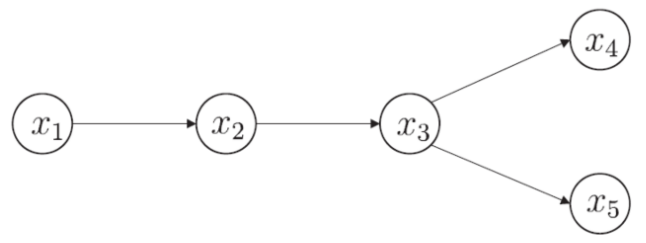

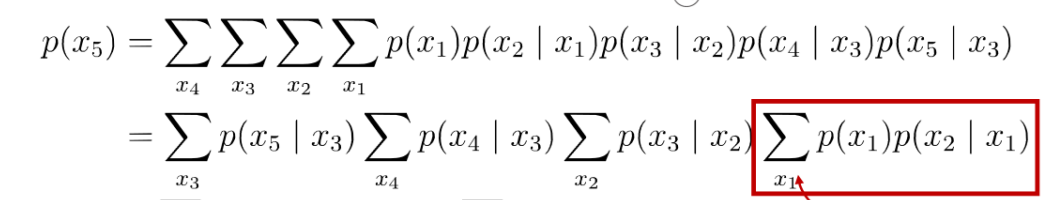

例:计算边缘概率p(x5)

mij(xj)是求加过程中的中间结果,下标 i 表示此项是对 xi 求加的结果,下标 j 表示此项中还剩余

的其它变量;显然,mij(xj)是关于 xj 的函数。

事实上,上述方法对无向图模型同样适用.不妨忽略图14.7(a)中的箭头,将其看作一个无向图

模型,有![]() 。

。

其中Z为规范化因子。边际分布P(x5)可这样计算:

![]()

![]()

![]()

![]()

变量消去法实际上是利用了乘法对加法的分配律,将对多个变量的积的求和问题转化为对部分变量

交替进行求积和求和的问题。这种转化使得每次的求和和求积运算被限制在局部,仅和部分变量有

关,从而简化了计算。

变量消去法有一个明显的缺点:若需计算多个边际分布,重复使用变量消去法将会造成大量的冗余

计算.例如在上图的贝叶斯网上,假定在计算P(x5)之外还希望计算P(x4),若采用{x1,

x2,x5,x3}的顺序,则m12(x2)和m23(x3)的计算是重复的。

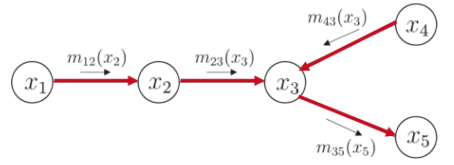

1.2 信念传播

计算多个边际分布,重复使用变量消去法会造成大量的冗余计算。利用信念传播(Belief

Propagation)方法避免冗余计算 。

信念传播(Belief Propagation)算法将变量消去法中的求和操作看作一个消息传递过程,较好地

解决了求解多个边际分布时的重复计算问题.具体来说,变量消去法通过求和操作。

消去变量xi,其中n(i)表示结点xi的邻接结点.在信念传播算法中,这个操作被看作从 xi 向 xj 传

递了一个消息mij(xj)。这样,描述的变量消去过程就能描述为上图所示的消息传递过程。不难发

现,每次消息传递操作仅与变量 xi 及其邻接结点直接相关,换言之,消息传递相关的计算被限制

在图的局部进行。

信念传播算法中,一个结点仅在接收到来自其它所有结点的消息后才能向另一个结点发送消息,且

结点的边际分布正比于它所接收的消息的乘积:![]()

例:下图中,结点x3要向x5发送消息,必须事先收到来自结点x2和x4的消息,且传递到x5的消息

m35(x5)恰为概率P(x5):

若图中没有环,则信念传播算法经过两个步骤即可完成所有消息传递,进而能计算所有变量上的边

际分布:指定一个根节点,从所有叶结点开始向根节点传递消息,直到根节点收到所有邻接结点的

消息;从根结点开始向叶结点传递消息,直到所有叶结点均收到消息 。

令x1为根结点,则x4和x5为叶结点。以上两步消息传递的过程如上图所示。此时图的每条边上都

有方向不同的两条消息,基于这些消息和![]() 即可获得所有变量的边际概率。

即可获得所有变量的边际概率。

2. 近似推断

精确推断方法需要很大的计算开销,因此在现实应用中近似推断方法更为常用。近似推断方法大致

可以分为两类:采样法(sampling):通过使用随机化方法完成近似,如MCMC采样;变分推断

(variational inference):使用确定性近似完成推断。

2.1 MCMC采样

很多任务中,我们关心的并非概率分布本身,而是基于概率分布的期望,并且还能基于期望进一步作出决策。若直接计算或逼近这个期望比推断概率分布更容易,则直接操作无疑将使推断问题更为高效。采样法基于这个思路,假定目标是计算函数f(x)在概率密度函数p(x)下的期望:

![]()

则可根据p(x)抽取一组样本![]() ,然后计算f(x)在这些样本上的均值

,然后计算f(x)在这些样本上的均值![]()

用于近似期望E[f],如果样本![]() 独立,基于大数定律,这种通过大量取样的方法就

独立,基于大数定律,这种通过大量取样的方法就

得到较高的近似精度,问题的关键就变成了如何取样,即如何高效地从图模型所描述的概率分布中

获取样本。

马尔可夫链蒙特卡罗(Markov Chain Monte Carlo, MCMC) 是图模型中最常用的采样技术。

给定连续变量x∈X的概率密度函数p(x),x在区间A中的概率为:![]()

若有函数f:X→R,可计算f(x)的期望:![]()

若x为高维多原变量且服从一个复杂分布,积分操作会很困难。MCMC先构造出服从p分布的独立

同分布随机变量![]() ,再得到无偏估计:

,再得到无偏估计:![]()

如何在概率分布复杂的情况下产生独立同分布的样本?

MCMC算法的关键在于通过“构造平稳分布为p的马尔可夫链”来产生样本:当马尔可夫链运行足够

长的时间(收敛到平稳状态),则产出的样本x近似服从p分布;并且通过多次重复运行、遍历马尔

可夫链就可以取得多个服从该分布的独立同分布样本。

判定马尔可夫链的平稳态:

假定马尔可夫链T的状态转移概率为T(x'|x),t时刻状态的分布为p(xt),则若在某个时刻马

尔可夫链满足平稳条件:![]()

则p(x)是该马尔可夫链的平稳分布,且马尔可夫链在满足该条件时已经收敛到平稳状态。

MCMC方法先设法构造一条马尔可夫链,使其收敛至平稳分布恰为待估计参数的后验分布,然后通

过该马尔可夫链产生样本,用这些样本进行估计。

MCMC中如何构造马尔可夫链的转移概率至关重要,不同构造方法产生不同的MCMC算法。

Metropolis-Hastings (MH)算法是MCMC(Markov Chain Monte Carlo)算法的代表之一。基于

“拒绝采样”逼近平稳分布。算法每次根据上一轮采样结果xt—1来采样获得候选状态样本x*,但这

个样本会以一定概率被拒绝。若从状态xt-1到状态x*的转移概率为![]() ,x*最

,x*最

终收敛到平稳状态,则:

为达到平稳状态,只需将接受率设置为:![]()

Metropolis-Hastings (MH) 算法:

2.2 吉布斯采样

吉布斯采样(Gibbs sampling)被视为MH算法的特例,也使用马尔可夫链获取样本,平稳分布也

是p(x)。具体来说,假定文本为![]() ,目标分布为p(x),在初始化x的取值后,通过

,目标分布为p(x),在初始化x的取值后,通过

循环下列步骤来完成采样:随机或以某个次序选取某变量xi,根据x中除xi外的变量的现有取值,计

算条件概率p(xi|xj),其中![]() 根据p(xi|xj)对变量xi采样,

根据p(xi|xj)对变量xi采样,

用采样值代替原值。

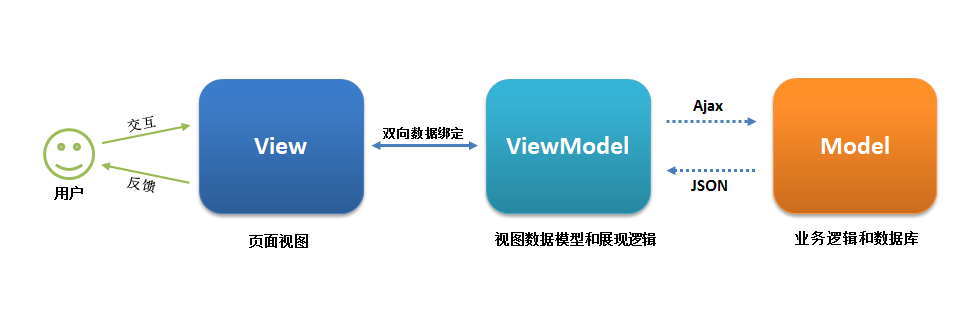

2.3 变分推断

变分推断通过使用已知简单分布来逼近需推断的复杂分布,并通过限制近似分布的类型,从而得到

一种局部最优、但具有确定解的近似后验分布。

图模型盘式记法(plate notation):相互独立的、由相同机制生成的多个变量被放在一个方框

(盘)内,并在方框中标出类似变量重复出现的个数N;方框可以嵌套;通常用阴影标注出已知

的、能观察到的变量。

图模型中,已知变量本![]() ,Θ是x与z服从的分布参数。所有能观察到的变量x的联合分

,Θ是x与z服从的分布参数。所有能观察到的变量x的联合分

布概率密度函数是:![]()

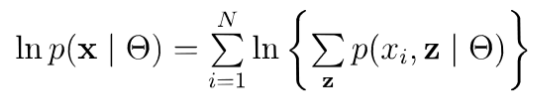

对应的对数似然:

推断和学习任务主要是由观察变量x来估计隐变量z和分布参数θ,即求解p(z|x,Θ)和Θ

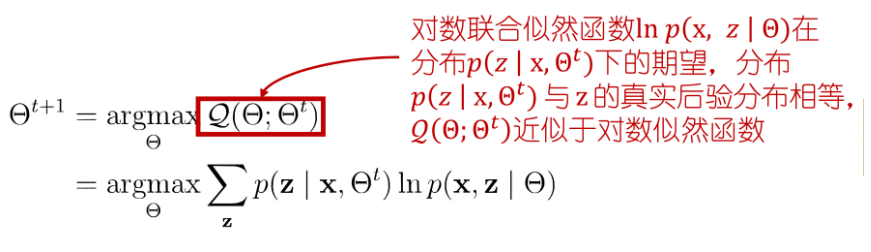

可使用EM算法最大化对数似然:

E步:根据t时刻的参数 θt 对![]() 进行推断,并计算联合似然函数

进行推断,并计算联合似然函数![]()

M步:基于E步结果进行最大化寻优,对关于变量θ的函数![]() 进行最大化从而求取:

进行最大化从而求取:

![]() 是隐变量z的近似分布,将这个近似分布用q(z)表示:

是隐变量z的近似分布,将这个近似分布用q(z)表示:

现实任务中,E部的推断可能很复杂。借助变分推断,简化q的形式(增加假设) ![]()

假设z的分布:![]()

假设复杂的多变量z可以拆解为一系列相互独立的多变量zi,同时令qi分布相对简单或有很好的结构

(如为指数族分布):

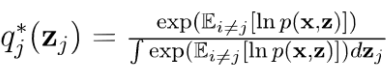

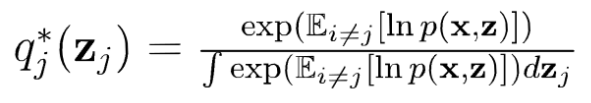

要得到qj,可固定qi≠j再对L(q)最大化,可发现上式等于![]() ,当

,当![]()

时L(q)最大,可得最优近似:![]()

变量子集zj所服从的最优分布qj*应满足:

因此,通过恰当分割变量子集zj并选择qi服从的分布,![]() 往往有闭式解,使得上式

往往有闭式解,使得上式

能对隐变量高效推断。

由于在对zj所服从的分布qj*估计时融合了zj之外的其它zi≠j的信息,这是通过联合似然函数Inp(x,

z)在zj之外的隐变量分布上求期望得到的,因此亦称为“平均场”(mean field)方法。

在实际应用中,最重要的是考虑如何对隐变量进行拆解,以及假设各变量子集服从何种分布,在此

基础之上结合EM算法对概率图模型进行推断和参数估计。

3. 话题模型

话题模型(topic model)是一类生成式有向图模型,主要用来处理离散型的数据集合(如文本集

合)。作为一种非监督产生式模型,话题模型能够有效利用海量数据发现文档集合中隐含的语义。

隐狄里克雷分配模型(Latent Dirichlet Allocation,LDA)是话题模型的典型代表。

LDA的基本单元:词(word):待处理数据中的基本离散单元;文档(document):待处理的数

据对象,由词组成,词在文档中不计顺序。数据对象只要能用“词袋”(bag—of—words)表示就可

以使用话题模型;话题(topic):表示一个概念,具体表示为一系列相关的词,以及它们在该概念

下出现的概率。

话题模型的构成:一个话题就像一个箱子,里面装着这个概念下出现概率较高的词。假定数据集中

一共包含K个话题和T篇文档,文档中的词来自一个包含N个词的字典。用T个N维向量W=

![]() 表示文档集合。用K个N维向量βk表示话题。

表示文档集合。用K个N维向量βk表示话题。![]() 的第n个分量Wt,n

的第n个分量Wt,n

表示文档t中词n的词频,![]() 的第n个分量βk,n表示话题k中词n的词频。

的第n个分量βk,n表示话题k中词n的词频。

文档的生成过程:现实任务中通过统计文档中出现的词来获得词频向量wi;LDA从生成式模型的角

度看待文档和话题,认为每篇文档包含多个话题。用![]() 表示文档t中所包含的每个话题的比

表示文档t中所包含的每个话题的比

例,![]() 表示文档t中包含话题k的比例。

表示文档t中包含话题k的比例。

LDA的图模型表示:生成文档t,从以α为参数的狄利克雷分布中随机采样一个话题分布Θt;按如下

步骤产生文档中的N个词,根据θt进行话题指派,得到文档t中词n的话题Zt,n;根据指派的话题所对

应的的词分布βk随机采样生成词。生成的文档以不同比例包含多个话题,文档中的每个词来自于一

个话题,这个话题是根据话题比例产生的

词频wt,n是唯一已观测变量,依赖于话题指派zt,n及话题对应词频βk,话题指派zt,n依赖于话题分

布Θt,Θt依赖于α,话题词频依赖于参数η。

LDA的基本问题:

①模型参数估计:给定训练数据![]() ,参数通过极大似然法估计,寻找α和η以最大

,参数通过极大似然法估计,寻找α和η以最大

化对数似然(通常采用变分法求取近似解)

②模型推断:模型已知,参数α和η已确定,根据词频来推断文档话题结构,可通过求解(分母常

采用吉布斯采样或变分法进行推断)。