导读

导读

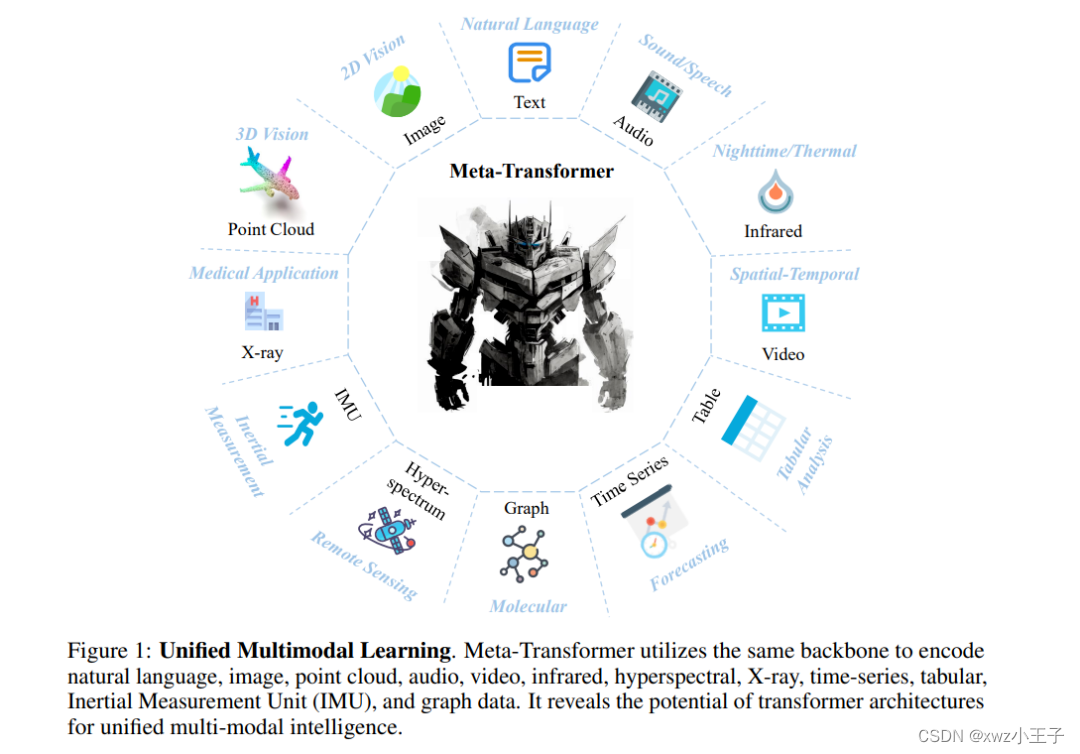

设计一个统一的网络来处理各种模态(例如自然语言、2D图像、3D点云、音频、视频、时间序列和表格数据)是一项极具挑战性的工作。

本文提出了一个名为Meta-Transformer的框架,利用一个冻结的编码器在没有任何成对多模态训练数据的情况下执行多模态感知。在Meta-Transformer中,来自各种模态的原始输入数据被映射到共享的标记(token)空间,并允许一个后续的编码器使用冻结参数来提取输入数据的高级语义特征。Meta-Transformer由三个主要组件组成:统一的数据标记器、模态共享编码器,和用于下游任务的任务特定头。

它是第一个能够在12种不同的模态之间进行统一学习,并无需成对多模态数据训练的框架。在不同的基准测试上的实验证明,Meta-Transformer能够处理广泛的任务,包括基本感知任务(文本、图像、点云、音频、视频)、实际应用(X射线、红外线、高光谱和惯性测量单元IMU)、以及数据挖掘任务(图形、表格和时间序列)。Meta-Transformer为使用Transformer进行统一的多模态智能开发奠定了基础。

引言

人类大脑作为神经网络模型的灵感来源,可以同时处理来自各种感官输入(如视觉、听觉和触觉信号)。然而在深度学习中,由于存在显著的模态差距,设计一个能够处理广泛数据格式的统一网络是一项非常复杂的任务。

不同的数据模态呈现出独特的数据模式,例如,图像由于像素密集而呈现高度的信息冗余,而自然语言则不然。而3D点云在3D空间中呈现稀疏分布,使其更容易受到噪声干扰,且难以表示。音频频谱图是随时间变化的非平稳数据模式,由频率域中的波形组合而成。视频数据包含一系列图像帧,使其具有同时捕捉空间信息和时间动态的独特能力。图形数据以图中的节点表示实体,边表示实体之间的关系,建模复杂的多对多关系。由于不同数据模态之间的显著差异,常见的做法是使用不同的网络架构单独编码每个模态。

文章指出,最近发展的统一框架(如上表1,VLMO、OFA和BEiT-3)通过在成对数据上进行大规模多模态预训练,改善了网络的多模态理解能力,但它们更关注视觉和语言,并且无法跨模态共享整个编码器。因此,设计一个能够利用共享模态参数空间来编码多个数据模态的统一框架仍然是一个重大挑战。

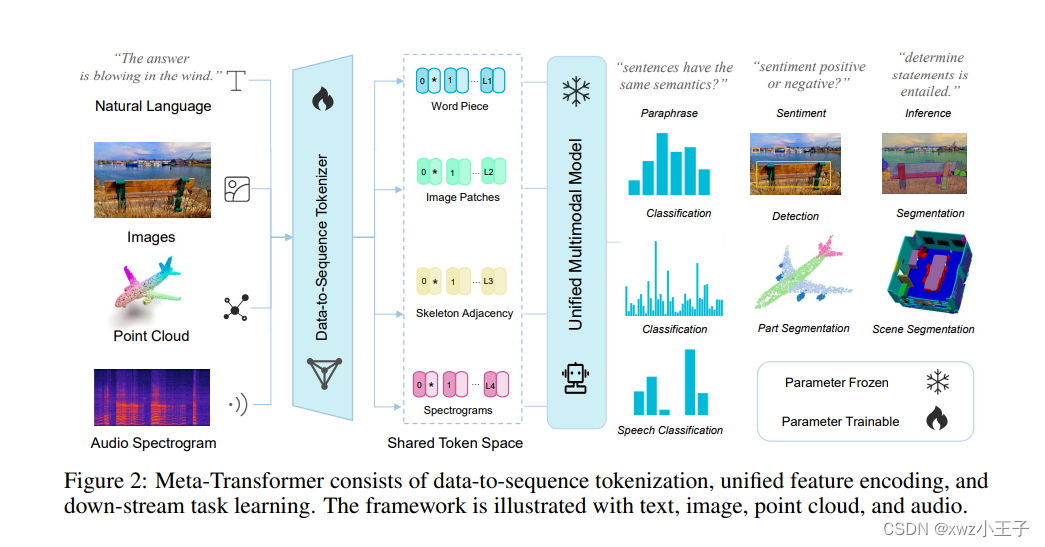

为了实现这一目标,作者提出了名为Meta-Transformer的新型统一框架,旨在处理12种不同的数据模态,包括图像、自然语言、点云、音频频谱图、视频、红外线、高光谱、X射线、IMU、表格、图形和时间序列数据。Meta-Transformer采用三个简单而有效的组件:模态专家用于将数据转化为序列化的标记,模态共享编码器用于提取跨模态的表示,以及用于下游任务的任务特定头部。 具体来说,Meta-Transformer首先将多模态数据转换为共享的标记序列,然后使用冻结参数的模态共享编码器提取表示,并通过更新下游任务头部和轻量级标记器的参数进一步适应到各个任务中。这个简单的框架可以有效地学习任务特定和模态通用的表示。

作者在12个模态的各种基准测试上进行了大量实验,通过专门使用LAION-2B数据集的图像进行预训练,Meta-Transformer在处理多模态数据方面表现出色,在不同的多模态学习任务中始终优于现有方法。这些实验证明了Meta-Transformer在统一多模态学习方面的潜力。

方法

如上图2所示,Meta-Transformer由三个组件组成:一个将数据转化为序列的标记器,一个用于编码不同模态嵌入的模态通用编码器,以及用于执行下游预测的任务特定头部。

初步定义

将n个数据模态的输入空间表示为

,相应的标签空间为。此外,我们假设对于每个模态都存在一个有效的参数空间,其中任何参数都可以用于处理来自该模态的数据。我们说,Meta-Transformer的本质是找到一个共享的参数

,满足以下条件:

并且假设共享的参数空间非空:

多模态神经网络可以表示为统一的映射函数:

,其中是来自任何模态的输入数据,表示网络的预测结果。我们将实际标签表示为

,多模态处理流程可以表示为:

在这个公式中,

代表预测值与实际标签之间的损失函数。Meta-Transformer的目标是通过优化参数

来最小化预测值与实际标签之间的损失,并同时保持多个模态之间的共享参数空间。这样,Meta-Transformer能够实现在多个数据模态上进行统一的学习和预测。

数据序列化Tokenization

那么如何对不同模态的数据(文本,图像,点云和音频等)转换为共享嵌入空间中的embedding呢?

自然语言

在处理文本数据时,作者采用了常见的做法,使用WordPiece嵌入,并使用了30,000个标记的词汇表。WordPiece将原始单词分割为子词。例如原始句子:“The supermarket is hosting a sale”,在WordPiece中可能被转换为:“_The _super market _is _host ing _a _sale”。这里,单词"supermarket"被分成两个子词"_super"和"market",单词"hosting"被分成"host"和"ing",而其他单词保持不变。每个子词对应于词汇表中的一个唯一标记,然后通过词嵌入层将其投影到高维特征空间,从而将每个输入文本转换为一组令牌嵌入

,其中 n 是标记的数量, D 是嵌入的维度。

图像

为了处理2D图像,作者将图像

重塑为一系列扁平化的2D图像块,其中 (H, W) 表示原始图像的分辨率, C 表示通道数, S 表示图像块的大小,

表示最终图像块的数量。然后,使用一个投影层将嵌入的维度投影为 D:

点云

为了利用transformers学习3D模式,作者将点云从原始输入空间转换为token embedding空间。点云

表示P个点的点云,其中,表示第i个点的3D坐标,是第i个点的特征。通常,

包含了视觉提示,比如颜色、视角、法线等。作者使用最远点采样(Farthest Point Sampling,FPS)操作,以固定的采样比例(1/4)对原始点云进行采样,然后使用K最近邻(K-Nearest Neighbor,KNN)方法对邻近点进行分组。在构建具有局部几何先验信息的组合集合的基础上,构建邻接矩阵,使用聚集操作得到来自K个子集的结构表示。最终,得到点云的embedding:

音频谱图

首先,对音频波形进行预处理,使用对数Mel滤波器组,然后采用汉明窗口对频率进行分割,将原始波形分割为

维的滤波器组。随后,将频谱图从时间和频率维度划分为大小为的补丁。与图像不同,音频补丁(patches)在频谱图上是重叠的。作者选择将整个频谱图划分为个补丁,通过

卷积,然后将补丁展平为令牌token序列。最终,得到音频谱图的embedding:

通过将这些不同模态的数据转换为共同的token embedding space,Meta-Transformer便可以在多个数据模态上实现统一的学习和预测。

统一编码器

在将原始输入转换为token embedding space后,作者采用一个带有冻结参数的统一Transformer编码器来对来自不同模态的令牌嵌入序列进行编码。

预训练

作者使用ViT作为主干网络,并在LAION-2B数据集上进行对比学习的预训练,以增强通用令牌编码的能力。预训练之后,作者冻结主干网络的参数。此外,在文本理解方面,作者使用CLIP的预训练文本标记器,将句子分割为子词,并将子词转换为词嵌入。

模态不可知学习

作者在令牌嵌入序列的开头添加一个可学习的令牌

,而(x_{CLS})令牌的最终隐藏状态

用作输入序列的摘要表示,通常用于执行识别任务。为了加强位置信息,作者将位置嵌入(embedding)引入到令牌嵌入中。考虑到我们将输入数据令牌化为1D嵌入,因此采用了标准的可学习的1D位置嵌入。此外,对于图像识别任务,采用更复杂的2D-aware位置嵌入并未观察到明显的性能改进。作者简单地将位置嵌入与内容嵌入进行逐元素加法操作,然后将得到的嵌入序列输入到编码器中。

Transformer编码器的深度为L,由多个堆叠的多头自注意力(MSA)层和MLP块组成。

特定任务头

在得到学习表示后,我们将这些表示送入特定任务头

,该头部主要由MLP组成,并根据不同的模态和任务而变化。Meta-Transformer的学习目标可以总结为:

其中,

、和

分别表示标记器、主干网络和头部的函数。

在此公式中,

表示模型的预测输出,是实际标签,表示要优化的参数,是预测输出和真实标签之间的损失函数,目标是最小化损失函数,从而优化模型参数,使其能够更好地预测输出。整个学习过程是通过将输入数据经过tokenization得到,然后输入到主干网络中得到学习表示,最后通过特定任务头对学习表示进行进一步处理,从而得到最终的预测输出

。

实验结果

局限性

复杂性:Meta-Transformer需要处理令牌嵌入,其计算复杂度为。高昂的内存成本和沉重的计算负担使其难以扩展。

方法论:与TimeSformer和Graphormer中的Axial Attention机制相比,Meta-Transformer缺乏时间和结构意识。这个限制可能会影响Meta-Transformer在涉及时间和结构建模起关键作用的任务中的整体性能,比如视频理解、视觉跟踪或社交网络预测等任务。

应用:Meta-Transformer主要在多模态感知方面展现其优势。关于它在跨模态生成方面的能力目前尚不清楚。作者将在未来的研究中继续探索这个问题。

结论

本文中,我们探索了纯Transformer在统一多模态学习方面的潜力,并突显了使用Transformer主干网络开发统一多模态智能的有希望趋势。在某种程度上,本文支持了Transformer在下一代网络中的主导地位。重要的是,卷积神经网络(CNNs)和多层感知机(MLPs)并没有被遗弃。它们在数据tokenization和表示投影中扮演着重要角色。 这个过程体现了神经网络中的继承规律以及人工智能的持续演进历程。